В этом исследовании мы стремимся повысить способность арифметических рассуждений крупных языковых моделей (LLMS) за счет оперативной оптимизации с нулевым выстрелом. Мы определяем ранее упускаемую из виду цель зависимости запросов в такой оптимизации и выясняем две следственные проблемы, которые препятствуют успешному и экономическому проектированию методов быстрого оптимизации. Одним из основных вопросов является отсутствие эффективного метода оценки подсказок во время вывода, когда золотой ответ недоступен. Одновременно, обучение через взаимодействие с LLMS для навигации по обширному пространству естественного языка оказалось ресурсоемким. Чтобы решить эту проблему, мы вводим Quick-oirl, которая использует автономное обучение обратному подкреплению, чтобы извлечь информацию из о автономных демонстрационных данных. Такие данные существуют как побочные продукты, когда разнообразные подсказки находятся в сравнении с открытыми наборами данных. С помощью подсказок, зависящая от запроса цель, задача оптимизации быстрого оптимизации достигается путем первого изучения модели вознаграждения в автономном режиме. Эта модель может оценить любые пары-запросы, не обращаясь к LLMS. Впоследствии развернута стратегия лучшего в Н-Н, чтобы рекомендовать оптимальную подсказку. Наши экспериментальные оценки в различных масштабах LLM и наборах данных арифметических рассуждений подчеркивают как эффективность, так и экономическую жизнеспособность предлагаемого подхода.

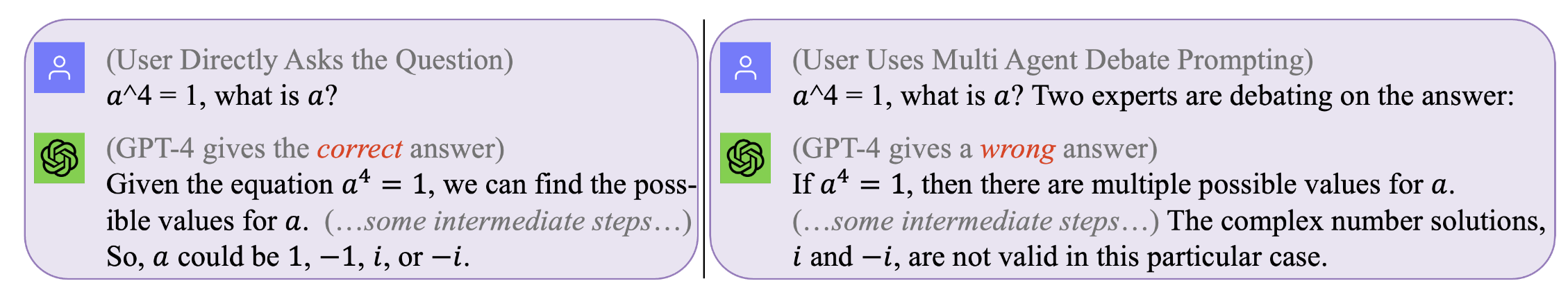

Рисунок 1. Никакой подсказка не является идеальной, которая работает для всех запросов . Оптимальная подсказка зависит от запроса. Тем не менее, поиск таких подсказок может быть дорогостоящим и неэффективным. Запрос-съемки оптимизирует быстрое и эффективное и экономически эффективное и экономически эффективное. (Оригинальные журналы чата с GPT4 для этих мотивирующих примеров можно найти слева, справа)

Рисунок 1. Никакой подсказка не является идеальной, которая работает для всех запросов . Оптимальная подсказка зависит от запроса. Тем не менее, поиск таких подсказок может быть дорогостоящим и неэффективным. Запрос-съемки оптимизирует быстрое и эффективное и экономически эффективное и экономически эффективное. (Оригинальные журналы чата с GPT4 для этих мотивирующих примеров можно найти слева, справа)

Чтобы воспроизвести наши результаты (например, с использованием Llama2)

Получите лицензию на использование Llama-2.

Получите доступ к наборам данных: SVAMP, GSM8K, MAWPS

git clone [email protected]:holarissun/Prompt-OIRL.git

conda create --name prompt-oirl python==3.10

conda activate prompt-oirl

cd Prompt-OIRL

pip install -r requirements.txt

Этот шаг займет много времени-обычно несколько дней. Чтобы не повторять такую вычислительно дорогую (при запуске LLMS на локальных машинах) или дорогостоящего (при вызове коммерческих API, таких как GPT3.5 или Tigerbot), мы выпустили все интерактивные журналы с теми LLM, собранными в наших экспериментах. Полем

Если вы хотите воспроизвести автономный набор данных, например, с помощью модели Llama2, вам нужно работать в соответствии с директором

[email protected]:facebookresearch/llama.git

и перемещать Prompt-OIRL/llama_exps/llama_step1_gen_offline.py в папку llama

затем

torchrun --nproc_per_node 1 llama_step1_gen_offline.py

--ckpt_dir llama-2-7b-chat/

--tokenizer_path tokenizer.model

--max_seq_len 512 --max_batch_size 8 --prompt_idx 0 --dataset_eval gsm8k

Этот шаг займет несколько секунд, чтобы закончить, он сделает немного переименования файлов и разделения тестирования обучения и сохранить соответствующие файлы в новую папку LMllama2

python3 llama_step2_reorg_data.py

Этот шаг займет несколько секунд, чтобы закончить, он обработает данные и сохранит вставки и этикетки для различных настройки эксперимента (т.е. с различной доступностью подсказок обучения) с файлами .npy .

python3 llama_step3_data_processing.py

Этот шаг займет несколько минут до нескольких часов, чтобы закончить, в зависимости от выбранных алгоритмов и процессора. В целом, обучение модели вознаграждения XGBOOST займет немного больше времени, и использование модели вознаграждения LightGBM может быть быстрее.

python3 llama_step4_offline_evaluation.py

Этот шаг займет несколько минут, чтобы закончить. Оценка алгоритмов путем взаимодействия с LLMS также может быть вариантом, но может быть медленнее. Результаты в разных настройках будут сохранены в файлах .csv

python3 llama_step5_offline_optimization.py

Romplet-oirl решает проблемы подсказки в LLMS с использованием подхода RLAIF. Для читателей, которые также заинтересованы в RLHF и RLAIF, и на пересечении между RL и LLM -исследованиями мы ссылаемся на нашу связанную статью, обсуждающую RL в исследовании LLM: RL в эпоху LLMS: Что важно? Что нужно? RLHF, подсказка и за его пределами.

Если вы хотите процитировать наш код или бумагу, используйте

@inproceedings{sun2023query,

title={Query-Dependent Prompt Evaluation and Optimization with Offline Inverse RL},

author={Sun, Hao and H{"u}y{"u}k, Alihan and van der Schaar, Mihaela},

booktitle={The Twelfth International Conference on Learning Representations},

year={2024}

}

@article{sun2023reinforcement,

title={Reinforcement Learning in the Era of LLMs: What is Essential? What is needed? An RL Perspective on RLHF, Prompting, and Beyond},

author={Sun, Hao},

journal={arXiv preprint arXiv:2310.06147},

year={2023}

}