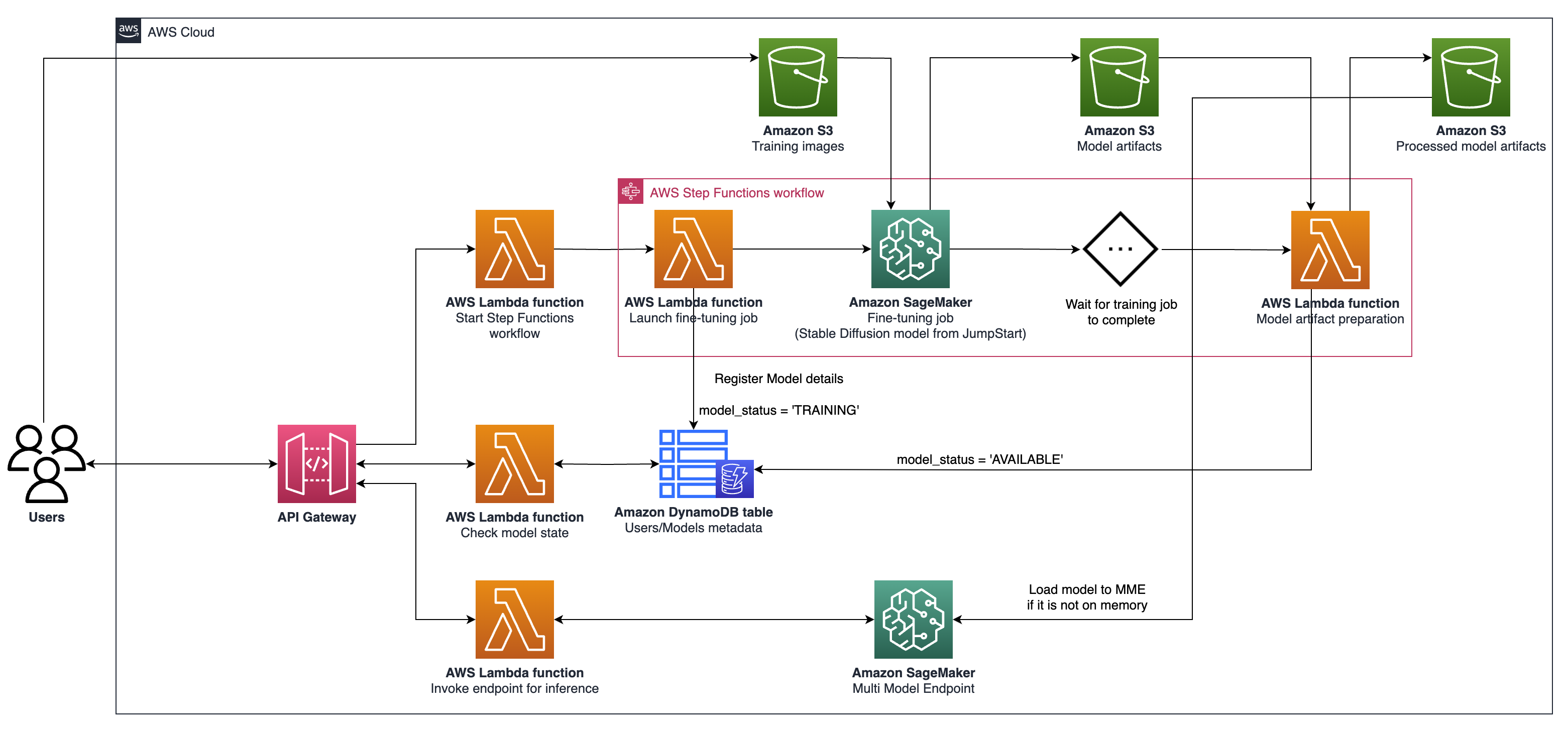

該項目可以在AWS上大規模地進行微觀個性化的生成AI模型的微調和服務。我們滿足了SaaS提供商和B2C初創公司的需求,希望快速擴展擴展。我們提出了一種利用亞馬遜薩吉式製造商的體系結構來簡化AI模型進行微調和部署,實現更快的開發,提高服務質量和成本效益;以及用於實時託管的多模型端點(MME),它們提供了一種可擴展,低延節和具有成本效益的方式,以在單個端點後面部署數千個深度學習模型。有關更多詳細信息,請參閱此博客文章。

npm install -g aws-cdk CDKhttps://python-poetry.org/docs/#installation詩歌安裝Linux,MacOS,Windows(WSL)

curl -sSL https://install.python-poetry.org | python3 -用詩歌安裝依賴

poetry install

設置python env在外殼中

poetry shell

此時,您現在可以合成此代碼的雲形式模板。

$ cdk synth

要添加其他依賴關係,例如其他CDK庫,只需使用poetry add yourpackage

cdk ls列表應用中的所有堆棧cdk synth排放合成的雲形式模板cdk deploy此堆棧到您的默認AWS帳戶/區域cdk diff將部署的堆棧與當前狀態進行比較cdk docs打開CDK文檔所描述的架構涉及用於生成AI用例的系統,以穩定的擴散V2-1為例,重點側重於個性化的文本對圖像生成。該體系結構的關鍵組成部分如下:

Sagemaker培訓和託管API :這些API提供了完全管理的培訓工作和模型部署功能。它們使快速移動的團隊能夠更多地專注於產品功能和差異化。遵循“啟動”範式的Sagemaker培訓工作適用於用戶入職時瞬態並發模型微調作業。

啟用GPU的託管:SageMaker支持啟用GPU的託管選項,以大規模部署深度學習模型。這包括將NVIDIA Triton推理服務器集成到SageMaker生態系統中。 SageMaker還為多模型端點(MME)提供GPU支持,該支持允許在單個端點後面部署數千個深度學習模型,從而確保可伸縮性,低延遲和成本效益。

基礎架構級別:在基礎架構級別,該體系結構依賴於一流的計算選項,例如配備NVIDIA A10G tensor Core GPU的G5實例類型(AWS獨有)。此實例類型為模型培訓和託管提供了有利的價格績效比率,每美元提供有效的計算功率。

該體系結構特別適合文本形像生成用例。它將解決方案工作流程分為兩個主要階段:

A階段(用戶入職) :在此階段,用戶可以請求創建一個或多個自定義,微調模型。他們可以始終檢查模型的可用性狀態,以了解訓練何時完成。

B階段(按需推斷) :微調後,該模型可以通過最終用戶進行按需實時圖像生成。

要與使用AWS CDK部署的API網關進行交互,請按照以下步驟:

打開郵遞員並從文件夾documentation導入集合。

設置請求方法(例如,獲取,發布)並輸入API網關URL端點。

如果您的API需要身份驗證,請配置必要的標題或令牌。

添加任何必需的請求參數或數據。

單擊“發送”以提出請求並接收回复。

注意:確保正確配置您的AWS資源和API網關以處理請求。