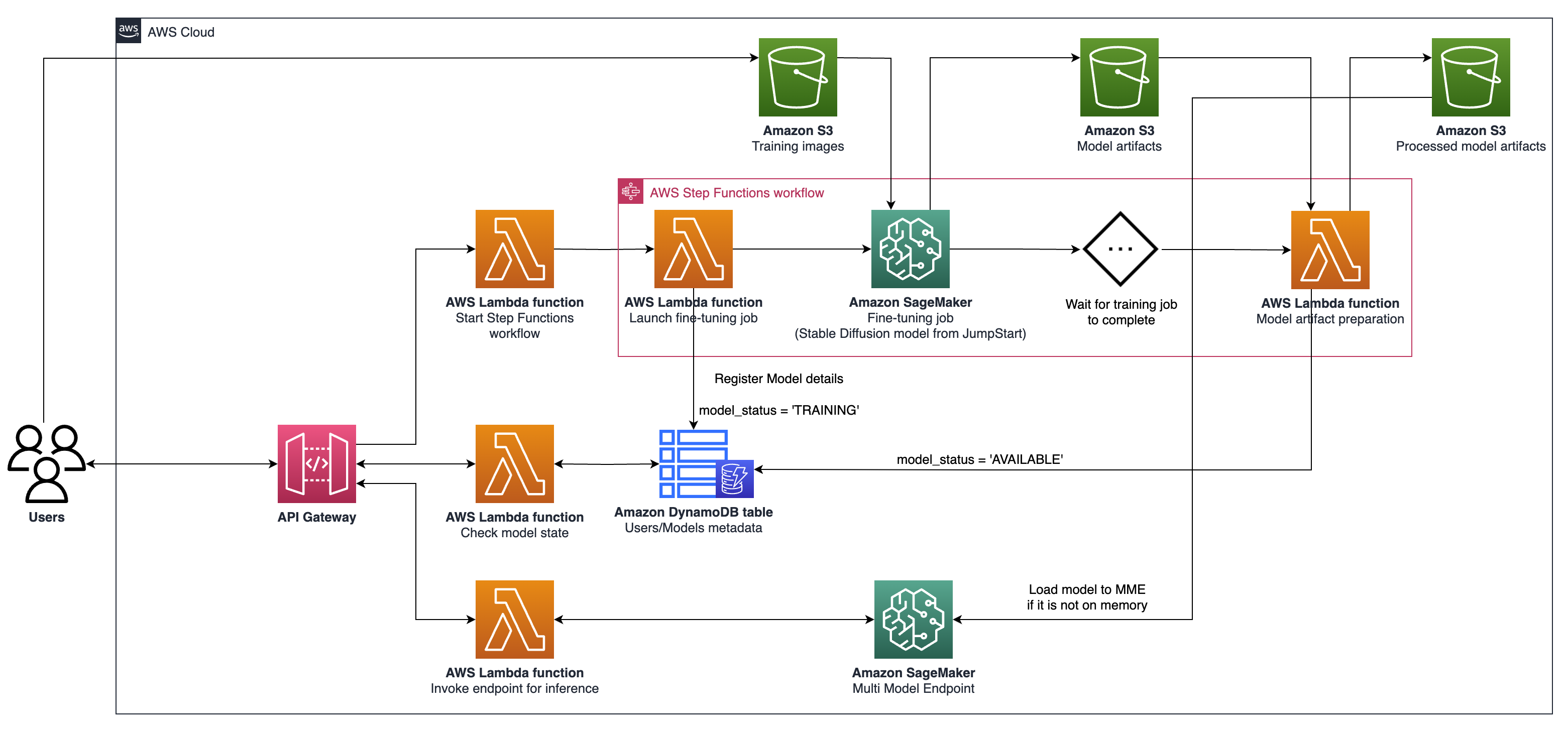

该项目可以在AWS上大规模地进行微观个性化的生成AI模型的微调和服务。我们满足了SaaS提供商和B2C初创公司的需求,希望快速扩展扩展。我们提出了一种利用亚马逊萨吉式制造商的体系结构来简化AI模型进行微调和部署,实现更快的开发,提高服务质量和成本效益;以及用于实时托管的多模型端点(MME),它们提供了一种可扩展,低延节和具有成本效益的方式,以在单个端点后面部署数千个深度学习模型。有关更多详细信息,请参阅此博客文章。

npm install -g aws-cdk CDKhttps://python-poetry.org/docs/#installation诗歌安装Linux,MacOS,Windows(WSL)

curl -sSL https://install.python-poetry.org | python3 -用诗歌安装依赖

poetry install

设置python env在外壳中

poetry shell

此时,您现在可以合成此代码的云形式模板。

$ cdk synth

要添加其他依赖关系,例如其他CDK库,只需使用poetry add yourpackage

cdk ls列表应用中的所有堆栈cdk synth排放合成的云形式模板cdk deploy此堆栈到您的默认AWS帐户/区域cdk diff将部署的堆栈与当前状态进行比较cdk docs打开CDK文档所描述的架构涉及用于生成AI用例的系统,以稳定的扩散V2-1为例,重点侧重于个性化的文本对图像生成。该体系结构的关键组成部分如下:

Sagemaker培训和托管API :这些API提供了完全管理的培训工作和模型部署功能。它们使快速移动的团队能够更多地专注于产品功能和差异化。遵循“启动”范式的Sagemaker培训工作适用于用户入职时瞬态并发模型微调作业。

启用GPU的托管:SageMaker支持启用GPU的托管选项,以大规模部署深度学习模型。这包括将NVIDIA Triton推理服务器集成到SageMaker生态系统中。 SageMaker还为多模型端点(MME)提供GPU支持,该支持允许在单个端点后面部署数千个深度学习模型,从而确保可伸缩性,低延迟和成本效益。

基础架构级别:在基础架构级别,该体系结构依赖于一流的计算选项,例如配备NVIDIA A10G tensor Core GPU的G5实例类型(AWS独有)。此实例类型为模型培训和托管提供了有利的价格绩效比率,每美元提供有效的计算功率。

该体系结构特别适合文本形象生成用例。它将解决方案工作流程分为两个主要阶段:

A阶段(用户入职) :在此阶段,用户可以请求创建一个或多个自定义,微调模型。他们可以始终检查模型的可用性状态,以了解训练何时完成。

B阶段(按需推断) :微调后,该模型可以通过最终用户进行按需实时图像生成。

要与使用AWS CDK部署的API网关进行交互,请按照以下步骤:

打开邮递员并从文件夹documentation导入集合。

设置请求方法(例如,获取,发布)并输入API网关URL端点。

如果您的API需要身份验证,请配置必要的标题或令牌。

添加任何必需的请求参数或数据。

单击“发送”以提出请求并接收回复。

注意:确保正确配置您的AWS资源和API网关以处理请求。