Este projeto permite o ajuste fino e a porção de modelos generativos de IA hiper-personalizados em escala na AWS. Atendemos às necessidades dos provedores de SaaS e startups B2C que desejam escalar rapidamente. Propomos uma arquitetura que aproveita a Amazon Sagemaker para otimizar o modelo de ajuste e implantação do modelo de IA, permitindo desenvolvimento mais rápido, melhor qualidade de serviço e custo-efetividade; e terminais de vários modelos (MMEs) para hospedagem em tempo real, que fornecem uma maneira escalável, de baixa latência e econômica de implantar milhares de modelos de aprendizado profundo por trás de um único terminal. Para mais detalhes, consulte esta postagem do blog.

npm install -g aws-cdkhttps://python-poetry.org/docs/#installationPoesia Instale Linux, MacOS, Windows (WSL)

curl -sSL https://install.python-poetry.org | python3 -Instale dependências com poesia

poetry install

Configure python Env em shell

poetry shell

Neste ponto, agora você pode sintetizar o modelo de formação de nuvem para este código.

$ cdk synth

Para adicionar dependências adicionais, por exemplo, outras bibliotecas CDK, basta usar poetry add yourpackage

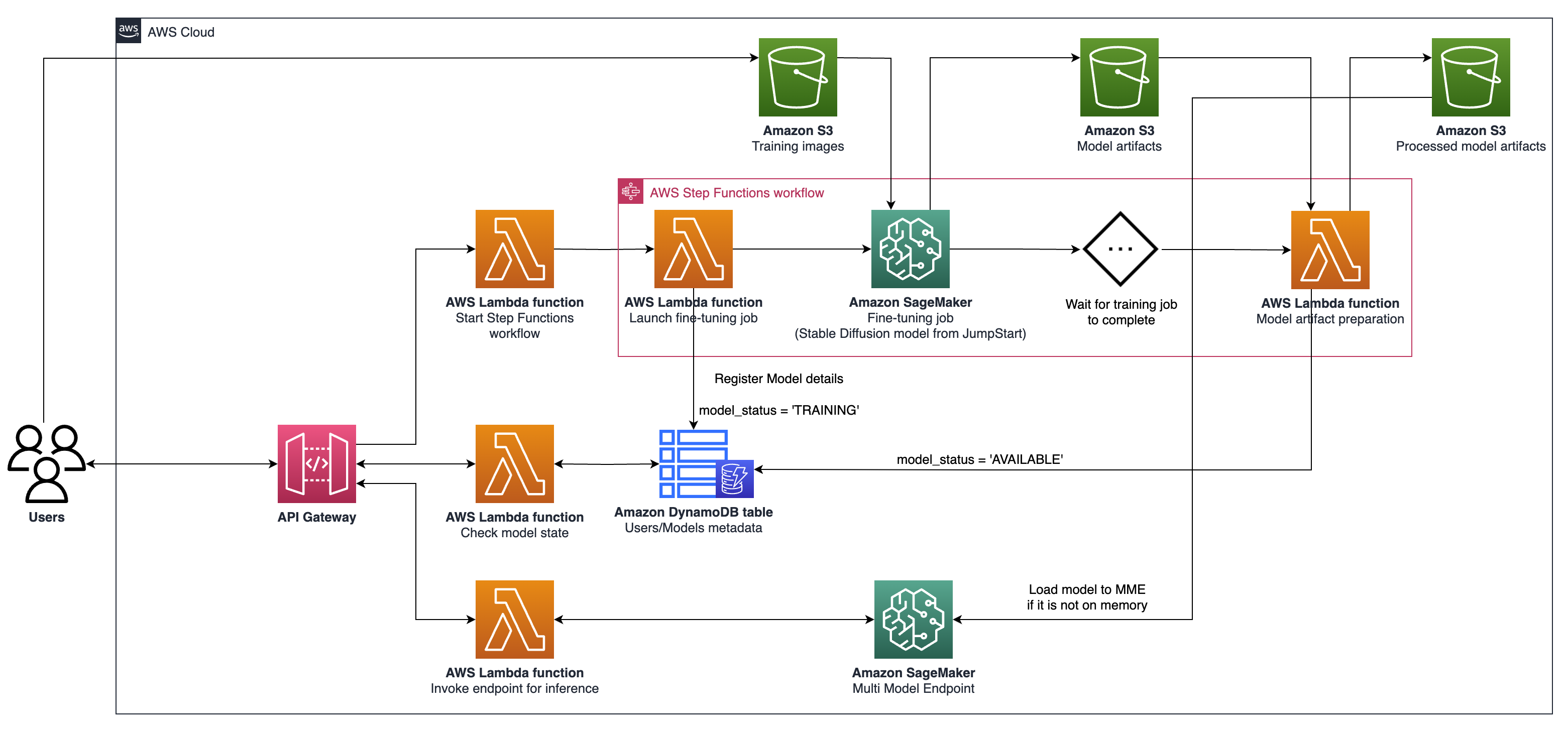

cdk ls LIST Todas as pilhas no aplicativocdk synth emite o modelo de formação de nuvem sintetizadacdk deploy implantei essa pilha para sua conta/região AWS padrãocdk diff compare pilha implantada com o estado atualcdk docs abrem documentação CDK A arquitetura descrita envolve um sistema para casos generativos de uso de IA, com foco na geração personalizada de texto para imagem como exemplo, usando difusão estável V2-1. Os principais componentes desta arquitetura são os seguintes:

Treinamento e hospedagem de Sagemaker : Essas APIs fornecem empregos de treinamento totalmente gerenciados e recursos de implantação de modelos. Eles permitem que as equipes em movimento rápido se concentrem mais nos recursos do produto e na diferenciação. Os trabalhos de treinamento de sagemaker, que seguem um paradigma "lançar e esquecer", são adequados para trabalhos de ajuste fino de modelo simultâneo transitório durante a integração do usuário.

Hosting habilitada para GPU : o Sagemaker suporta opções de hospedagem habilitadas para GPU para implantar modelos de aprendizado profundo em escala. Isso inclui a integração do NVIDIA Triton Inference Server no ecossistema de sagemaker. A Sagemaker também oferece suporte à GPU para pontos de extremidade multi-model (MMEs), que permitem a implantação de milhares de modelos de aprendizado profundo por trás de um único terminal, garantindo escalabilidade, baixa latência e efetividade.

Nível de infraestrutura : no nível de infraestrutura, a arquitetura depende das melhores opções de computação da categoria, como o tipo de instância G5, equipado com GPUs NVIDIA A10G Tensor Core (exclusivo da AWS). Esse tipo de instância oferece uma taxa favorável de preços-desempenho para treinamento e hospedagem modelo, fornecendo poder de computação eficiente por dólar gasto.

A arquitetura é particularmente adequada para casos de uso de geração de texto para imagem. Ele divide o fluxo de trabalho da solução em duas fases principais:

Fase A (Usuário integrado) : Nesta fase, os usuários podem solicitar a criação de um ou mais modelos personalizados e ajustados. Eles podem verificar o status de disponibilidade de seus modelos o tempo todo, para saber quando o treinamento terminar.

Fase B (inferência sob demanda) : Após o ajuste fino, o modelo está pronto para a geração de imagens em tempo real sob demanda por usuários finais.

Para interagir com o seu gateway da API implantado usando a AWS CDK, siga estas etapas:

Postman aberto e importe a coleção da documentation da pasta.

Defina o método de solicitação (por exemplo, Get, Post) e digite o terminal da URL da API Gateway.

Se sua API exigir autenticação, configure os cabeçalhos ou tokens necessários.

Adicione os parâmetros ou dados de solicitação necessários.

Clique em "Enviar" para fazer a solicitação e receber a resposta.

NOTA: Verifique se o seu AWS Resources e API Gateway estão configurados corretamente para lidar com a solicitação.