โครงการนี้ช่วยให้การปรับจูนและการให้บริการแบบจำลอง AI ที่มีความเป็นส่วนตัวมากเกินไปในระดับสูงใน AWS เราตอบสนองความต้องการของผู้ให้บริการ SaaS และ บริษัท สตาร์ทอัพ B2C ที่ต้องการปรับขนาดอย่างรวดเร็ว เราเสนอสถาปัตยกรรมที่ใช้ประโยชน์จาก Amazon Sagemaker เพื่อปรับปรุงการปรับแต่งแบบจำลองและการปรับใช้ AI แบบจำลอง AI ช่วยให้การพัฒนาเร็วขึ้นคุณภาพการบริการที่ดีขึ้นและความคุ้มค่า และจุดสิ้นสุดแบบหลายรูปแบบ (MMEs) สำหรับโฮสติ้งแบบเรียลไทม์ซึ่งให้วิธีที่ปรับขนาดได้ความล่าช้าต่ำและประหยัดค่าใช้จ่ายในการปรับใช้โมเดลการเรียนรู้ลึกหลายพันแบบที่อยู่เบื้องหลังจุดสิ้นสุดเดียว สำหรับรายละเอียดเพิ่มเติมโปรดดูโพสต์บล็อกนี้

npm install -g aws-cdkhttps://python-poetry.org/docs/#installationบทกวีติดตั้ง Linux, MacOS, Windows (WSL)

curl -sSL https://install.python-poetry.org | python3 -ติดตั้งการพึ่งพาด้วยบทกวี

poetry install

การตั้งค่า Python Env ในเชลล์

poetry shell

ณ จุดนี้คุณสามารถสังเคราะห์เทมเพลต CloudFormation สำหรับรหัสนี้

$ cdk synth

หากต้องการเพิ่มการพึ่งพาเพิ่มเติมเช่นไลบรารี CDK อื่น ๆ เพียงใช้ poetry add yourpackage

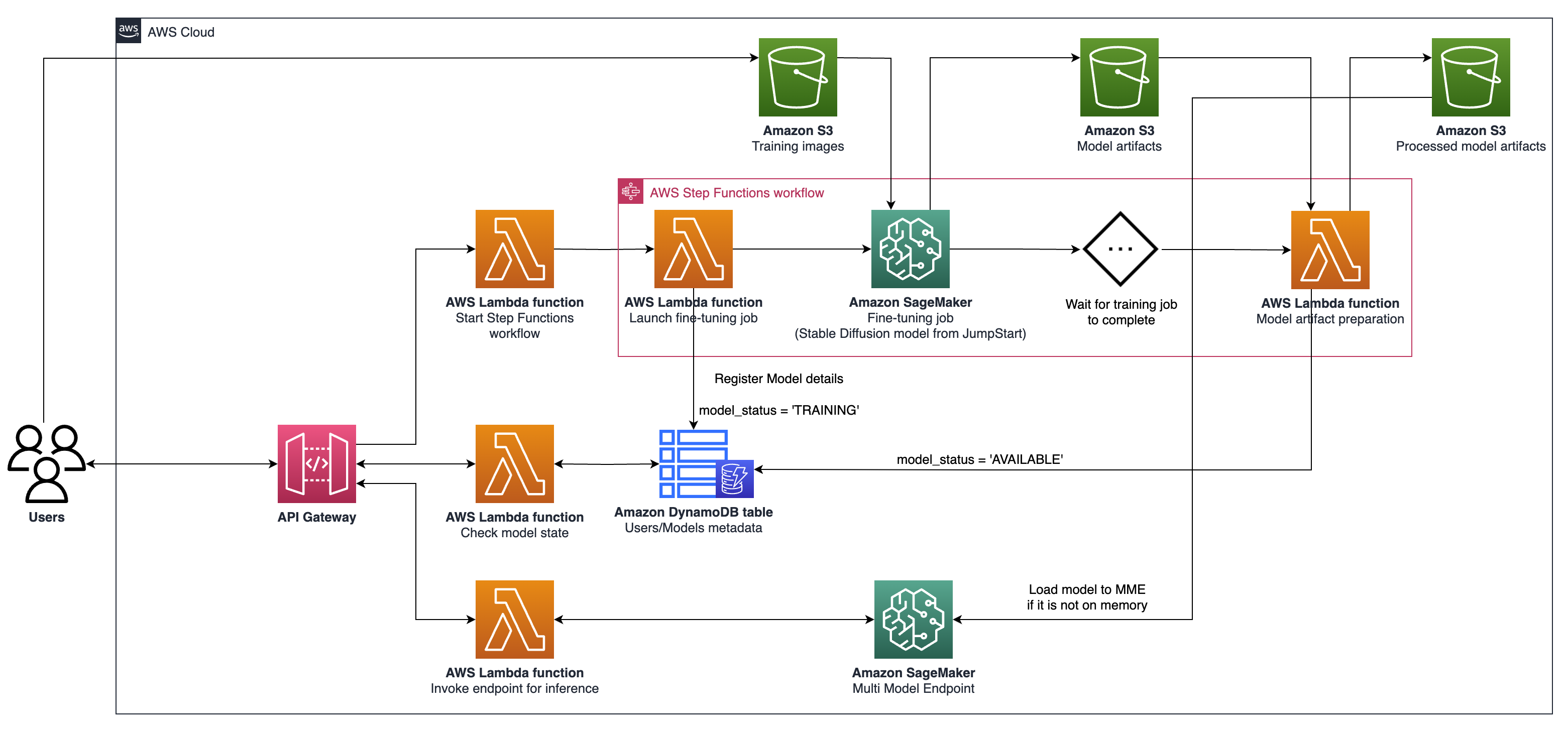

cdk ls รายการสแต็คทั้งหมดในแอพcdk synth ปล่อยเทมเพลต CloudFormation ที่สังเคราะห์cdk deploy ปรับใช้สแต็กนี้ไปยังบัญชี/ภูมิภาคเริ่มต้นของคุณcdk diff เปรียบเทียบสแต็กที่ปรับใช้กับสถานะปัจจุบันcdk docs เปิดเอกสาร CDK สถาปัตยกรรมที่อธิบายไว้เกี่ยวข้องกับระบบสำหรับกรณีการใช้ AI กำเนิดโดยมุ่งเน้นไปที่การสร้างข้อความกับภาพเป็นส่วนบุคคลเป็นตัวอย่างโดยใช้การแพร่กระจายที่เสถียร V2-1 องค์ประกอบสำคัญของสถาปัตยกรรมนี้มีดังนี้:

การฝึกอบรม Sagemaker และ Hosting APIs : API เหล่านี้ให้งานฝึกอบรมที่มีการจัดการอย่างเต็มที่และความสามารถในการปรับใช้แบบจำลอง พวกเขาช่วยให้ทีมที่เคลื่อนไหวอย่างรวดเร็วมีสมาธิกับคุณสมบัติและความแตกต่างของผลิตภัณฑ์มากขึ้น งานฝึกอบรม Sagemaker ซึ่งเป็นไปตามกระบวนทัศน์ "การเปิดตัวและการแสวงหา" เหมาะสำหรับงานปรับจูนแบบจำลองพร้อมกันชั่วคราวในระหว่างการทำงานของผู้ใช้

โฮสติ้งที่เปิดใช้งาน GPU : Sagemaker รองรับตัวเลือกโฮสติ้งที่เปิดใช้งาน GPU สำหรับการปรับใช้รูปแบบการเรียนรู้ลึกในระดับ ซึ่งรวมถึงการรวมเซิร์ฟเวอร์การอนุมาน Nvidia Triton เข้ากับระบบนิเวศ Sagemaker Sagemaker ยังให้การสนับสนุน GPU สำหรับจุดสิ้นสุดแบบหลายรูปแบบ (MMEs) ซึ่งอนุญาตให้มีการปรับใช้โมเดลการเรียนรู้ลึกหลายพันแบบที่อยู่เบื้องหลังจุดสิ้นสุดเดียวเพื่อให้มั่นใจได้ถึงความยืดหยุ่น

ระดับโครงสร้างพื้นฐาน : ในระดับโครงสร้างพื้นฐานสถาปัตยกรรมขึ้นอยู่กับตัวเลือกการคำนวณที่ดีที่สุดในระดับเช่นประเภทอินสแตนซ์ G5 ที่ติดตั้ง Nvidia A10G Tensor Core GPUs (ไม่ซ้ำกับ AWS) ประเภทอินสแตนซ์นี้เสนออัตราส่วนราคาตามประสิทธิภาพที่ดีสำหรับทั้งการฝึกอบรมแบบจำลองและโฮสติ้งส่งมอบพลังงานการคำนวณที่มีประสิทธิภาพต่อดอลลาร์ที่ใช้ไป

สถาปัตยกรรมมีความเหมาะสมเป็นพิเศษสำหรับกรณีการใช้งานการสร้างข้อความเป็นภาพ มันแบ่งเวิร์กโฟลว์โซลูชันออกเป็นสองขั้นตอนสำคัญ:

เฟส A (ผู้ใช้ onboarding) : ในขั้นตอนนี้ผู้ใช้สามารถขอการสร้างแบบจำลองที่กำหนดเองและปรับแต่งได้อย่างน้อยหนึ่งรุ่น พวกเขาสามารถตรวจสอบสถานะความพร้อมใช้งานของแบบจำลองของพวกเขาตลอดเวลาเพื่อทราบว่าการฝึกอบรมเสร็จสิ้นเมื่อใด

เฟส B (การอนุมานตามความต้องการ) : หลังจากการปรับแต่งอย่างละเอียดโมเดลพร้อมสำหรับการสร้างภาพแบบเรียลไทม์ตามความต้องการโดยผู้ใช้ปลายทาง

หากต้องการโต้ตอบกับ API Gateway ของคุณที่ใช้งานโดยใช้ AWS CDK ให้ทำตามขั้นตอนเหล่านี้:

เปิดโพสต์แมนและนำเข้าคอลเลกชันจาก documentation โฟลเดอร์

ตั้งค่าวิธีการร้องขอ (เช่นรับโพสต์) และป้อนจุดสิ้นสุด URL API Gateway

หาก API ของคุณต้องการการรับรองความถูกต้องให้กำหนดค่าส่วนหัวหรือโทเค็นที่จำเป็น

เพิ่มพารามิเตอร์หรือข้อมูลคำขอที่จำเป็น

คลิก "ส่ง" เพื่อทำการร้องขอและรับการตอบกลับ

หมายเหตุ: ตรวจสอบให้แน่ใจว่าทรัพยากร AWS และเกตเวย์ API ของคุณได้รับการกำหนดค่าอย่างถูกต้องเพื่อจัดการคำขอ