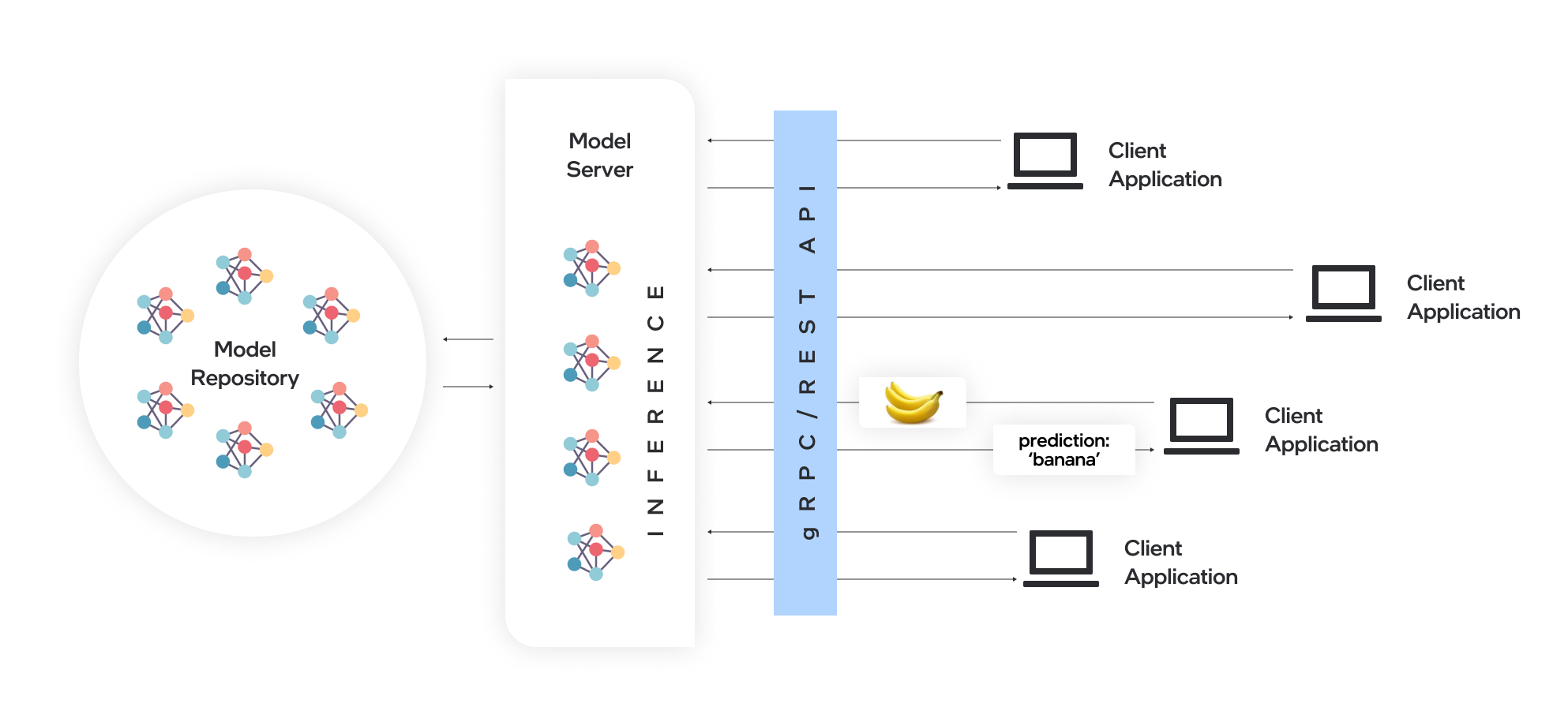

Model Server託管模型,並使它們可以通過標準網絡協議可以通過軟件組件訪問:客戶端將請求發送到模型服務器,該模型服務器執行模型推理並將響應發送回客戶端。 Model Server為有效的模型部署提供了許多優勢:

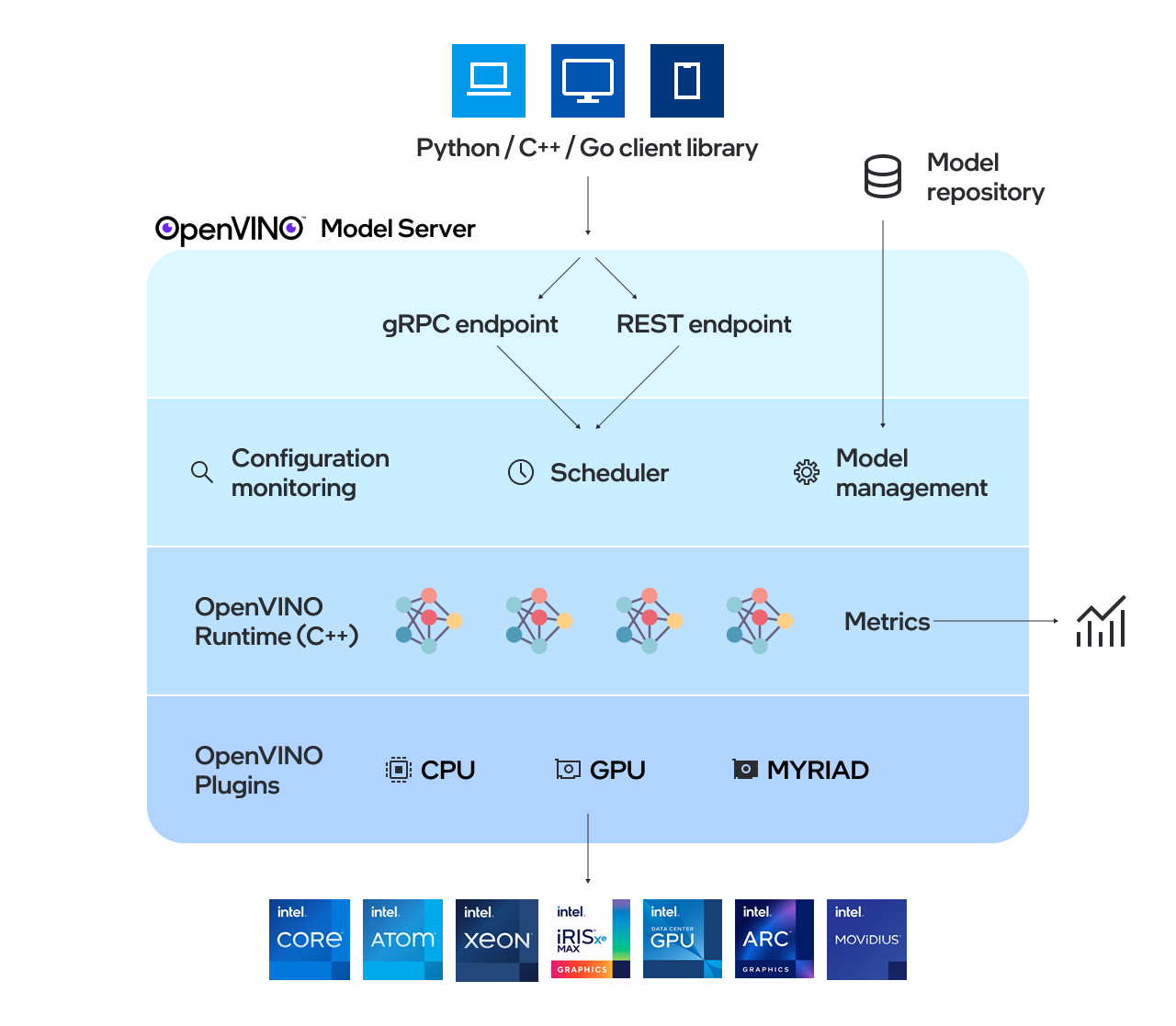

OpenVino™Model Server(OVM)是用於服務模型的高性能係統。該模型服務器在C ++中實現,以用於可擴展性,並針對英特爾體系結構進行了優化,在應用OpenVino進行推理執行時,使用了與TensorFlow Serving和Kserve相同的體系結構和API。推理服務是通過GRPC或REST API提供的,使部署新算法和AI實驗變得容易。

服務器使用的模型需要在本地存儲或通過對象存儲服務遠程託管。有關更多詳細信息,請參閱準備模型存儲庫文檔。模型服務器在Docker容器,裸機和Kubernetes環境中的工作。從QuickStart指南或探索模型服務器功能中使用OpenVino Model Server使用OpenVino Model Server。

閱讀發行說明以找出什麼新功能。

注意: OVM已在Redhat和Ubuntu上進行了測試。最新發布的Docker圖像基於Ubuntu和Ubi。它們存儲在:

有關如何使用OpenVino Model Server的演示,可以在我們的Vision用例和LLM文本生成的快速啟動指南中找到。有關在各種情況下使用Model Server的更多信息,您可以檢查以下指南:

模型存儲庫配置

部署選項

性能調整

定向無環形圖調度程序

自定義節點開發

服務狀態模型

使用kubernetes頭盔圖表部署

使用Kubernetes操作員部署

使用二進制輸入數據

OpenVino™

TensorFlow服務

grpc

寧靜的API

基準測試結果

跨多個體系結構 - 網絡研討會記錄的速度和規模AI推理操作

OpenVino Model Server C ++中的新事物是什麼

Capital Health通過AI-用例示例改善了中風護理

如果您有問題,功能請求或錯誤報告,請隨時提交GitHub問題。

*其他名稱和品牌可能被稱為他人的財產。