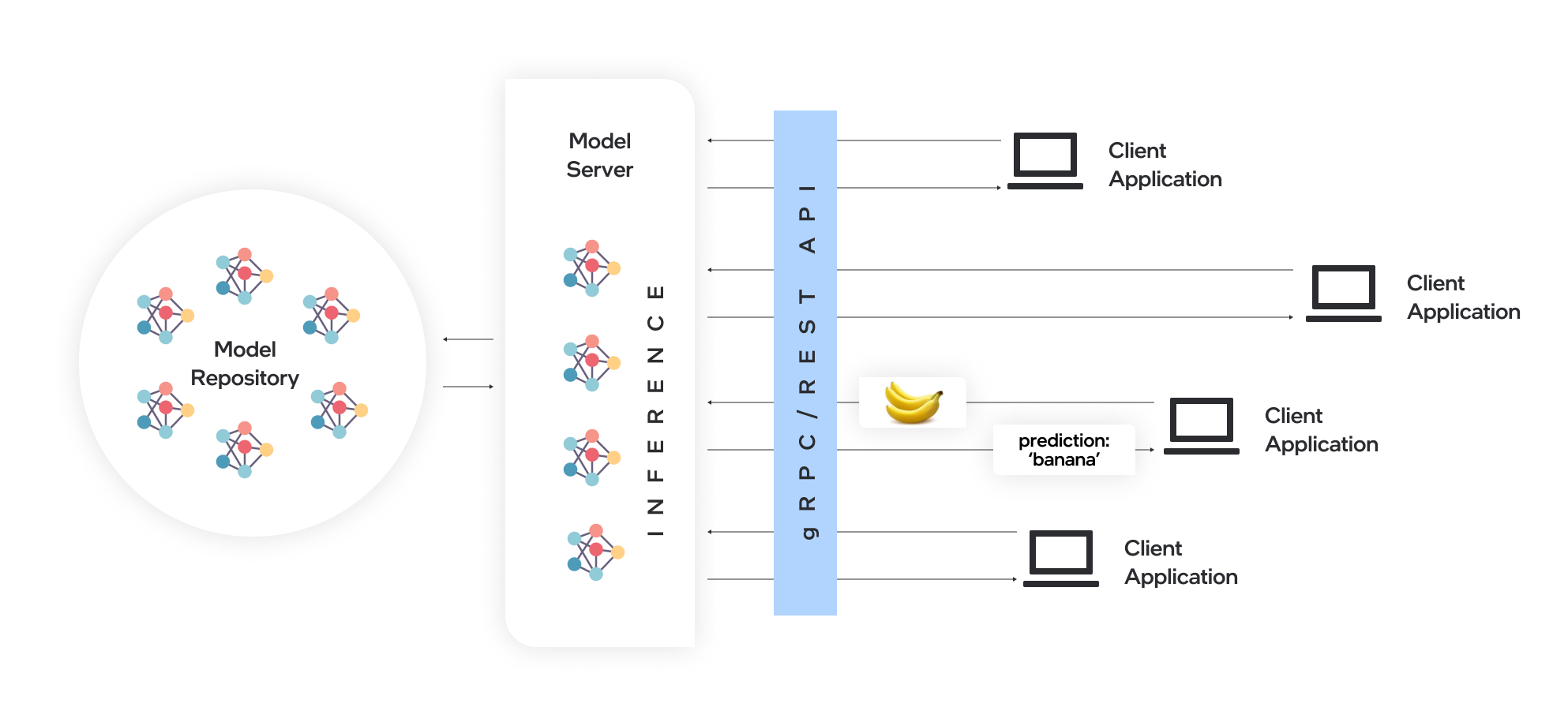

Model Server는 모델을 호스팅하고 표준 네트워크 프로토콜을 통해 소프트웨어 구성 요소에 액세스 할 수있게합니다. 클라이언트는 모델 서버에 요청을 보내 모델 추론을 수행하고 클라이언트에 응답을 다시 보냅니다. Model Server는 효율적인 모델 배포를위한 많은 장점을 제공합니다.

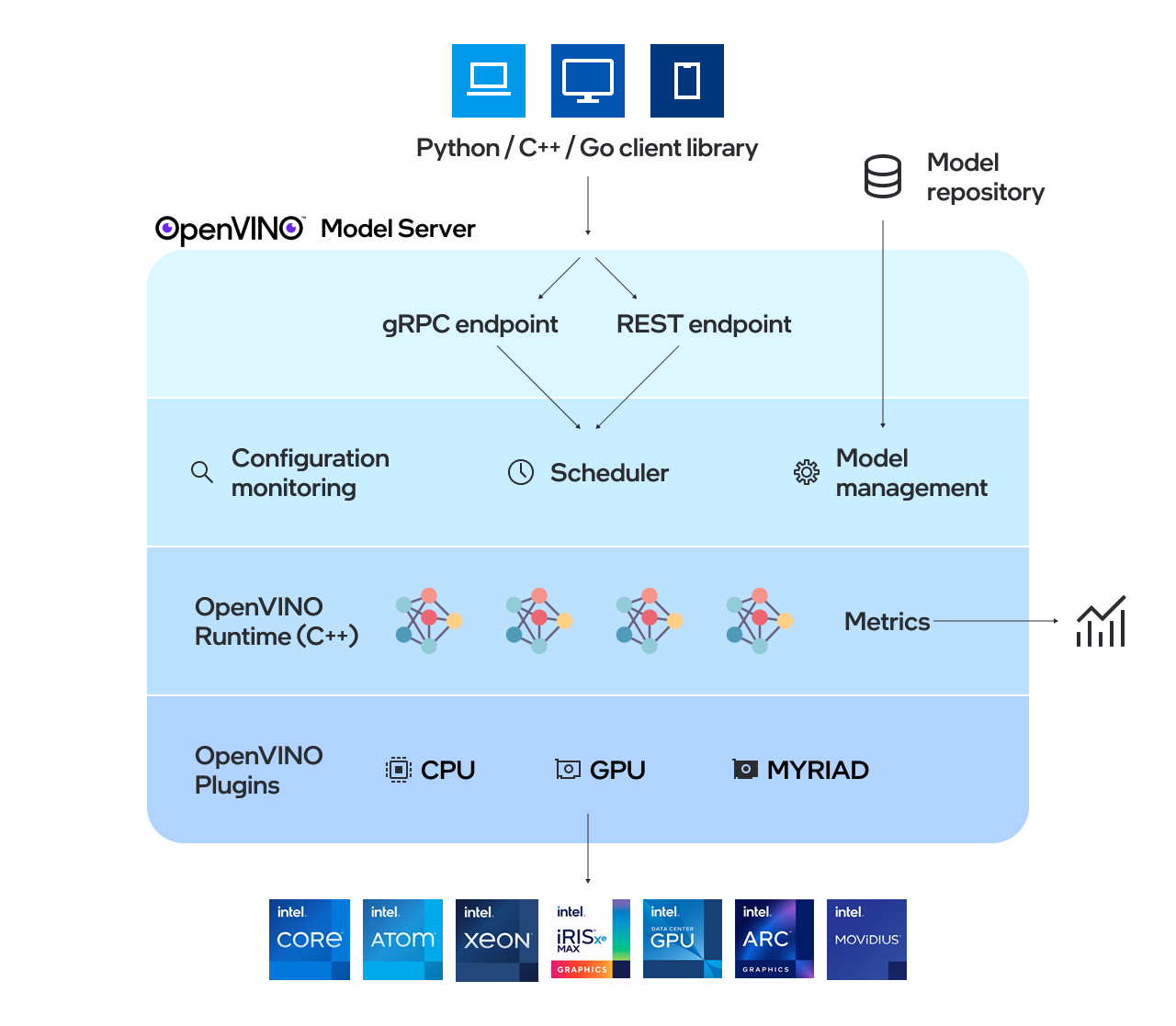

OpenVino ™ Model Server (OVMS)는 모델 서비스를위한 고성능 시스템입니다. 확장 성을 위해 C ++로 구현되고 인텔 아키텍처에서 배포를 위해 최적화 된 모델 서버는 추론 실행을 위해 OpenVino를 적용하면서 동일한 아키텍처 및 API를 텐서 플로우 서빙 및 Kserve를 사용합니다. 추론 서비스는 GRPC 또는 REST API를 통해 제공되며 새로운 알고리즘 및 AI 실험을 쉽게 배포합니다.

서버에서 사용하는 모델은 객체 저장 서비스에 의해 로컬로 또는 원격으로 호스팅되어야합니다. 자세한 내용은 모델 리포지토리 문서 준비를 참조하십시오. 모델 서버는 Docker Containers, Bare Metal 및 Kubernetes 환경에서 작동합니다. QuickStart Guide 또는 Model Server 기능 탐색의 빠른 서빙 예제와 함께 OpenVino 모델 서버 사용을 시작하십시오.

새로운 것을 찾으려면 릴리스 노트를 읽으십시오.

참고 : OVM은 Redhat 및 Ubuntu에서 테스트되었습니다. 공개적으로 공개 된 Docker 이미지는 Ubuntu 및 UBI를 기반으로합니다. 그들은 다음에 저장됩니다.

OpenVino 모델 서버 사용 방법에 대한 데모는 비전 사용 사례 및 LLM 텍스트 생성을위한 빠른 시작 안내서에서 찾을 수 있습니다. 다양한 시나리오에서 모델 서버 사용에 대한 자세한 내용은 다음 안내서를 확인할 수 있습니다.

모델 저장소 구성

배포 옵션

성능 튜닝

지시 된 acyclic 그래프 스케줄러

사용자 정의 노드 개발

상태가 많은 모델을 제공합니다

Kubernetes Helm 차트를 사용하여 배포하십시오

Kubernetes 운영자를 사용한 배포

이진 입력 데이터 사용

OpenVino ™

텐서 플로우 서빙

grpc

편안한 API

벤치마킹 결과

여러 아키텍처에서 속도 및 스케일 AI 추론 작업 - 웹 세미나 녹음

OpenVino 모델 서버 C ++의 새로운 기능

자본 건강은 AI를 사용한 뇌졸중 치료를 향상시킵니다 - 사용 사례 예제

질문, 기능 요청 또는 버그 보고서가 있으면 언제든지 Github 문제를 제출하십시오.

* 다른 이름과 브랜드는 다른 이름의 재산으로 주장 될 수 있습니다.