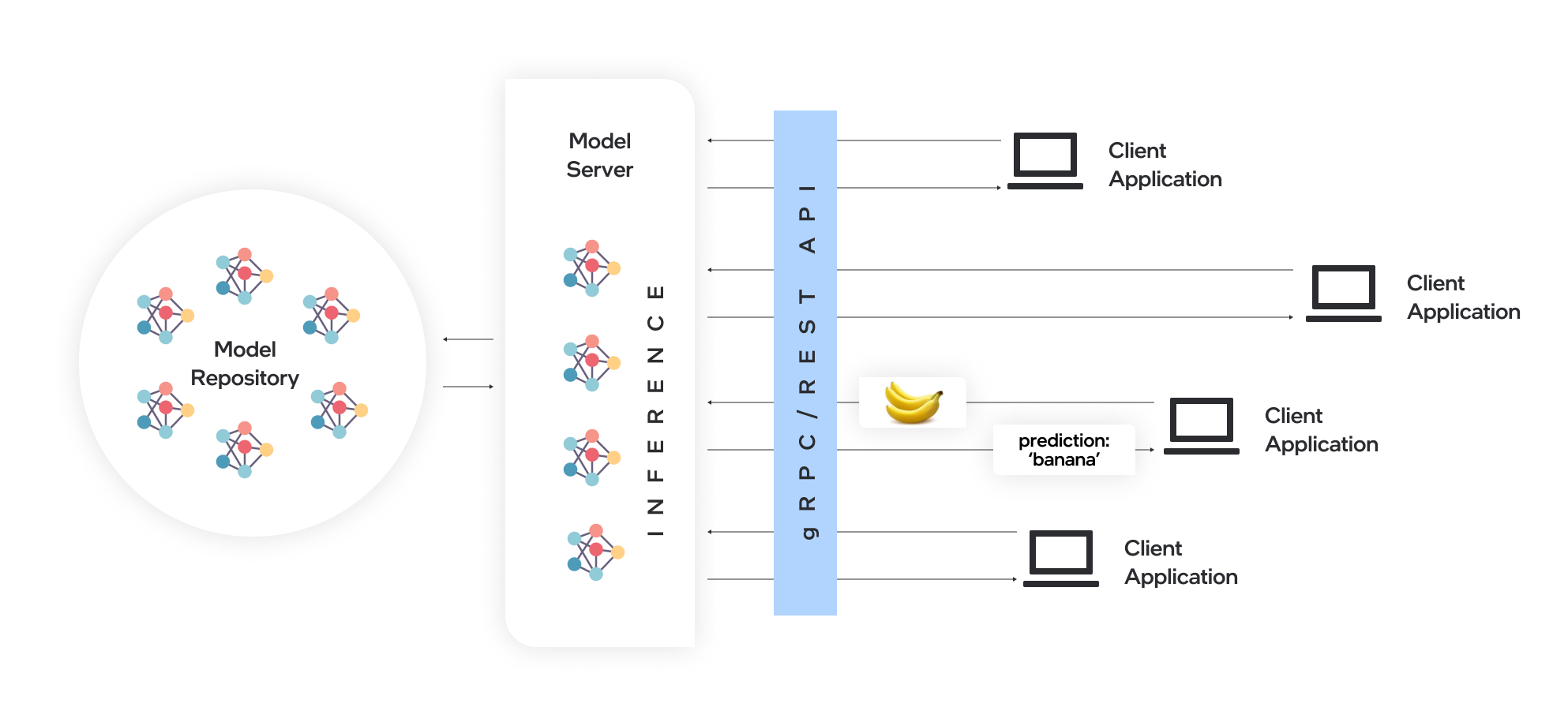

Model Server hostet Modelle und macht sie über Standard -Netzwerkprotokolle für Softwarekomponenten zugänglich: Ein Client sendet eine Anforderung an den Modellserver, der die Modellinferenz ausführt und eine Antwort an den Client zurücksendet. Modellserver bietet viele Vorteile für die effiziente Modellbereitstellung:

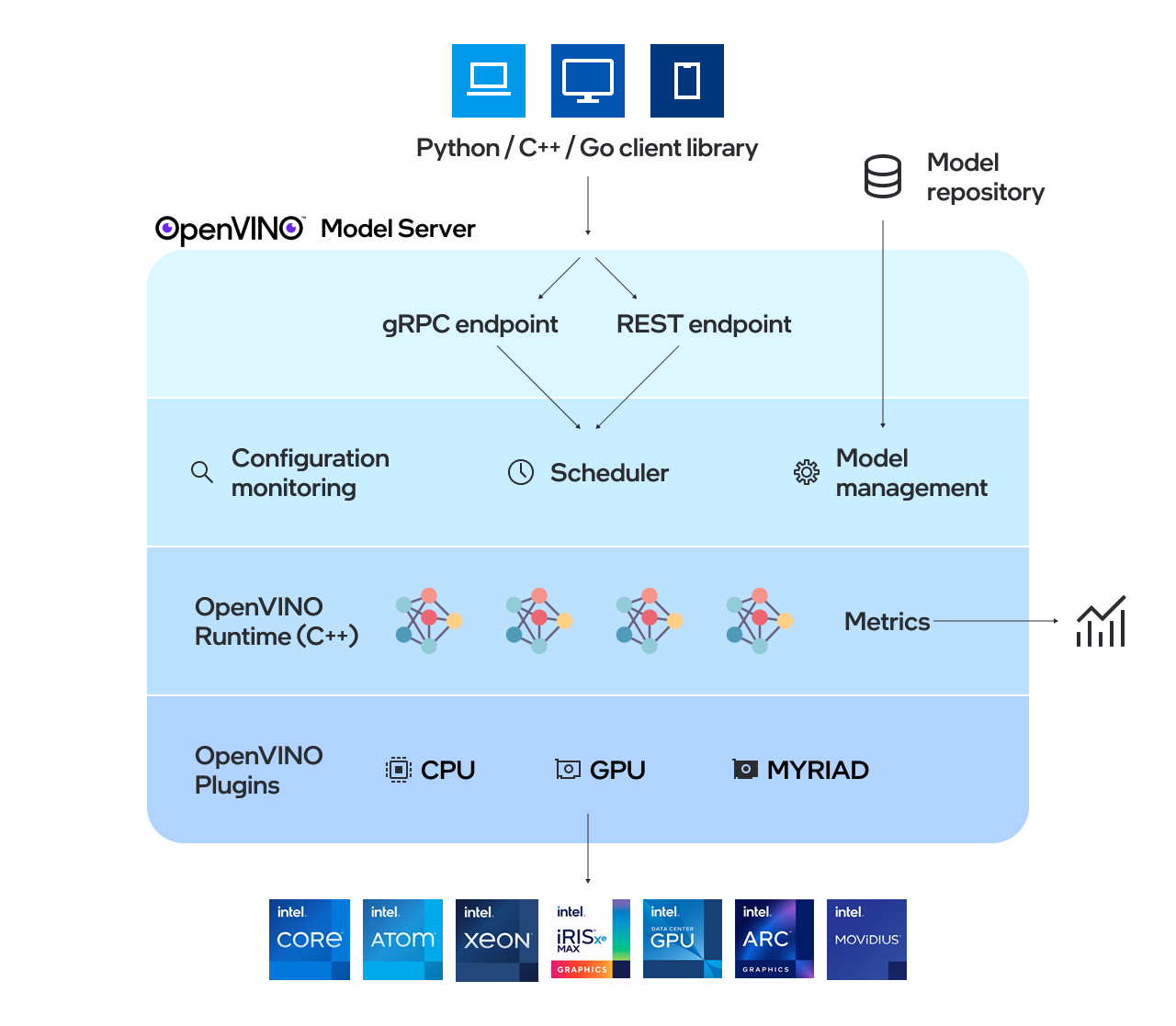

OpenVino ™ Model Server (OVMS) ist ein Hochleistungssystem zum Servieren von Modellen. Der Modellserver wird in C ++ für die Skalierbarkeit implementiert und für die Bereitstellung für Intel -Architekturen optimiert und verwendet dieselbe Architektur und API wie TensorFlow -Serving und KSERVE, während OpenVino für die Ausführung von Inferenz angewendet wird. Der Inferenzdienst wird über GRPC oder REST -API erbracht, wodurch die Bereitstellung neuer Algorithmen und KI -Experimente einfacher wird.

Die vom Server verwendeten Modelle müssen lokal gespeichert oder von Objektspeicherdiensten remote gehostet werden. Weitere Informationen finden Sie in der Vorbereitung der Modell -Repository -Dokumentation. Modellserver arbeitet in Docker -Containern, auf Bare Metal und in Kubernetes -Umgebung. Verwenden Sie den OpenVino-Modellserver mit einem schnellen Servingbeispiel aus dem QuickStart-Handbuch oder erkunden Sie den Model Server-Funktionen.

Lesen Sie Release -Notizen, um herauszufinden, was neu ist.

Hinweis: OVMS wurde auf Redhat und Ubuntu getestet. Die neuesten öffentlich veröffentlichten Docker -Bilder basieren auf Ubuntu und UBI. Sie werden in: sie gelagert:

Eine Demonstration zur Verwendung von OpenVino-Modellserver finden Sie in unserem Quick-Start-Handbuch für Vision Use Case und LLM-Textgenerierung. Weitere Informationen zur Verwendung des Modellservers in verschiedenen Szenarien finden Sie in den folgenden Anleitungen:

Modellrepository -Konfiguration

Bereitstellungsoptionen

Leistungsstimmung

Regie acyclischer Graphenplaner

Entwicklung von benutzerdefinierten Knoten

Diente staatliche Modelle

Bereitstellen mithilfe eines Kubernetes -Helm -Diagramms

Bereitstellung mit dem Kubernetes -Operator

Verwenden von Binäreingabedaten

OpenVino ™

Tensorflow Serving

GRPC

RESTful -API

Benchmarking -Ergebnisse

Geschwindigkeits- und Skalierung von AI -Inferenzvorgängen über mehrere Architekturen hinweg - Webinaraufzeichnung

Was ist neu in OpenVino Model Server C ++

Capital Health verbessert die Schlaganfallversorgung mit KI - Anwendungsfallbeispiel

Wenn Sie eine Frage, eine Feature -Anfrage oder einen Fehlerbericht haben, können Sie ein GitHub -Problem senden.

* Andere Namen und Marken können als Eigentum anderer beansprucht werden.