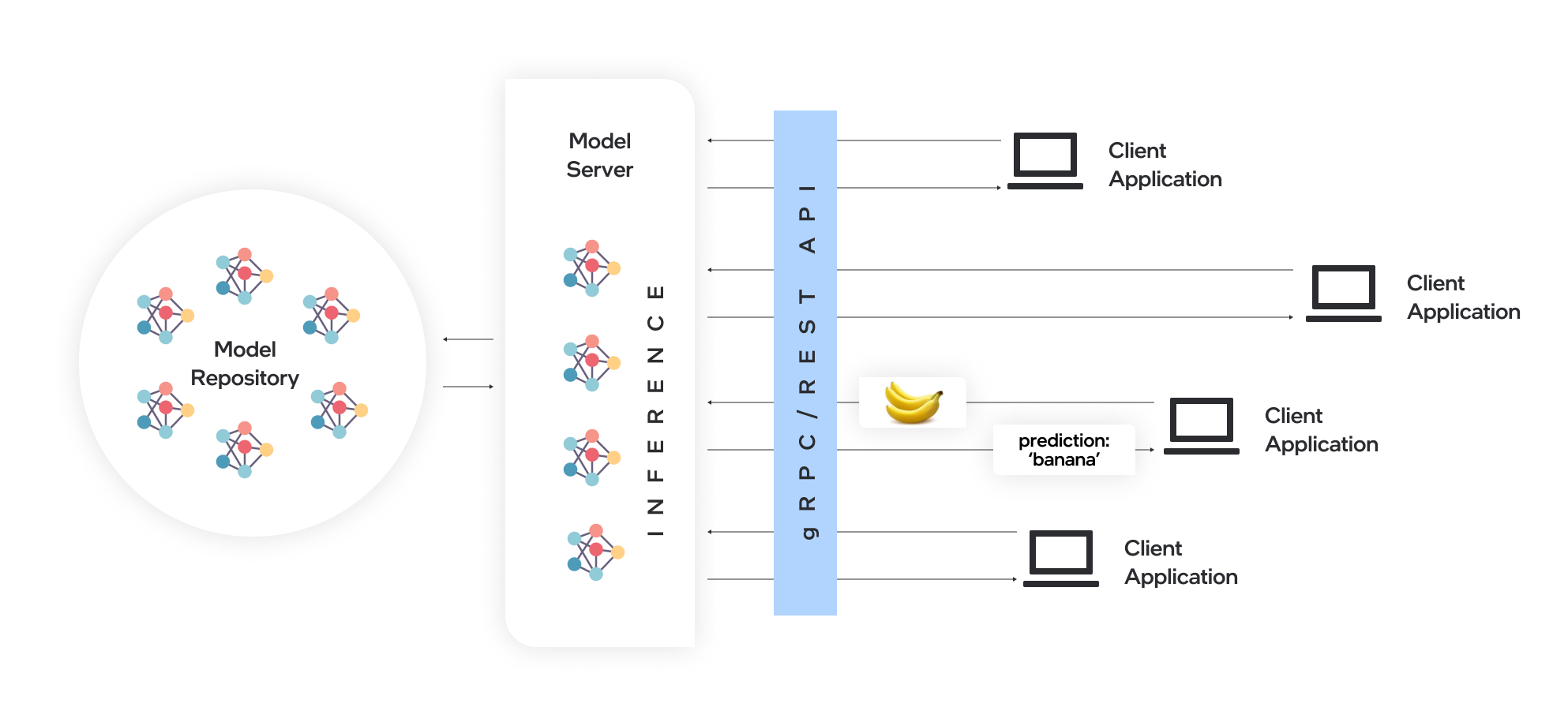

モデルサーバーはモデルをホストし、標準ネットワークプロトコルを介してソフトウェアコンポーネントにアクセスしやすくします。クライアントは、モデル推論を実行し、クライアントに応答を送信するモデルサーバーにリクエストを送信します。モデルサーバーは、効率的なモデル展開に多くの利点を提供します。

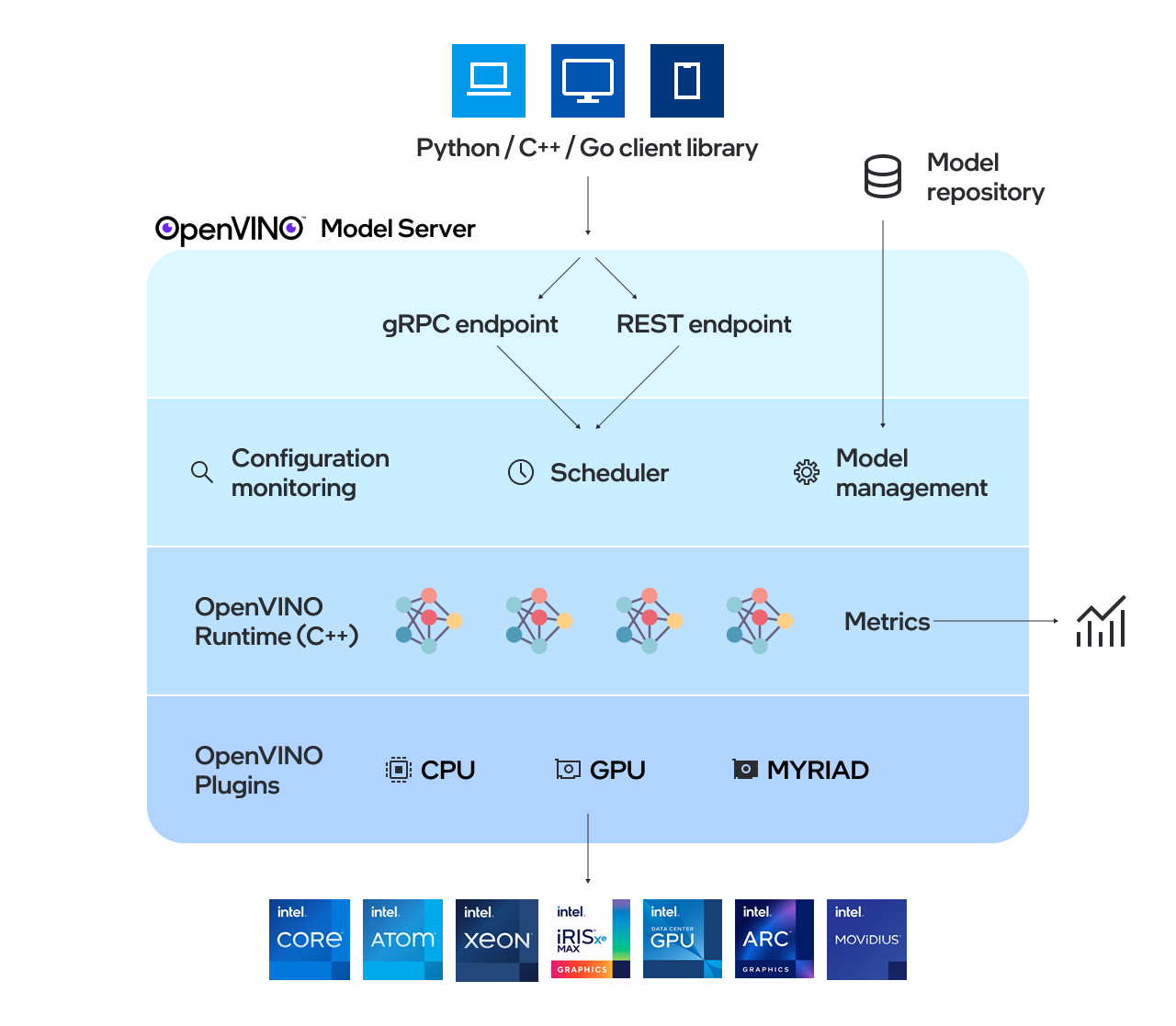

OpenVino™モデルサーバー(OVMS)は、モデルを提供するための高性能システムです。スケーラビリティのためにC ++に実装され、Intelアーキテクチャの展開に最適化されたモデルサーバーは、推論実行のためにOpenVinoを適用しながら、TensorflowのサービングとKserveと同じアーキテクチャとAPIを使用します。推論サービスは、GRPCまたはREST APIを介して提供され、新しいアルゴリズムとAI実験の展開が容易になります。

サーバーが使用するモデルは、ローカルに保存するか、オブジェクトストレージサービスによってリモートでホストされる必要があります。詳細については、Model Repositoryドキュメントの準備を参照してください。モデルサーバーは、Dockerコンテナ内、裸の金属、Kubernetes環境内で動作します。 QuickStartガイドまたはモデルサーバーの機能を探索するための早送り例でOpenVino Model Serverの使用を開始します。

リリースノートを読んで、何が新しいかを調べてください。

注: OVMはRedhatおよびUbuntuでテストされています。最新の公開されたDocker画像は、UbuntuとUbiに基づいています。それらは保存されています:

OpenVino Model Serverの使用方法に関するデモは、ビジョン使用ケースとLLMテキスト生成に関するクイックスタートガイドにあります。さまざまなシナリオでモデルサーバーの使用の詳細については、次のガイドを確認できます。

モデルリポジトリ構成

展開オプション

パフォーマンスチューニング

指示された非環式グラフスケジューラ

カスタムノード開発

ステートフルモデルの提供

Kubernetesヘルムチャートを使用して展開します

Kubernetesオペレーターを使用した展開

バイナリ入力データの使用

OpenVino™

Tensorflowサービング

GRPC

RESTFUL API

ベンチマークの結果

複数のアーキテクチャにわたる速度とスケールAI推論操作 - ウェビナー録音

OpenVino Model Server C ++では新しいもの

資本健康はAIで脳卒中ケアを改善する - ユースケースの例

質問、機能リクエスト、またはバグレポートがある場合は、GitHubの問題をお気軽に送信してください。

*他の名前とブランドは、他の名前と主張される場合があります。