LLCP

1.0.0

該存儲庫包含ICLR2024論文LLCP的實現:學習基於推理的視頻問題答案PDF的潛在因果過程

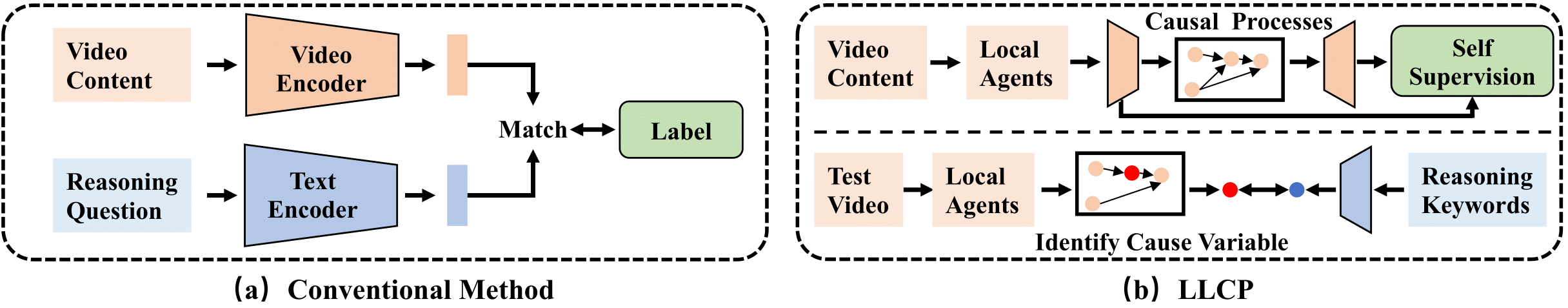

LLCP是一個因果框架,旨在通過關注事件內物體的空間動力學來增強視頻推理,而無需進行廣泛的數據註釋。通過採用自我監督的學習並利用因果機制的模塊化,LLCP學習了空間 - 週期動力學的多元生成模型,因此可以實現有效的事故歸因和基於推理的視頻的反事實預測。

首先,請安裝最近版本的Pytorch和Torchvision作為pip install torch torchvision 。然後,您可以通過運行pip install -r requirements.txt安裝其他軟件包

我們提供實驗中使用的處理功能。請在此鏈接1和此鏈接中下載數據和模型2。然後,請以./data/和./results/的形式解壓縮群,然後替換原始的蟲子作為下載的蟲。

目錄結構應該看起來像

LLCP_VQA/

|–– config.py

|–– configs/

|–– data/

| |–– object_test_feat/

| |–– object_train_feat/

| |–– appearance_feat_rn50.h5

| |–– test_questions.pt

| |–– train_questions.pt

| |–– video_noaccident_train.txt

|–– DataLoader.py

|–– models_cvae.py

|–– requirements.txt

|–– results/

| |–– .../model_cvae49.pt

|–– README.md

|–– train.py

|–– validate.py

要訓練CVAE模型,您可以運行此命令:

python train.py --cfg configs/sutd-traffic_transition.yml

要評估受過訓練的模型,請參考:

python validate.py --cfg configs/sutd-traffic_transition.yml

參見LLCP仿真。

如果您發現我們的工作對您的研究有用,請考慮引用:

@inproceedings{chen2024llcp,

title={LLCP: Learning Latent Causal Processes for Reasoning-based Video Question Answer},

author={Chen, Guangyi and Li, Yuke and Liu, Xiao and Li, Zijian and Al Surad, Eman and Wei, Donglai and Zhang, Kun}

booktitle={ICLR},

year={2024}

}

我們的實施主要基於Sutd-Trafficqa和Tem-Apapter,我們感謝作者發布其代碼。