Этот репозиторий содержит реализацию для ICLR2024 Paper LLCP: Learning скрытые причинно-следственные процессы для видео на основе рассуждений Ответ PDF

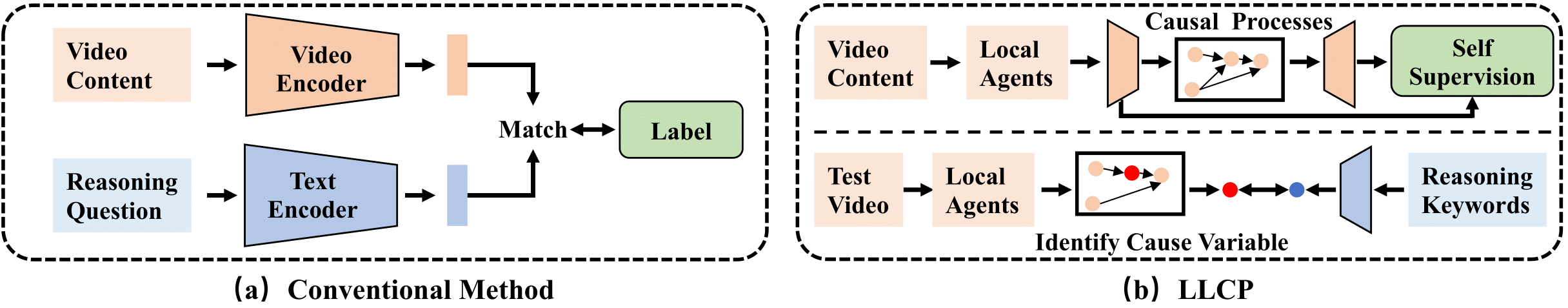

LLCP-это причинно-следственная связь, предназначенная для улучшения видео-рассуждений, сосредоточив внимание на пространственной временной динамике объектов в рамках событий, без необходимости обширных аннотаций данных. Используя самоотверженное обучение и используя модульность причинно-следственных механизмов, LLCP изучает многомерную генеративную модель для пространственно-временной динамики и, таким образом, обеспечивает эффективную атрибуцию аварии и контрфактурный прогноз видеоки на основе рассуждений.

Во -первых, установите недавнюю версию Pytorch и Torchvision в качестве pip install torch torchvision . Затем вы можете установить другой пакет, выполнив pip install -r requirements.txt

Мы предоставляем обработанные функции, используемые в наших экспериментах. Пожалуйста, загрузите данные и модель в этой Link1 и этой Link2. Тогда, пожалуйста, распахните Floders как ./data/ и ./results/ и замените оригинальные Floders как загруженные.

Структура каталога должна выглядеть как

LLCP_VQA/

|–– config.py

|–– configs/

|–– data/

| |–– object_test_feat/

| |–– object_train_feat/

| |–– appearance_feat_rn50.h5

| |–– test_questions.pt

| |–– train_questions.pt

| |–– video_noaccident_train.txt

|–– DataLoader.py

|–– models_cvae.py

|–– requirements.txt

|–– results/

| |–– .../model_cvae49.pt

|–– README.md

|–– train.py

|–– validate.py

Чтобы тренировать модель CVAE, вы можете выполнить эту команду:

python train.py --cfg configs/sutd-traffic_transition.yml

Чтобы оценить обученную модель, пожалуйста, см.

python validate.py --cfg configs/sutd-traffic_transition.yml

См. LLCP-симуляция.

Если вы найдете нашу работу полезной в своем исследовании, пожалуйста, рассмотрите возможность ссылаться:

@inproceedings{chen2024llcp,

title={LLCP: Learning Latent Causal Processes for Reasoning-based Video Question Answer},

author={Chen, Guangyi and Li, Yuke and Liu, Xiao and Li, Zijian and Al Surad, Eman and Wei, Donglai and Zhang, Kun}

booktitle={ICLR},

year={2024}

}

Наша реализация в основном основана на Sutd-Trafficqa и TEM-адаптере, мы благодарим авторов за выпуск их кодов.