LLCP

1.0.0

이 저장소에는 ICLR2024 용지 LLCP : 추론 기반 비디오 질문 답변 학습

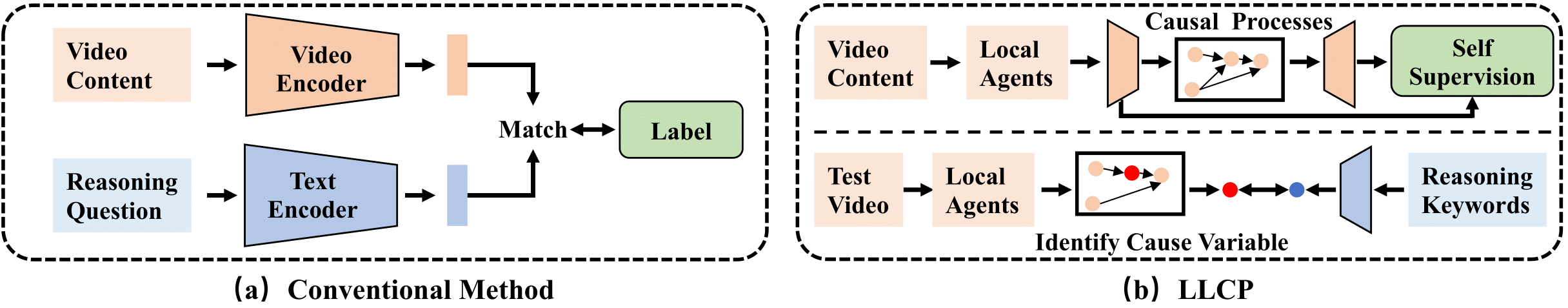

LLCP는 광범위한 데이터 주석이 없어도 이벤트 내 객체의 공간적 역학에 중점을 두어 비디오 추론을 향상시키기 위해 설계된 인과 프레임 워크입니다. LLCP는 자체 감독 학습을 사용하고 인과 적 메커니즘의 모듈성을 활용함으로써 공간-시간 역학에 대한 다변량 생성 모델을 배우므로 효과적인 사고 기반 및 반대의 추론 기반 VideoQA 예측을 가능하게합니다.

먼저 pip install torch torchvision 으로 최근 버전의 Pytorch 및 Torchvision을 설치하십시오. 그런 다음 pip install -r requirements.txt 실행하여 다른 패키지를 설치할 수 있습니다.

우리는 실험에 사용 된 처리 된 기능을 제공합니다. 이 Link1 과이 Link2에서 데이터와 모델을 다운로드하십시오. 그런 다음 플로더를 ./data/ 및 ./results/ 로 압축하고 원래 플로더를 다운로드 한 플로더로 교체하십시오.

디렉토리 구조는 모양이 있어야합니다

LLCP_VQA/

|–– config.py

|–– configs/

|–– data/

| |–– object_test_feat/

| |–– object_train_feat/

| |–– appearance_feat_rn50.h5

| |–– test_questions.pt

| |–– train_questions.pt

| |–– video_noaccident_train.txt

|–– DataLoader.py

|–– models_cvae.py

|–– requirements.txt

|–– results/

| |–– .../model_cvae49.pt

|–– README.md

|–– train.py

|–– validate.py

CVAE 모델을 훈련 시키려면이 명령을 실행할 수 있습니다.

python train.py --cfg configs/sutd-traffic_transition.yml

훈련 된 모델을 평가하려면 다음을 참조하십시오.

python validate.py --cfg configs/sutd-traffic_transition.yml

LLCP- 시뮬레이션을 참조하십시오.

귀하의 연구에 우리의 작업이 유용하다고 생각되면 다음을 고려하십시오.

@inproceedings{chen2024llcp,

title={LLCP: Learning Latent Causal Processes for Reasoning-based Video Question Answer},

author={Chen, Guangyi and Li, Yuke and Liu, Xiao and Li, Zijian and Al Surad, Eman and Wei, Donglai and Zhang, Kun}

booktitle={ICLR},

year={2024}

}

우리의 구현은 주로 SUTD-Trafficqa 및 Tem-Adapter를 기반으로하며 저자에게 코드를 공개 해 주셔서 감사합니다.