ที่เก็บนี้มีการใช้งานสำหรับ ICLR2024 Paper LLCP: การเรียนรู้กระบวนการเชิงสาเหตุแฝงสำหรับคำถามวิดีโอที่ใช้เหตุผลตอบคำถาม PDF

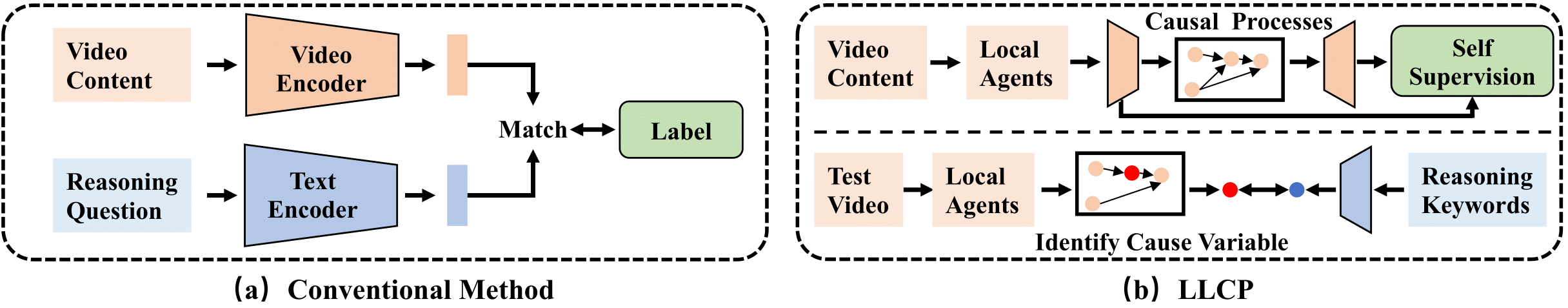

LLCP เป็นเฟรมเวิร์กสาเหตุที่ออกแบบมาเพื่อเพิ่มการให้เหตุผลวิดีโอโดยมุ่งเน้นไปที่การเปลี่ยนแปลงเชิงพื้นที่ของวัตถุภายในเหตุการณ์โดยไม่จำเป็นต้องมีคำอธิบายประกอบข้อมูลที่กว้างขวาง ด้วยการใช้การเรียนรู้ด้วยตนเองและใช้ประโยชน์จากโมดูลาร์ของกลไกเชิงสาเหตุ LLCP จะเรียนรู้แบบจำลองการกำเนิดหลายตัวแปรสำหรับการเปลี่ยนแปลงเชิงพื้นที่อารมณ์และช่วยให้เกิดการเกิดอุบัติเหตุที่มีประสิทธิภาพ

ก่อนอื่นโปรดติดตั้ง Pytorch และ Torchvision เวอร์ชันล่าสุดเป็น pip install torch torchvision จากนั้นคุณสามารถติดตั้งแพ็คเกจอื่น ๆ ได้โดยเรียกใช้ pip install -r requirements.txt

เราให้บริการคุณสมบัติที่ประมวลผลที่ใช้ในการทดลองของเรา โปรดดาวน์โหลดข้อมูลและโมเดลในลิงค์นี้ 1 และลิงค์นี้ 2 จากนั้นโปรดบีบอัดแฟลชเป็น ./data/ และ ./results/ และแทนที่ Floders ดั้งเดิมเป็นที่ดาวน์โหลด

โครงสร้างไดเรกทอรีควรมีลักษณะ

LLCP_VQA/

|–– config.py

|–– configs/

|–– data/

| |–– object_test_feat/

| |–– object_train_feat/

| |–– appearance_feat_rn50.h5

| |–– test_questions.pt

| |–– train_questions.pt

| |–– video_noaccident_train.txt

|–– DataLoader.py

|–– models_cvae.py

|–– requirements.txt

|–– results/

| |–– .../model_cvae49.pt

|–– README.md

|–– train.py

|–– validate.py

ในการฝึกอบรมโมเดล CVAE คุณสามารถเรียกใช้คำสั่งนี้:

python train.py --cfg configs/sutd-traffic_transition.yml

ในการประเมินรูปแบบที่ผ่านการฝึกอบรมโปรดดู:

python validate.py --cfg configs/sutd-traffic_transition.yml

ดู LLCP-simulation

หากคุณพบว่างานของเรามีประโยชน์ในการวิจัยของคุณโปรดพิจารณาอ้าง:

@inproceedings{chen2024llcp,

title={LLCP: Learning Latent Causal Processes for Reasoning-based Video Question Answer},

author={Chen, Guangyi and Li, Yuke and Liu, Xiao and Li, Zijian and Al Surad, Eman and Wei, Donglai and Zhang, Kun}

booktitle={ICLR},

year={2024}

}

การใช้งานของเราส่วนใหญ่ขึ้นอยู่กับ SUTD-TRAFFICQA และ TEM-ADAPTER เราขอขอบคุณผู้เขียนที่จะปล่อยรหัสของพวกเขา