يحتوي هذا المستودع على تطبيق ICLR2024 Paper LLCP: تعلم العمليات السببية الكامنة لاستجواب الفيديو القائم على التفكير الإجابة PDF

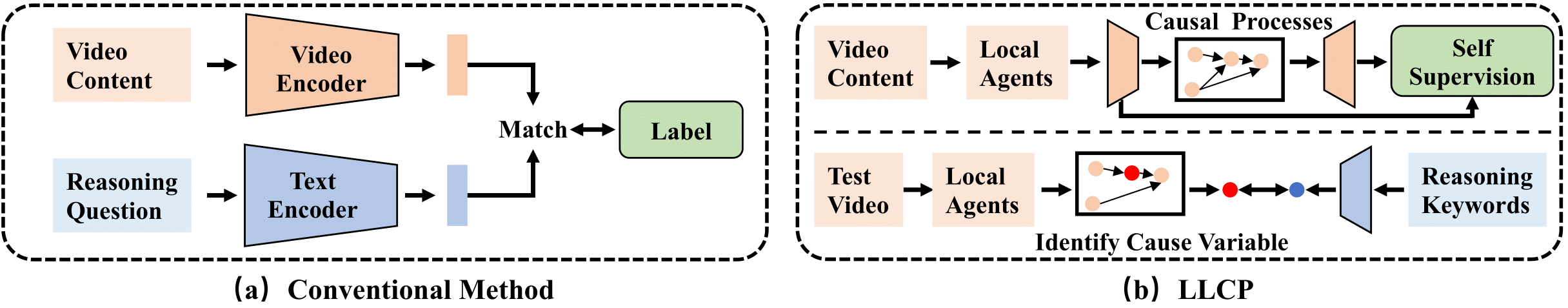

LLCP هو إطار سببي مصمم لتعزيز تفكير الفيديو من خلال التركيز على ديناميات الكائنات المكانية للكائنات في الأحداث ، دون الحاجة إلى تعليقات بيانات واسعة النطاق. من خلال استخدام التعلم الخاضع للإشراف ذاتيا والاستفادة من نموذج الآليات السببية ، يتعلم LLCP نموذجًا توليديًا متعدد المتغيرات للديناميات الزمنية المكانية وبالتالي يتيح إسناد الحوادث الفعال والتنبؤ المضاد للفيديو القائم على التفكير.

أولاً ، يرجى تثبيت الإصدار الأخير من Pytorch و TorchVision كـ pip install torch torchvision . بعد ذلك ، يمكنك تثبيت حزمة أخرى عن طريق تشغيل pip install -r requirements.txt

نحن نقدم الميزات المعالجة المستخدمة في تجاربنا. يرجى تنزيل البيانات والنموذج في هذا Link1 وهذا Link2. ثم يرجى إلغاء ضغط الزخارف كـ ./data/ و ./results/

يجب أن يبدو هيكل الدليل

LLCP_VQA/

|–– config.py

|–– configs/

|–– data/

| |–– object_test_feat/

| |–– object_train_feat/

| |–– appearance_feat_rn50.h5

| |–– test_questions.pt

| |–– train_questions.pt

| |–– video_noaccident_train.txt

|–– DataLoader.py

|–– models_cvae.py

|–– requirements.txt

|–– results/

| |–– .../model_cvae49.pt

|–– README.md

|–– train.py

|–– validate.py

لتدريب نموذج CVAE ، يمكنك تشغيل هذا الأمر:

python train.py --cfg configs/sutd-traffic_transition.yml

لتقييم النموذج المدرب ، يرجى الرجوع إلى:

python validate.py --cfg configs/sutd-traffic_transition.yml

انظر LLCP-Simulation.

إذا وجدت عملنا مفيدًا في بحثك ، فيرجى التفكير في:

@inproceedings{chen2024llcp,

title={LLCP: Learning Latent Causal Processes for Reasoning-based Video Question Answer},

author={Chen, Guangyi and Li, Yuke and Liu, Xiao and Li, Zijian and Al Surad, Eman and Wei, Donglai and Zhang, Kun}

booktitle={ICLR},

year={2024}

}

يعتمد تنفيذنا بشكل أساسي على SUTD-Trafficqa و TEM-Adapter ، نشكر المؤلفين لإصدار رموزهم.