LLCP

1.0.0

このリポジトリには、ICLR2024 Paper LLCPの実装が含まれています。

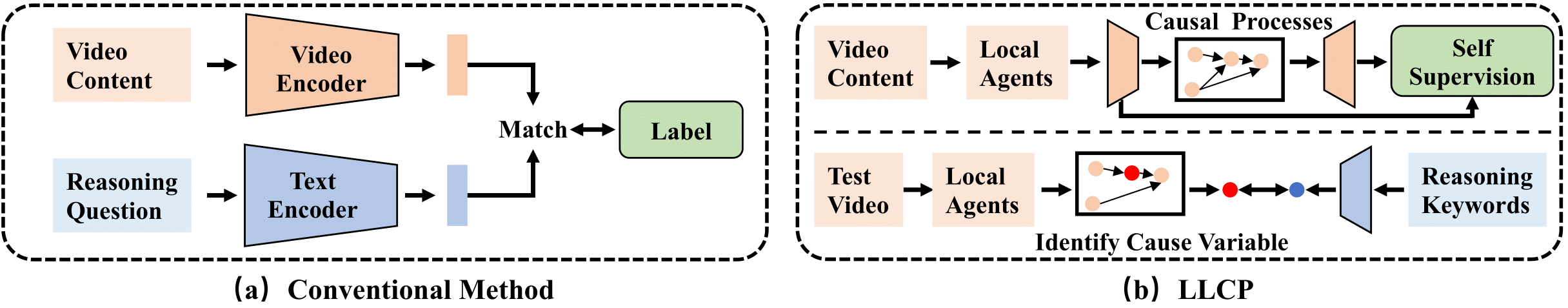

LLCPは、広範なデータアノテーションを必要とせずに、イベント内のオブジェクトの空間的なダイナミクスに焦点を当てることにより、ビデオ推論を強化するために設計された因果フレームワークです。 LLCPは、自己教師の学習を採用し、因果メカニズムのモジュール性を活用することにより、空間的ダイナミクスの多変量生成モデルを学習し、したがって、効果的な事故の帰属と推論ベースのビデオQAの反事実的予測を可能にします。

まず、PytorchとTorchvisionの最近のバージョンをpip install torch torchvisionとしてインストールしてください。次に、 pip install -r requirements.txtを実行して他のパッケージをインストールできます。txt

実験で使用される加工機能を提供します。このlink1とこのlink2にデータとモデルをダウンロードしてください。次に、フロッダーを./data/および./results/として減圧し、ダウンロードしたフロッダーとして元のフロッダーを置き換えてください。

ディレクトリ構造は次のように見えます

LLCP_VQA/

|–– config.py

|–– configs/

|–– data/

| |–– object_test_feat/

| |–– object_train_feat/

| |–– appearance_feat_rn50.h5

| |–– test_questions.pt

| |–– train_questions.pt

| |–– video_noaccident_train.txt

|–– DataLoader.py

|–– models_cvae.py

|–– requirements.txt

|–– results/

| |–– .../model_cvae49.pt

|–– README.md

|–– train.py

|–– validate.py

CVAEモデルをトレーニングするには、このコマンドを実行できます。

python train.py --cfg configs/sutd-traffic_transition.yml

訓練されたモデルを評価するには、次のことを参照してください。

python validate.py --cfg configs/sutd-traffic_transition.yml

LLCPシミュレーションを参照してください。

私たちの研究があなたの研究で役立つと思うなら、引用を検討してください:

@inproceedings{chen2024llcp,

title={LLCP: Learning Latent Causal Processes for Reasoning-based Video Question Answer},

author={Chen, Guangyi and Li, Yuke and Liu, Xiao and Li, Zijian and Al Surad, Eman and Wei, Donglai and Zhang, Kun}

booktitle={ICLR},

year={2024}

}

私たちの実装は、主にSUTD-TrafficqaとTEM-Adapterに基づいています。著者にコードをリリースしてくれたことに感謝します。