Dieses Repository enthält die Implementierung für ICLR2024 Paper LLCP: Lernen latente Kausalprozesse für argumentationsbasierte Videofrage Antwort PDF

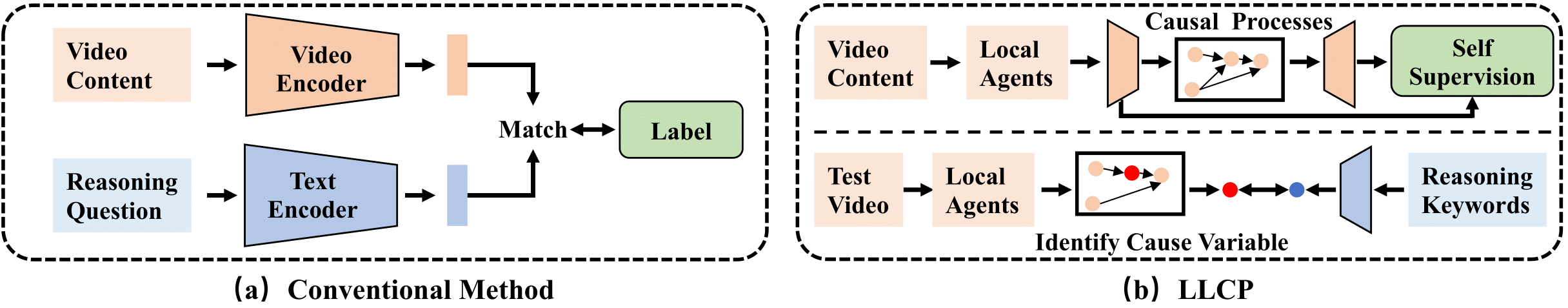

LLCP ist ein kausales Framework, das das Video-Argumentation verbessert, indem sie sich auf die räumlich-zeitliche Dynamik von Objekten innerhalb von Ereignissen konzentriert, ohne dass umfangreiche Datenanmerkungen erforderlich sind. Durch das Einsatz selbstüberwachter Lernen und Nutzung der Modularität von Kausalmechanismen lernt LLCP ein multivariates generatives Modell für die räumlich-zeitliche Dynamik und ermöglicht somit eine effektive Unfallzuordnung und kontrafaktische Vorhersage von argumentationsbasierten VideoQA.

Installieren Sie zunächst die aktuelle Version von Pytorch und Torchvision als pip install torch torchvision . Anschließend können Sie ein anderes Paket installieren, indem Sie pip install -r requirements.txt ausführen

Wir bieten die verarbeiteten Funktionen an, die in unseren Experimenten verwendet werden. Bitte laden Sie die Daten und das Modell in diesem Link1 und in diesem Link2 herunter. Dann dekomprimieren Sie die Flounder als ./data/ und ./results/ und ersetzen Sie die ursprünglichen Flounder als die heruntergeladenen.

Die Verzeichnisstruktur sollte wie aussehen wie

LLCP_VQA/

|–– config.py

|–– configs/

|–– data/

| |–– object_test_feat/

| |–– object_train_feat/

| |–– appearance_feat_rn50.h5

| |–– test_questions.pt

| |–– train_questions.pt

| |–– video_noaccident_train.txt

|–– DataLoader.py

|–– models_cvae.py

|–– requirements.txt

|–– results/

| |–– .../model_cvae49.pt

|–– README.md

|–– train.py

|–– validate.py

Um das CVAE -Modell zu trainieren, können Sie diesen Befehl ausführen:

python train.py --cfg configs/sutd-traffic_transition.yml

Um das ausgebildete Modell zu bewerten, siehe bitte:

python validate.py --cfg configs/sutd-traffic_transition.yml

Siehe LLCP-Simulation.

Wenn Sie unsere Arbeit in Ihrer Forschung nützlich finden, sollten Sie sich angeben:

@inproceedings{chen2024llcp,

title={LLCP: Learning Latent Causal Processes for Reasoning-based Video Question Answer},

author={Chen, Guangyi and Li, Yuke and Liu, Xiao and Li, Zijian and Al Surad, Eman and Wei, Donglai and Zhang, Kun}

booktitle={ICLR},

year={2024}

}

Unsere Implementierung basiert hauptsächlich auf dem SUTD-Trafficqa und dem Temadapter. Wir danken den Autoren für die Veröffentlichung ihrer Codes.