近期,人工智能领域的基准测试成为了公众关注的焦点。OpenAI的一名员工公开指责马斯克创立的AI公司xAI,称其在发布Grok3的基准测试结果时存在误导性行为。而xAI的联合创始人伊戈尔・巴布申金则对此予以否认,坚称公司的测试结果没有问题。

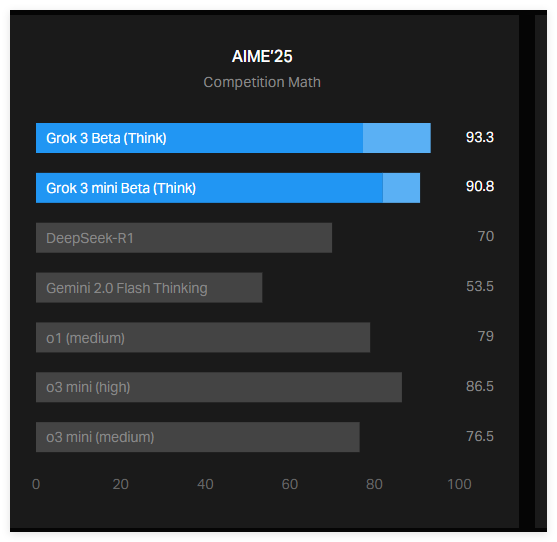

这场争议的导火索是xAI在其官方博客上发布的一张图表,展示了Grok3在AIME2025测试中的表现。AIME2025是一项基于数学邀请赛的测试,包含了一系列高难度的数学问题。尽管部分专家对AIME作为AI基准测试的有效性提出质疑,但它仍被广泛用于评估AI模型的数学能力。

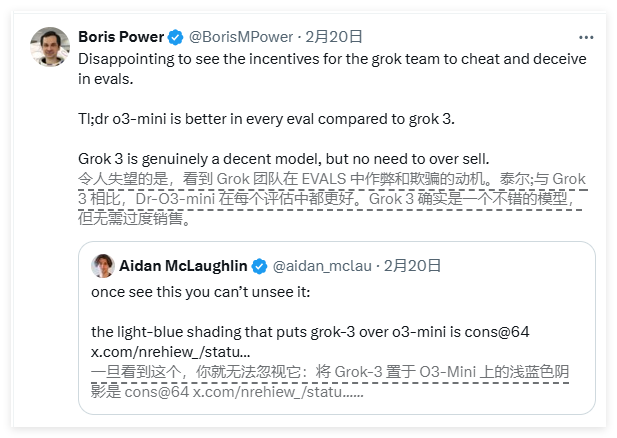

根据xAI发布的图表,Grok3的两个版本——Grok3Reasoning Beta和Grok3mini Reasoning在AIME2025测试中的表现优于OpenAI当前的最佳模型o3-mini-high。然而,OpenAI的员工迅速指出,xAI的图表中并未包含o3-mini-high在AIME2025测试中以“cons@64”方式计算的分数,这一遗漏可能对结果产生了误导。

那么,“cons@64”究竟是什么呢?它是“consensus@64”的缩写,指的是让模型对每个问题进行64次尝试,并选择出现频率最高的答案作为最终答案。这种评分机制能够显著提升模型的基准测试分数。因此,如果图表中未包含这一数据,可能会让人误以为某个模型的表现优于另一个模型,而实际情况可能并非如此。

事实上,Grok3Reasoning Beta和Grok3mini Reasoning在AIME2025测试中的“@1”分数(即模型首次尝试的分数)低于OpenAI的o3-mini-high。此外,Grok3Reasoning Beta的表现也略逊于OpenAI的o1模型。尽管如此,xAI仍然将Grok3宣传为“世界上最聪明的AI”,这进一步加剧了双方的争议。

巴布申金在社交媒体上回应称,OpenAI过去也曾发布过类似的误导性基准测试图表,主要用来对比其自身模型的表现。与此同时,一位中立的专家将各模型的表现整理成一张更为“准确”的图表,引发了更广泛的讨论。

此外,AI研究者纳森・兰伯特指出,当前AI基准测试中一个更为重要的指标仍然不明朗,那就是各模型取得最佳分数所需的计算成本和财务成本。这一问题的存在表明,现有的AI基准测试在传达模型的局限性和优势方面仍然存在不足。

总结来说,xAI与OpenAI之间关于Grok3基准测试结果的争议引发了广泛关注。xAI的图表中未包含OpenAI模型的关键评分指标“cons@64”,可能导致公众对模型表现的误解。与此同时,AI模型表现背后的计算和财务成本仍然是一个未解之谜,这进一步凸显了当前AI基准测试的局限性。