Recientemente, la evaluación comparativa en el campo de la inteligencia artificial se ha convertido en el foco de atención pública. Un empleado de Operai acusó públicamente a Xai, una compañía de IA fundada por Musk, de comportamiento engañoso cuando publicó los resultados de la prueba de referencia de GROK3. El cofundador de XAI, Igor Babushenjin, negó esto, insistiendo en que los resultados de las pruebas de la compañía no fueron problemáticos.

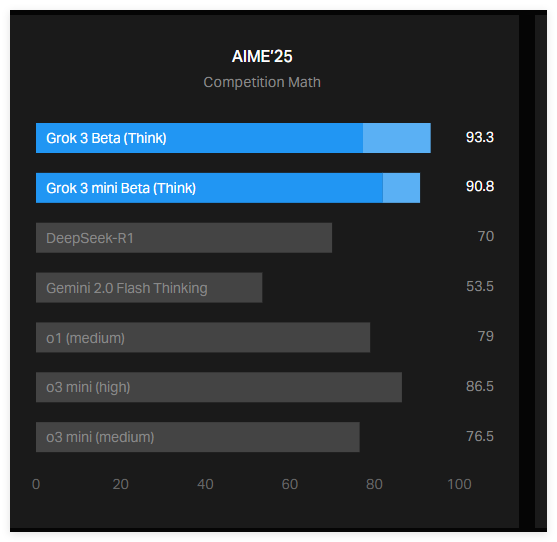

El fusible de esta controversia fue un gráfico publicado por Xai en su blog oficial que muestra cómo se realizó Grok3 en la prueba AIME2025. AIME2025 es una prueba basada en la competencia Invitational de Matemáticas, que contiene una serie de problemas matemáticos difíciles. Aunque algunos expertos cuestionan la efectividad del AIME como un punto de referencia de IA, todavía se usa ampliamente para evaluar las capacidades matemáticas de los modelos de IA.

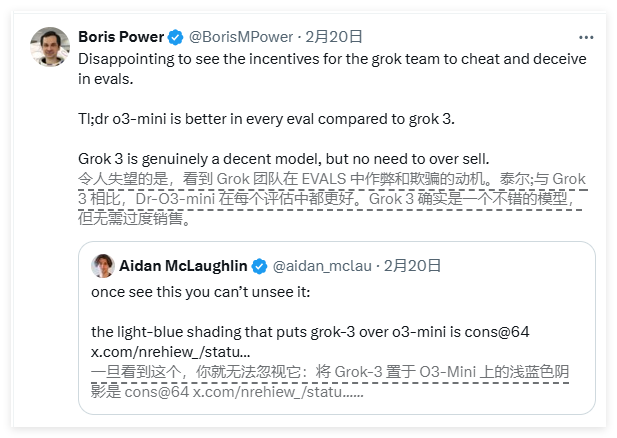

Según el cuadro publicado por Xai, las dos versiones de Grok3: Grok3Razoning Beta y Razoning Grok3mini, funcionaban mejor que el mejor modelo O3-Mini-High de OpenAI en la prueba AIME2025. Sin embargo, los empleados de Operai señalaron rápidamente que el cuadro XAI no contiene los puntajes calculados por O3-Mini-High en la prueba AIME2025 en el método "Contras@64", y esta omisión puede ser engañando los resultados.

Entonces, ¿qué es exactamente "contras@64"? Es la abreviatura de "Consenso@64", lo que significa que el modelo intente 64 veces en cada pregunta y seleccione la respuesta que aparece con mayor frecuencia como la respuesta final. Este mecanismo de puntuación puede mejorar significativamente la puntuación de referencia del modelo. Por lo tanto, si estos datos no están incluidos en el gráfico, puede confundirse con que un modelo funcione mejor que otro, y este puede no ser el caso.

De hecho, la puntuación "@1" (es decir, la puntuación del primer intento del modelo) en la prueba AIME2025 es más baja que el O3-Mini-High de OpenAI. Además, el rendimiento de Grok3Rason Beta también es ligeramente inferior al modelo O1 de OpenAI. A pesar de esto, Xai aún promueve a Grok3 como "la IA más inteligente del mundo", que exacerba aún más la controversia entre los dos lados.

Babushenjin respondió en las redes sociales que OpenAI ha publicado gráficos de referencia engañosos similares en el pasado, utilizados principalmente para comparar el rendimiento de sus propios modelos. Mientras tanto, un experto neutral organizó el rendimiento de cada modelo en un gráfico más "preciso", lo que provocó una discusión más amplia.

Además, el investigador de IA Nathan Lambert señaló que un indicador más importante en el punto de referencia de IA actual aún no está claro, es decir, los costos computacionales y financieros requeridos para cada modelo obtener el mejor puntaje. La existencia de este problema sugiere que los puntos de referencia de IA existentes todavía tienen deficiencias para comunicar las limitaciones y ventajas del modelo.

En resumen, la controversia sobre los resultados de referencia GROK3 entre Xai y OpenAI ha atraído una atención generalizada. El cuadro XAI no contiene el indicador de puntuación clave "contras@64" del modelo OpenAI, lo que puede conducir a malentendidos públicos sobre el rendimiento del modelo. Mientras tanto, los costos computacionales y financieros detrás del desempeño de los modelos de IA siguen siendo un misterio sin resolver, destacando aún más las limitaciones de los puntos de referencia de IA actuales.