Vor kurzem ist das Benchmarking im Bereich der künstlichen Intelligenz zum Schwerpunkt der öffentlichen Aufmerksamkeit geworden. Ein OpenAI -Mitarbeiter beschuldigte XAI, ein von Musk gegründeter KI -Unternehmen, öffentlich, das irreführende Verhalten zu irre, als er die Ergebnisse des Benchmark -Tests von GROK3 veröffentlichte. Der XAI-Mitbegründer Igor Babushenjin bestritt dies und bestand darauf, dass die Testergebnisse des Unternehmens nicht problematisch waren.

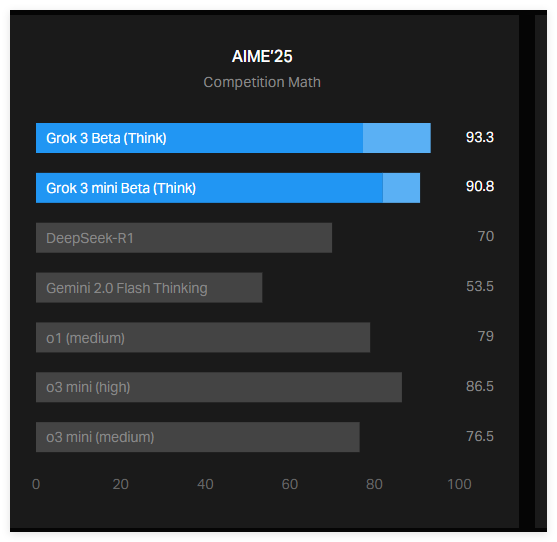

Die Sicherung dieser Kontroverse war eine Grafik von XAI auf seinem offiziellen Blog, aus denen hervorgeht, wie GROK3 im Aime2025 -Test ausgeführt wurde. Aime2025 ist ein Test, der auf dem Mathematik -Invitational -Wettbewerb basiert, der eine Reihe schwieriger mathematischer Probleme enthält. Obwohl einige Experten die Effektivität von Aime als KI -Benchmark in Frage stellen, wird es immer noch häufig verwendet, um die mathematischen Funktionen von KI -Modellen zu bewerten.

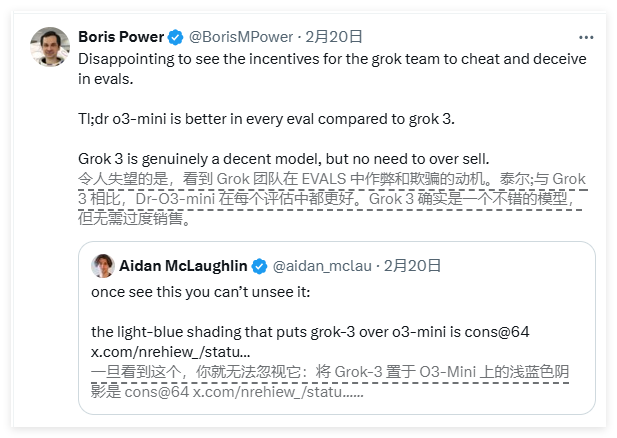

Laut dem von XAI veröffentlichten Diagramm haben die beiden Versionen von GROK3-GROK3REASONING BETA und GROK3MINI-Argumentation im Aime2025-Test besser als Openais bestes Modell O3-Mini-High als OpenAs abgewickelt. OpenAI-Mitarbeiter wiesen jedoch schnell darauf hin, dass das XAI-Diagramm nicht die nach O3-Mini-High berechneten Bewertungen im Aime2025-Test in der "cons@64" -Methode berechnet wird, und diese Auslassung kann die Ergebnisse irreführen.

Was genau ist "cons@64"? Es ist die Abkürzung von "Consensus@64", was bedeutet, dass das Modell auf jeder Frage 64 -mal versucht und die Antwort auswählt, die am häufigsten als endgültige Antwort erscheint. Dieser Bewertungsmechanismus kann den Benchmark -Score des Modells erheblich verbessern. Wenn diese Daten nicht in das Diagramm enthalten sind, kann es sein, dass ein Modell besser als ein anderes abbaut, und dies ist möglicherweise nicht der Fall.

Tatsächlich ist die "@1" -Schabe (d. H. Die Punktzahl des ersten Versuchs des Modells) im Aime2025-Test ist niedriger als das O3-Mini-Hoch von OpenAI. Darüber hinaus ist die Leistung von GROK3reasoning Beta auch dem O1 -Modell von Openai geringfügig unterlegen. Trotzdem fördert XAI GROK3 immer noch als "die intelligenteste KI der Welt", was die Kontroverse zwischen den beiden Seiten weiter verschlimmert.

Babushenjin antwortete in den sozialen Medien, dass OpenAI in der Vergangenheit ähnliche irreführende Benchmark -Charts veröffentlicht hat, die hauptsächlich zur Vergleich der Leistung seiner eigenen Modelle verwendet wurden. In der Zwischenzeit organisierte ein neutraler Experte die Leistung jedes Modells in ein „genaueres“ Diagramm und löste eine breitere Diskussion aus.

Darüber hinaus wies der AI -Forscher Nathan Lambert darauf hin, dass ein wichtigerer Indikator in der aktuellen AI -Benchmark noch unklar ist, dh die für jedes Modell erforderlichen Rechen- und Finanzkosten, um die beste Punktzahl zu erhalten. Das Vorhandensein dieses Problems legt nahe, dass bestehende KI -Benchmarks immer noch Mängel bei der Vermittlung der Einschränkungen und Vorteile des Modells aufweisen.

Zusammenfassend lässt sich sagen, dass die Kontroverse um den GROK3 -Benchmark zwischen XAI und OpenAI weit verbreitete Aufmerksamkeit erregt hat. Das XAI -Diagramm enthält nicht die wichtigste Bewertungsanzeige "cons@64" des OpenAI -Modells, was zu öffentlichen Missverständnissen über die Modellleistung führen kann. In der Zwischenzeit bleiben die rechnerischen und finanziellen Kosten für die Leistung von KI -Modellen ein ungelöstes Rätsel, was die Grenzen der aktuellen KI -Benchmarks weiter hervorhebt.