Недавно сравнительный анализ в области искусственного интеллекта стал центром внимания общественности. Сотрудник Openai публично обвинил Xai, компанию AI, основанная Musk, в заблуждении поведения, когда она выпустила результаты теста HROK3. Соучредитель XAI Игорь Бабушенценин отрицал это, настаивая на том, что результаты испытаний компании не были проблематичными.

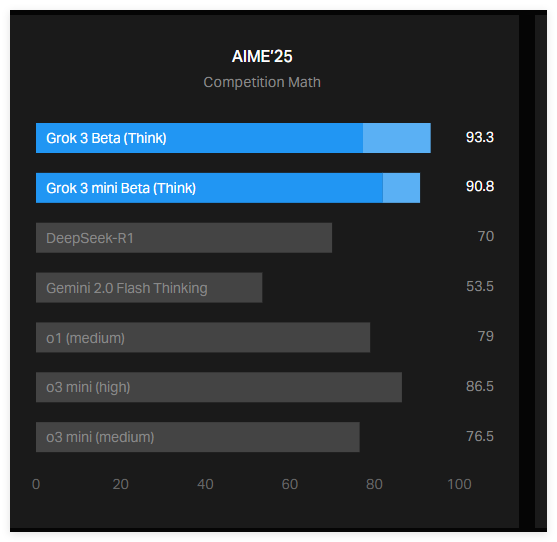

Предохранитель этого противоречия был графиком, опубликованным XAI в своем официальном блоге, показывающем, как Grok3 выступил в тесте AIME2025. AIME2025 - это тест, основанный на конкурсе по математике, который содержит ряд сложных математических задач. Хотя некоторые эксперты ставят под сомнение эффективность AIME в качестве эталона ИИ, он все еще широко используется для оценки математических возможностей моделей ИИ.

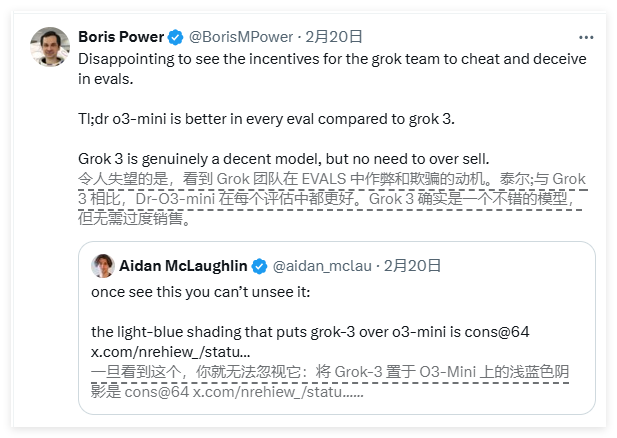

Согласно графике, опубликованной XAI, две версии Grok3-Grok3Reseing Beta и Grok3mini рассуждения, выполненные лучше, чем нынешняя лучшая модель Openai O3-Mini в тесте AIME2025. Тем не менее, сотрудники OpenAI быстро указали, что диаграмма XAI не содержит оценки, рассчитанные по O3-Mini-High в тесте AIME2025 в методе «Минусы@64», и это упущение может вводить в заблуждение результаты.

Итак, что именно такое "минусы@64"? Это аббревиатура «Консенсус@64», что означает, что модель пробует 64 раза на каждом вопросе и выберите ответ, который чаще всего появляется в качестве окончательного ответа. Этот механизм оценки может значительно улучшить контрольный балл модели. Следовательно, если эти данные не включены в диаграмму, они могут быть приняты для одной модели, чтобы работать лучше, чем другая, и это может быть не так.

Фактически, оценка «@1» (то есть оценка первой попытки модели) в тесте AIME2025 ниже, чем O3-Mini-High Of OpenAI. Кроме того, производительность Grok3Resising Beta также немного уступает модели Operai O1. Несмотря на это, XAI по -прежнему продвигает Grok3 как «самый умный ИИ в мире», который еще больше усугубляет противоречие между двумя сторонами.

В социальных сетях Babushenjin ответил, что Openai в прошлом публиковал аналогичные вводящие в заблуждение эталонные диаграммы, в основном использовавшиеся для сравнения производительности своих собственных моделей. Между тем, нейтральный эксперт организовал производительность каждой модели в более «точную» диаграмму, вызвав более широкое обсуждение.

Кроме того, исследователь искусственного интеллекта Натан Ламберт отметил, что более важный показатель в текущем эталонном эталоне все еще неясен, то есть вычислительные и финансовые затраты, необходимые для каждой модели, чтобы получить наилучший балл. Существование этой проблемы предполагает, что существующие показатели ИИ по -прежнему имеют недостатки в передаче ограничений и преимуществ модели.

Таким образом, споры по поводу результатов эталона GROK3 между XAI и OpenAI привлекли широкое внимание. Диаграмма XAI не содержит ключевого показателя оценки «CONS@64» модели OpenAI, что может привести к публичному недоразумениям о производительности модели. Между тем, вычислительные и финансовые затраты, лежащие в основе эффективности моделей искусственного интеллекта