Baru -baru ini, pembandingan di bidang kecerdasan buatan telah menjadi fokus perhatian publik. Seorang karyawan OpenAI secara publik menuduh Xai, sebuah perusahaan AI yang didirikan oleh Musk, karena perilaku menyesatkan ketika merilis hasil tes benchmark Grok3. Salah satu pendiri XAI Igor Babushenjin membantah ini, bersikeras bahwa hasil tes perusahaan tidak bermasalah.

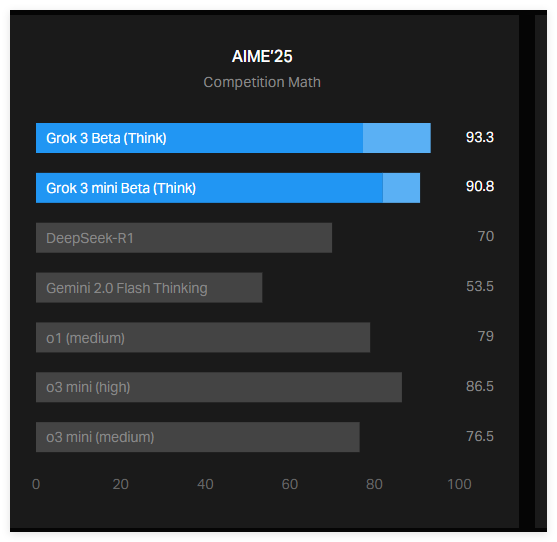

Sekring kontroversi ini adalah grafik yang diposting oleh XAI di blog resminya yang menunjukkan bagaimana GROK3 tampil dalam tes AIME2025. AIME2025 adalah tes berdasarkan kompetisi Invitational Mathematics, yang berisi serangkaian masalah matematika yang sulit. Meskipun beberapa ahli mempertanyakan efektivitas AIME sebagai tolok ukur AI, masih banyak digunakan untuk mengevaluasi kemampuan matematika model AI.

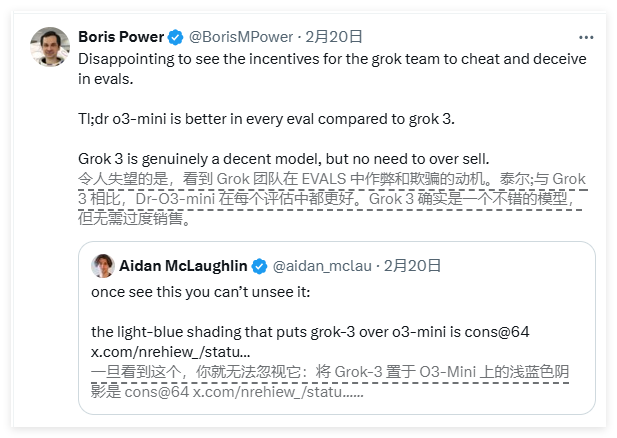

Menurut grafik yang dirilis oleh XAI, dua versi Grok3-penalaran beta dan grok3mini yang masuk gRok3Mini, berkinerja lebih baik daripada model terbaik Openai saat ini O3-mini-tinggi dalam tes AIME2025. Namun, karyawan OpenAI dengan cepat menunjukkan bahwa grafik XAI tidak mengandung skor yang dihitung dengan O3-mini-tinggi dalam tes AIME2025 dalam metode "Cons@64", dan kelalaian ini mungkin menyesatkan hasilnya.

Jadi, apa sebenarnya "kontra@64"? Ini adalah singkatan dari "konsensus@64", yang berarti memiliki model mencoba 64 kali pada setiap pertanyaan dan memilih jawaban yang paling sering muncul sebagai jawaban akhir. Mekanisme penilaian ini dapat secara signifikan meningkatkan skor benchmark model. Oleh karena itu, jika data ini tidak termasuk dalam bagan, mungkin keliru untuk satu model untuk berkinerja lebih baik dari yang lain, dan ini mungkin tidak terjadi.

Faktanya, skor "@1" (mis. Skor upaya pertama model) dalam tes AIME2025 lebih rendah dari Openai Openai. Selain itu, kinerja Beta Grok3Reasoning juga sedikit lebih rendah daripada model O1 Openai. Meskipun demikian, XAI masih mempromosikan GROK3 sebagai "AI paling cerdas di dunia", yang semakin memperburuk kontroversi antara kedua belah pihak.

Babushenjin menanggapi di media sosial bahwa Openai telah menerbitkan grafik patokan yang menyesatkan yang serupa di masa lalu, terutama digunakan untuk membandingkan kinerja modelnya sendiri. Sementara itu, seorang ahli netral mengatur kinerja masing -masing model menjadi grafik yang lebih "akurat", memicu diskusi yang lebih luas.

Selain itu, peneliti AI Nathan Lambert menunjukkan bahwa indikator yang lebih penting dalam benchmark AI saat ini masih belum jelas, yaitu, biaya komputasi dan keuangan yang diperlukan untuk setiap model untuk mendapatkan skor terbaik. Keberadaan masalah ini menunjukkan bahwa tolok ukur AI yang ada masih memiliki kekurangan dalam mengkomunikasikan keterbatasan dan keunggulan model.

Singkatnya, kontroversi tentang hasil tolok ukur GROK3 antara XAI dan OpenAI telah menarik perhatian luas. Bagan XAI tidak berisi indikator penilaian utama "Cons@64" dari model OpenAI, yang dapat menyebabkan kesalahpahaman publik tentang kinerja model. Sementara itu, biaya komputasi dan keuangan di balik kinerja model AI tetap menjadi misteri yang belum terpecahkan, lebih lanjut menyoroti keterbatasan tolok ukur AI saat ini.