최근 인공 지능 분야의 벤치마킹은 대중의 관심의 초점이되었습니다. Openai 직원은 Musk가 설립 한 AI 회사 인 Xai가 Grok3의 벤치 마크 테스트 결과를 발표했을 때 오해의 소지가있는 행동을 공개적으로 비난했습니다. Xai의 공동 창립자 인 Igor Babushenjin은 회사의 테스트 결과가 문제가되지 않는다고 주장하면서 이것을 부인했습니다.

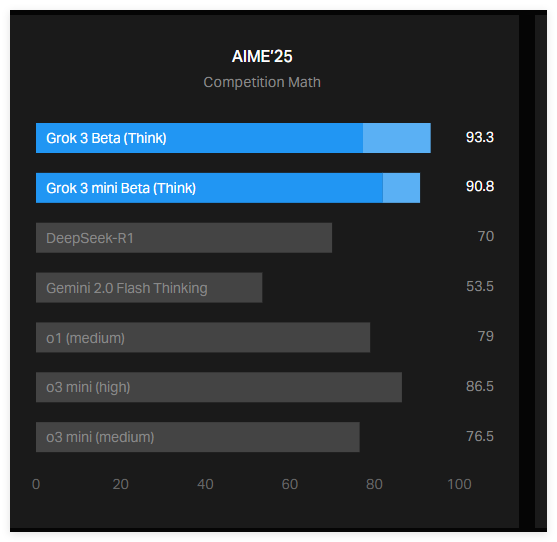

이 논쟁의 융합은 XAI가 공식 블로그에 게시 한 그래프로 AME2025 테스트에서 Grok3이 어떻게 수행되었는지를 보여줍니다. AIME2025는 수학 초청 경쟁을 기반으로 한 테스트로 일련의 어려운 수학 문제가 포함되어 있습니다. 일부 전문가들은 AI 벤치 마크로 AIME의 효과에 의문을 제기하지만 여전히 AI 모델의 수학적 기능을 평가하는 데 여전히 널리 사용됩니다.

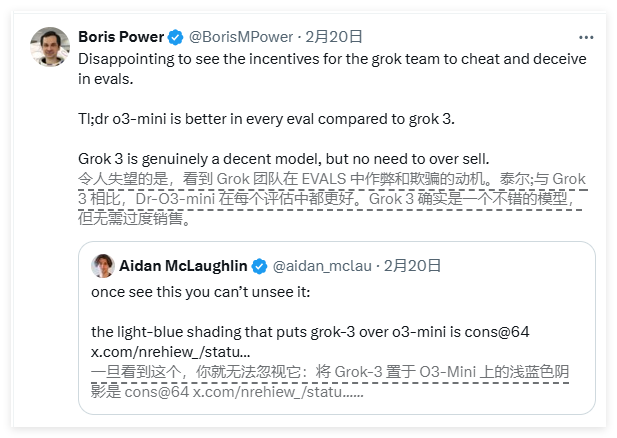

XAI가 발표 한 차트에 따르면, Grok3 (Grok3Reasoning Beta와 Grok3mini 추론)의 두 버전은 AIME2025 테스트에서 OpenAI의 현재 최고의 모델 O3-Mini-High보다 더 잘 수행되었습니다. 그러나 OpenAI 직원은 XAI 차트에 Aim2025 테스트에서 "@64"방법으로 O3-Mini-High에 의해 계산 된 점수가 포함되어 있지 않으며, 이러한 누락은 결과를 오도 할 수 있다고 지적했습니다.

그렇다면 "Cons@64"는 정확히 무엇입니까? "Consensus@64"의 약어입니다. 즉, 모델이 각 질문에서 64 번 시도하고 최종 답변으로 가장 자주 나타나는 답변을 선택하는 것을 의미합니다. 이 점수 메커니즘은 모델의 벤치 마크 점수를 크게 향상시킬 수 있습니다. 따라서이 데이터가 차트에 포함되어 있지 않으면 한 모델이 다른 모델보다 더 잘 수행되는 것으로 오인 될 수 있습니다. 그렇지 않을 수 있습니다.

실제로, AIME2025 테스트에서 "@1"점수 (즉, 모델의 첫 번째 시도의 점수)는 OpenAI의 O3-Mini-High보다 낮습니다. 또한 Grok3Reasoning Beta의 성능은 OpenAI의 O1 모델보다 약간 열등합니다. 그럼에도 불구하고 Xai는 여전히 Grok3을 "세계에서 가장 똑똑한 AI"로 홍보하며, 이는 양측 간의 논쟁을 더욱 악화시킵니다.

Babushenjin은 OpenAi가 과거에 비슷한 오해의 소지가있는 벤치 마크 차트를 발표했으며 주로 자체 모델의 성능을 비교하는 데 사용 된 소셜 미디어에 응답했습니다. 한편, 중립 전문가는 각 모델의 성능을보다 "정확한"차트로 구성하여 더 넓은 토론을 시작했습니다.

또한 AI 연구원 Nathan Lambert는 현재 AI 벤치 마크에서 더 중요한 지표는 여전히 불분명하다고 지적했다. 즉, 각 모델에 최상의 점수를 얻기 위해 필요한 계산 및 재무 비용. 이 문제의 존재는 기존 AI 벤치 마크가 여전히 모델의 한계와 장점을 전달하는 데 여전히 결점이 있음을 시사합니다.

요약하면, Xai와 Openai 사이의 Grok3 벤치 마크 결과에 대한 논쟁은 널리 퍼져 나갔다. XAI 차트에는 OpenAI 모델의 주요 점수 표시기 "Cons@64"가 포함되어 있지 않으며, 이는 모델 성능에 대한 대중의 오해로 이어질 수 있습니다. 한편, AI 모델의 성능에 대한 계산 및 재무 비용은 미해결 미스터리로 남아 있으며 현재 AI 벤치 마크의 한계를 강조합니다.