Recentemente, o benchmarking no campo da inteligência artificial tornou -se o foco da atenção do público. Um funcionário do Openai acusou publicamente a XAI, uma empresa de IA fundada por Musk, de comportamento enganoso quando divulgou os resultados do teste de referência da GROK3. O co-fundador da Xai, Igor Babushenjin, negou isso, insistindo que os resultados dos testes da empresa não fossem problemáticos.

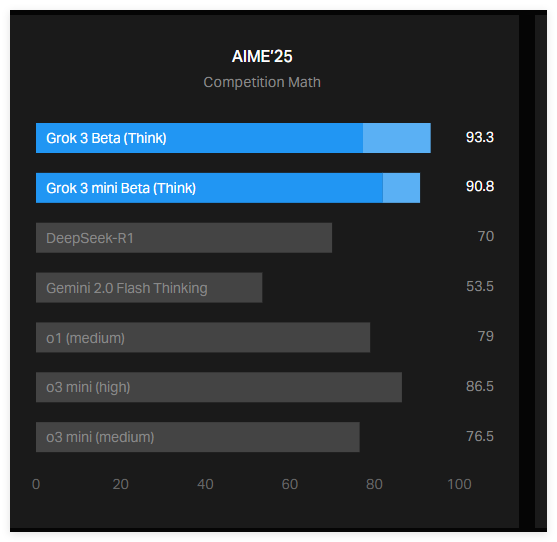

O fusível dessa controvérsia foi um gráfico publicado por Xai em seu blog oficial, mostrando como o Grok3 se saiu no teste AIME2025. O AIME2025 é um teste baseado na competição de convite de matemática, que contém uma série de problemas de matemática difíceis. Embora alguns especialistas questionem a eficácia do AIME como uma referência de IA, ele ainda é amplamente utilizado para avaliar as capacidades matemáticas dos modelos de IA.

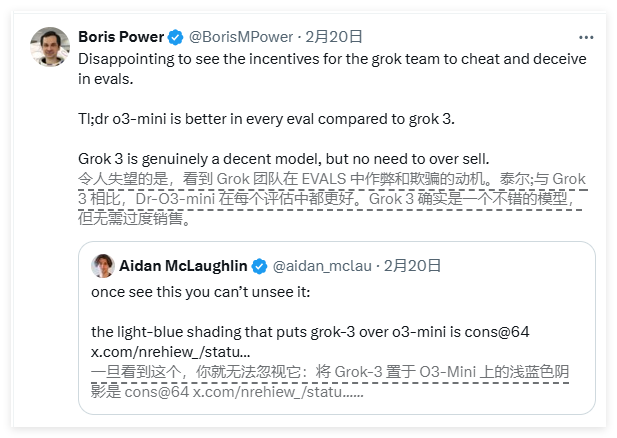

De acordo com o gráfico divulgado por Xai, as duas versões do GROK3-o raciocínio beta e Grok3mini, que geram um desempenho melhor do que o atual melhor modelo O3-Mini-alto do OpenAI no teste AIME2025. No entanto, os funcionários do OpenAI rapidamente apontaram que o gráfico XAI não contém as pontuações calculadas pelo O3-Mini-High no teste AIME2025 no método "Contras@64", e essa omissão pode estar enganando os resultados.

Então, o que exatamente é "contras@64"? É a abreviação de "Consensus@64", o que significa que o modelo tente 64 vezes em cada pergunta e selecione a resposta que aparece com mais frequência como a resposta final. Esse mecanismo de pontuação pode melhorar significativamente a pontuação de referência do modelo. Portanto, se esses dados não estiverem incluídos no gráfico, poderão ser confundidos com o desempenho de um modelo melhor que outro, e esse pode não ser o caso.

De fato, a pontuação "@1" (ou seja, a pontuação da primeira tentativa do modelo) no teste AIME2025 é menor que a altura do O3-Mini-altíssima do OpenAI. Além disso, o desempenho de Grok3Reoning Beta também é ligeiramente inferior ao modelo O1 do Openai. Apesar disso, Xai ainda promove o Grok3 como "a IA mais inteligente do mundo", que exacerba ainda mais a controvérsia entre os dois lados.

Babushenjin respondeu nas mídias sociais que o OpenAI publicou gráficos de referência enganosos semelhantes no passado, usados principalmente para comparar o desempenho de seus próprios modelos. Enquanto isso, um especialista neutro organizou o desempenho de cada modelo em um gráfico mais "preciso", provocando uma discussão mais ampla.

Além disso, o pesquisador de IA Nathan Lambert apontou que um indicador mais importante na referência atual da IA ainda não está claro, ou seja, os custos computacionais e financeiros necessários para que cada modelo obtenha a melhor pontuação. A existência desse problema sugere que os benchmarks de IA existentes ainda têm deficiências na comunicação das limitações e vantagens do modelo.

Em resumo, a controvérsia sobre os resultados de referência Grok3 entre Xai e Openai atraiu atenção generalizada. O gráfico XAI não contém o indicador de pontuação "contras@64" do modelo OpenAI, o que pode levar a mal -entendidos públicos sobre o desempenho do modelo. Enquanto isso, os custos computacionais e financeiros por trás do desempenho dos modelos de IA continuam sendo um mistério não resolvido, destacando ainda mais as limitações dos referências atuais de IA.