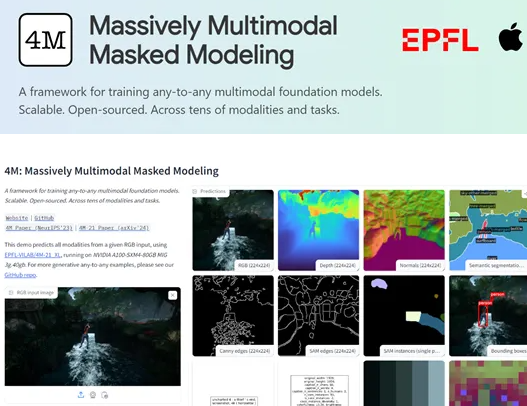

苹果公司与瑞士洛桑联邦理工学院(EPFL)携手推出了一款名为4M-21的开源多模态视觉模型,这一合作标志着人工智能领域的一次重大突破。4M-21模型以其卓越的通用性和灵活性,成为多模态学习领域的一颗新星。尽管其参数规模仅为30亿,远小于一些主流的大型模型,但它却能够在图像分类、目标检测、语义分割、实例分割、深度估计、表面法线估计等数十种任务中展现出卓越的性能。

4M-21模型的核心创新在于其“离散tokens”转换技术。这一技术能够将来自不同模态的数据,如图像、神经网络特征图、向量、结构化数据以及文本等,统一转换为模型可理解的tokens序列。这种转换不仅简化了模型的训练过程,还为多模态数据的融合与处理提供了坚实的基础。通过这一技术,4M-21能够高效地处理多种数据类型,从而在多模态学习中展现出强大的能力。

在训练过程中,4M-21采用了掩码建模的方法。这种方法通过随机遮盖输入序列中的部分tokens,并基于剩余的tokens预测被遮盖的部分,从而迫使模型学习输入数据的统计结构和潜在关系。掩码建模不仅提升了模型的泛化能力,还显著提高了其在生成任务中的准确性。这种方法的应用,使得4M-21能够在多模态学习中捕捉到不同模态间的信息共通性和交互性。

研究人员对4M-21进行了广泛的评测,涵盖了图像分类、目标检测、语义分割、实例分割、深度估计、表面法线估计以及3D人体姿态估计等多个任务。评测结果显示,4M-21在这些任务中的表现与当前最先进的模型不相上下,甚至在某些任务中超越了现有的技术。这充分证明了4M-21在多模态处理方面的卓越能力。

划重点:

- 苹果与瑞士洛桑联邦理工学院联合开源了4M-21模型,该模型以其广泛的通用性和灵活性成为多模态学习领域的重要成果。

- 4M-21能够在图像分类、目标检测、语义分割、实例分割、深度估计、表面法线估计等数十种任务中表现出色。

- 4M-21的核心技术是“离散tokens”转换,这一技术能够将多种模态的数据统一转换为模型可理解的tokens序列。