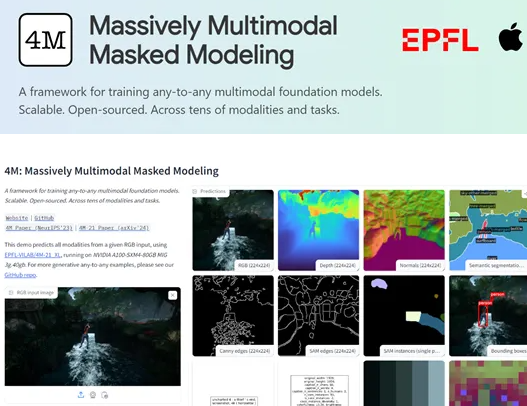

Apple과 Swiss Federal Institute of Technology (EPFL)는 공동으로 4M-21이라는 오픈 소스 멀티 모달 비전 모델을 시작했습니다. 탁월한 다양성과 유연성으로 4M-21 모델은 멀티 모달 학습 분야의 새로운 스타가되었습니다. 매개 변수 척도는 30 억에 불과하지만 일부 주류 대형 모델보다 훨씬 작지만 이미지 분류, 객체 감지, 시맨틱 세분화, 인스턴스 세분화, 깊이 추정, 표면 정상 추정 등과 같은 수십 개의 작업에서 우수성을 보여줄 수 있습니다.

4M-21 모델의 핵심 혁신은 "개별 토큰"변환 기술에 있습니다. 이 기술은 이미지, 신경망 기능 맵, 벡터, 구조화 된 데이터 및 텍스트와 같은 다른 모드에서 데이터를 모델에서 이해할 수있는 토큰 시퀀스로 균일하게 변환 할 수 있습니다. 이 변환은 모델의 훈련 프로세스를 단순화 할뿐만 아니라 멀티 모달 데이터의 융합 및 처리를위한 견고한 토대를 제공합니다. 이 기술을 통해 4M-21은 여러 데이터 유형을 효율적으로 처리하여 멀티 모달 학습에서 강력한 기능을 보여줄 수 있습니다.

훈련 과정에서 4M-21은 마스크 모델링 방법을 채택했습니다. 이 방법은 입력 순서에서 토큰의 일부를 무작위로 폐색하고 나머지 토큰을 기반으로 폐색 된 부품을 예측함으로써 모델이 입력 데이터의 통계 구조와 잠재적 관계를 학습하도록 강요합니다. 마스크 모델링은 모델의 일반화 능력을 향상시킬뿐만 아니라 생성 작업의 정확도를 크게 향상시킵니다. 이 방법을 적용하면 4M-21은 멀티 모달 학습에서 다른 모드 간의 정보 공통성과 상호 작용을 포착 할 수 있습니다.

연구원들은 이미지 분류, 객체 감지, 시맨틱 세분화, 인스턴스 세분화, 깊이 추정, 표면 정상 추정 및 3D 인간 포즈 추정과 같은 여러 작업을 다루는 4M-21의 광범위한 평가를 수행했습니다. 평가 결과는 4M-21이 이러한 작업에서 현재 최첨단 모델과 비교할 수있는 성과를 보여 주며 일부 작업에서 기존 기술을 능가한다는 것을 보여줍니다. 이것은 멀티 모달 처리에서 4M-21의 뛰어난 기능을 완전히 보여줍니다.

핵심 사항 :

- 스위스 로잔의 Apple과 Federal Institute of Federal Institute는 공동으로 4M-21 모델을 공개했습니다.이 모델은 광범위한 다양성과 유연성으로 멀티 모달 학습 분야에서 중요한 성과가되었습니다.

-4M-21은 이미지 분류, 객체 감지, 시맨틱 세분화, 인스턴스 세분화, 깊이 추정, 표면 정상 추정 등과 같은 수십 개의 작업에서 잘 수행 될 수 있습니다.

-4M-21의 핵심 기술은 "개별 토큰"변환으로 여러 양식에서 데이터를 이해할 수있는 토큰 시퀀스로 변환 할 수 있습니다.