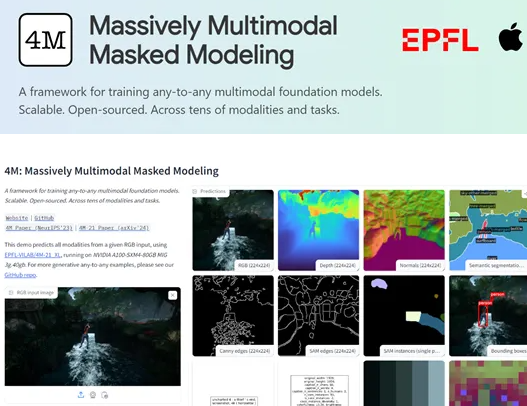

Apple et le Suisse Federal Institute of Technology (EPFL) ont lancé conjointement un modèle de vision multimodale open source appelée 4m-21. Avec son excellente polyvalence et sa flexibilité, le modèle 4m-21 est devenu une nouvelle star dans le domaine de l'apprentissage multimodal. Bien que son échelle de paramètres ne soit que de 3 milliards, beaucoup plus petite que certains grands modèles traditionnels, il peut montrer une excellence dans des dizaines de tâches telles que la classification d'image, la détection d'objets, la segmentation sémantique, la segmentation des instances, l'estimation de la profondeur, l'estimation normale de surface, etc. Performance.

L'innovation principale du modèle 4M-21 réside dans sa technologie de conversion "jetons discrètes". Cette technologie peut convertir uniformément les données à partir de différents modes, tels que les images, les cartes de fonctionnalités du réseau neuronal, les vecteurs, les données structurées et le texte, en séquences de jetons compréhensibles par le modèle. Cette transformation simplifie non seulement le processus de formation du modèle, mais fournit également une base solide pour la fusion et le traitement des données multimodales. Grâce à cette technologie, le 4m-21 peut traiter efficacement plusieurs types de données, démontrant ainsi de puissantes capacités de l'apprentissage multimodal.

Au cours du processus de formation, 4m-21 a adopté une méthode de modélisation de masque. Cette méthode oblige le modèle à apprendre la structure statistique et la relation potentielle des données d'entrée en occlus au hasard des parties des jetons dans la séquence d'entrée et en prédisant les pièces occluses en fonction des jetons restants. La modélisation des masques améliore non seulement la capacité de généralisation du modèle, mais améliore également considérablement sa précision dans la tâche de génération. L'application de cette méthode permet à 4m-21 de capturer la communauté et l'interaction des informations entre les différents modes dans l'apprentissage multimodal.

Les chercheurs ont effectué des évaluations approfondies de 4m-21, couvrant plusieurs tâches telles que la classification d'image, la détection d'objets, la segmentation sémantique, la segmentation des instances, l'estimation de la profondeur, l'estimation normale de surface et l'estimation de la pose humaine 3D. Les résultats de l'évaluation montrent que le 4m-21 fonctionne dans ces tâches comparable aux modèles actuels de pointe, et dépasse même les technologies existantes dans certaines tâches. Cela démontre entièrement les capacités exceptionnelles de 4m-21 dans le traitement multimodal.

Points clés:

- Apple et le Federal Institute of Technology of Lausanne, en Suisse, ont ouvert conjointement le modèle 4M-21, qui est devenu une réalisation importante dans le domaine de l'apprentissage multimodal avec sa large polyvalence et sa flexibilité.

- 4m-21 peut bien fonctionner dans des dizaines de tâches telles que la classification de l'image, la détection d'objets, la segmentation sémantique, la segmentation des instances, l'estimation de la profondeur, l'estimation normale de surface, etc.

- La technologie de base de 4m-21 est une conversion "jetons discrètes", qui peut transformer les données de plusieurs modalités en une séquence de jetons compréhensible.