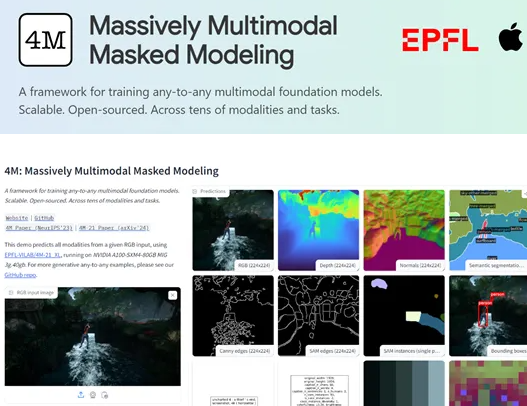

Apple y el Swiss Federal Institute of Technology (EPFL) han lanzado conjuntamente un modelo de visión multimodal de código abierto llamado 4M-21. Con su excelente versatilidad y flexibilidad, el modelo 4M-21 se ha convertido en una nueva estrella en el campo del aprendizaje multimodal. Aunque su escala de parámetros es de solo 3 mil millones, mucho más pequeña que algunos modelos grandes principales, puede mostrar excelencia en docenas de tareas como clasificación de imágenes, detección de objetos, segmentación semántica, segmentación de instancias, estimación de profundidad, estimación normal de la superficie, etc. rendimiento.

La innovación central del modelo 4M-21 radica en su tecnología de conversión "tokens discretas". Esta tecnología puede convertir uniformemente datos de diferentes modos, como imágenes, mapas de características de red neuronal, vectores, datos estructurados y texto, en secuencias de tokens que el modelo es comprensible. Esta transformación no solo simplifica el proceso de capacitación del modelo, sino que también proporciona una base sólida para la fusión y el procesamiento de datos multimodales. A través de esta tecnología, el 4M-21 puede procesar eficientemente múltiples tipos de datos, lo que demuestra capacidades poderosas en el aprendizaje multimodal.

Durante el proceso de capacitación, 4M-21 adoptó un método de modelado de máscaras. Este método obliga al modelo a aprender la estructura estadística y la relación potencial de los datos de entrada ocluyendo aleatoriamente partes de los tokens en la secuencia de entrada y prediciendo las partes ocludadas basadas en los tokens restantes. El modelado de máscaras no solo mejora la capacidad de generalización del modelo, sino que también mejora significativamente su precisión en la tarea de generación. La aplicación de este método permite que 4M-21 capturen la información en común e interacción entre diferentes modos en el aprendizaje multimodal.

Los investigadores realizaron evaluaciones extensas de 4M-21, que cubren múltiples tareas como clasificación de imágenes, detección de objetos, segmentación semántica, segmentación de instancias, estimación de profundidad, estimación normal de la superficie y estimación de pose humana 3D. Los resultados de la evaluación muestran que el 4M-21 se desempeña en estas tareas comparables a los modelos actuales de última generación, e incluso supera las tecnologías existentes en algunas tareas. Esto demuestra completamente las capacidades sobresalientes de 4M-21 en el procesamiento multimodal.

Puntos clave:

- Apple y el Instituto Federal de Tecnología de Lausana, Suiza, Open, obtuvieron conjuntamente el modelo 4M-21, que se ha convertido en un logro importante en el campo del aprendizaje multimodal con su amplia versatilidad y flexibilidad.

- 4M-21 puede funcionar bien en docenas de tareas como clasificación de imágenes, detección de objetos, segmentación semántica, segmentación de instancias, estimación de profundidad, estimación normal de la superficie, etc.

- La tecnología central de 4M-21 es la conversión de "tokens discretos", que puede transformar los datos de múltiples modalidades en una secuencia de tokens que son tokens comprensibles.