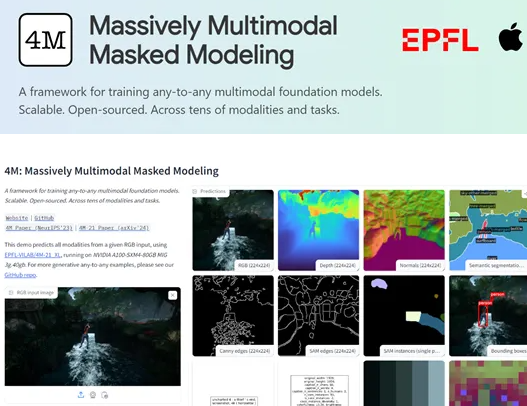

AppleとSwiss Federal Institute of Technology(EPFL)は、4M-21と呼ばれるオープンソースのマルチモーダルビジョンモデルを共同で開始しました。優れた汎用性と柔軟性により、4M-21モデルはマルチモーダル学習の分野で新しいスターになりました。そのパラメータースケールはわずか30億であり、主流の大型モデルよりもはるかに少ないが、画像分類、オブジェクト検出、セマンティックセグメンテーション、インスタンスセグメンテーション、深度推定、表面法の推定など、画像分類、セマンティックセグメンテーション、セマンティックセグメンテーション、表面推定など、多数のタスクの卓越性を示すことができます。

4M-21モデルのコアイノベーションは、「離散トークン」変換技術にあります。このテクノロジーは、画像、ニューラルネットワーク機能マップ、ベクトル、構造化データ、テキストなどのさまざまなモードからデータを均一に変換でき、モデルが理解できるトークンシーケンスに変換できます。この変換は、モデルのトレーニングプロセスを簡素化するだけでなく、マルチモーダルデータの融合と処理のための強固な基盤も提供します。このテクノロジーを通じて、4M-21は複数のデータ型を効率的に処理できるため、マルチモーダル学習に強力な機能を実証できます。

トレーニングプロセス中、4M-21はマスクモデリング方法を採用しました。この方法により、モデルは、入力シーケンスのトークンの部分をランダムに閉塞し、残りのトークンに基づいて閉塞された部分を予測することにより、入力データの統計構造と潜在的な関係を学習するように強制します。マスクモデリングは、モデルの一般化能力を改善するだけでなく、生成タスクの精度を大幅に向上させます。この方法を適用することで、4M-21は、マルチモーダル学習の異なるモード間の情報の共通性と相互作用をキャプチャできます。

研究者は、画像分類、オブジェクト検出、セマンティックセグメンテーション、インスタンスセグメンテーション、深度推定、表面正常推定、3Dヒトポーズ推定などの複数のタスクをカバーする4M-21の広範な評価を実施しました。評価結果は、4M-21がこれらのタスクで現在の最先端モデルに匹敵することを示しており、一部のタスクで既存のテクノロジーを上回っていることを示しています。これは、マルチモーダル処理における4M-21の優れた機能を完全に示しています。

キーポイント:

-Appleとスイスのローザンヌ連邦技術研究所は、4M-21モデルを共同で調達しました。

-4M-21は、画像分類、オブジェクトの検出、セマンティックセグメンテーション、インスタンスセグメンテーション、深度推定、表面通常推定など、多数のタスクでうまく機能することができます。

-4M-21のコアテクノロジーは「離散トークン」変換であり、データを複数のモダリティから理解できるトークンのトークンシーケンスに変換できます。