Xinference云·Xinference Enterprise·自我托管·文档

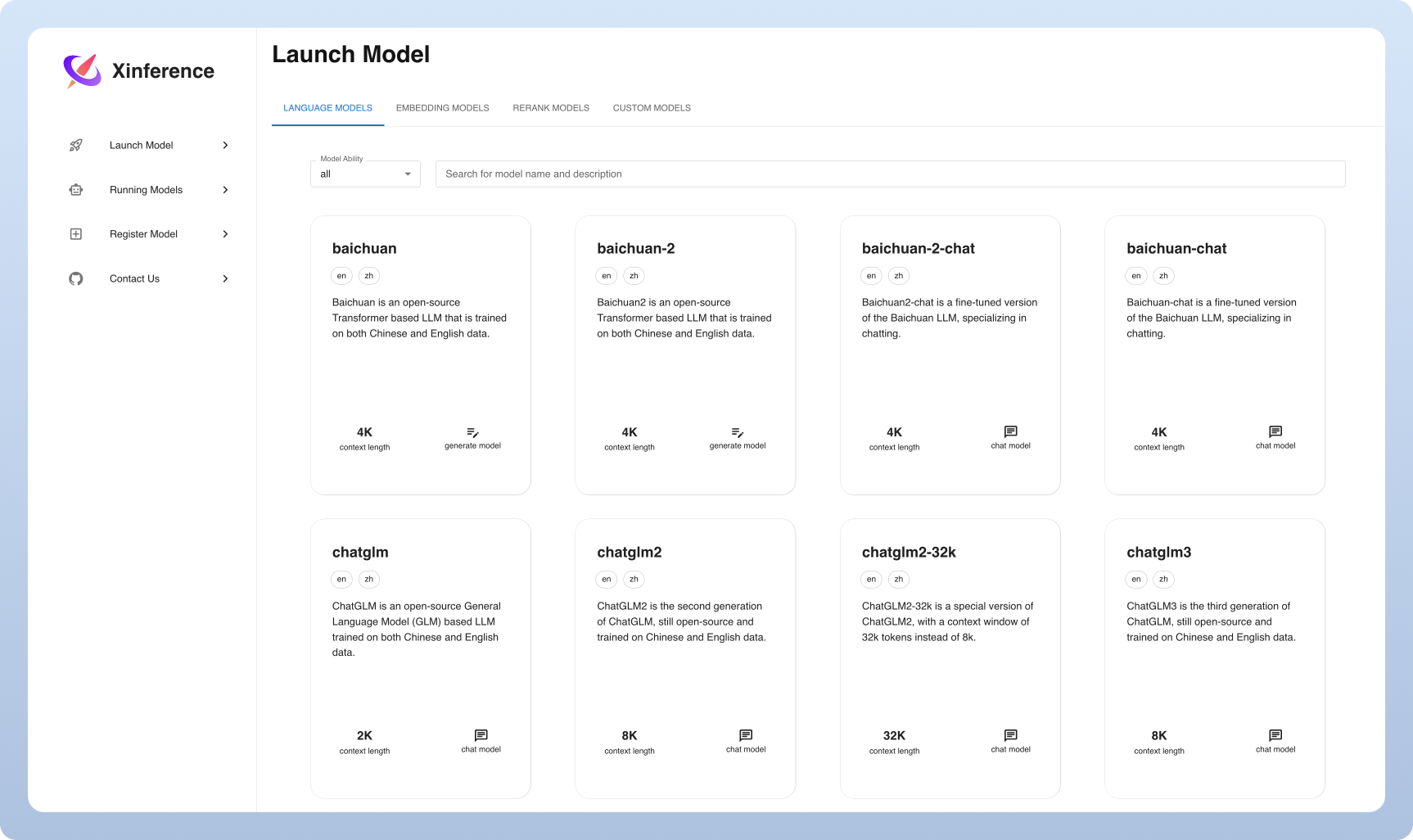

Xorbits推断(Xinference)是一个功能强大且通用的库,旨在提供语言,语音识别和多模式模型。使用Xorbits推断,您只需使用一个命令就可以毫不费力地部署并为您或最新的内置模型服务。无论您是研究人员,开发人员还是数据科学家,Xorbits推论都可以使您能够释放尖端AI模型的全部潜力。

?模型服务变得容易:简化提供大型语言,语音识别和多模式模型的过程。您可以使用一个命令来设置并部署模型进行实验和生产。

⚡️最新的模型:使用单个命令对尖端内置模型进行实验。推理可访问最先进的开源型号!

?异构硬件利用:用GGML充分利用您的硬件资源。 Xorbits推断智能地利用了包括GPU和CPU在内的异质硬件来加速您的模型推理任务。

灵活的API和接口:提供多个用于与模型交互的接口,支持OpenAI兼容的RESTFUL API(包括函数调用API),RPC,CLI和WebUI用于无缝模型管理和交互。

分布式部署:在分布式部署方案中表现出色,允许在多个设备或计算机上无缝分布模型推理。

?与第三方库的内置集成:Xorbits推断与流行的第三方库无缝集成,包括Langchain,LlamainDex,Dify和Chatbox。

| 特征 | Xinference | fastchat | Otterllm | Rayllm |

|---|---|---|---|---|

| 与OpenAi兼容的RESTFUL API | ✅ | ✅ | ✅ | ✅ |

| VLLM集成 | ✅ | ✅ | ✅ | ✅ |

| 更多推理引擎(GGML,Tensorrt) | ✅ | ✅ | ✅ | |

| 更多平台(CPU,金属) | ✅ | ✅ | ||

| 多节点群集部署 | ✅ | ✅ | ||

| 图像模型(文本到图像) | ✅ | ✅ | ||

| 文本嵌入模型 | ✅ | |||

| 多模型模型 | ✅ | |||

| 音频模型 | ✅ | |||

| 更多的OpenAI功能(函数调用) | ✅ |

云

我们托管Xinference云服务,供任何人尝试使用零设置。

自我托管Xinference社区版

通过此入门指南,快速在环境中迅速运行Xinference。使用我们的文档进行进一步的参考和更深入的说明。

企业 /组织的Xinference

我们提供其他以企业为中心的功能。给我们发送电子邮件以讨论企业需求。

在Github上的Star Xinference,并立即通知新版本。

体验Xinference的最轻方法是在Google Colab上尝试我们的Jupyter笔记本。

NVIDIA GPU用户可以使用Xinference Docker Image启动Xinference服务器。在执行安装命令之前,请确保系统上都设置了Docker和CUDA。

docker run --name xinference -d -p 9997:9997 -e XINFERENCE_HOME=/data -v < /on/your/host > :/data --gpus all xprobe/xinference:latest xinference-local -H 0.0.0.0确保您在Kubernetes群集中具有GPU支持,然后按照以下方式安装。

# add repo

helm repo add xinference https://xorbitsai.github.io/xinference-helm-charts

# update indexes and query xinference versions

helm repo update xinference

helm search repo xinference/xinference --devel --versions

# install xinference

helm install xinference xinference/xinference -n xinference --version 0.0.1-v<xinference_release_version>

有关K8S上更多自定义的安装方法,请参阅文档。

通过使用PIP安装Xinference如下。 (有关更多选项,请参见安装页面。)

pip install " xinference[all] "要启动Xinference的本地实例,请运行以下命令:

$ xinference-localXinference运行后,可以通过多种方法可以尝试:通过Web UI,通过Curl,通过命令行或通过Xinference的Python客户端。查看我们的文档以获取指南。

| 平台 | 目的 |

|---|---|

| Github问题 | 报告错误和提交功能请求。 |

| 松弛 | 与其他Xorbits用户合作。 |

| 叽叽喳喳 | 保持最新的新功能。 |

如果这项工作很有帮助,请邀请以下情况:

@inproceedings { lu2024xinference ,

title = " Xinference: Making Large Model Serving Easy " ,

author = " Lu, Weizheng and Xiong, Lingfeng and Zhang, Feng and Qin, Xuye and Chen, Yueguo " ,

booktitle = " Proceedings of the 2024 Conference on Empirical Methods in Natural Language Processing: System Demonstrations " ,

month = nov,

year = " 2024 " ,

address = " Miami, Florida, USA " ,

publisher = " Association for Computational Linguistics " ,

url = " https://aclanthology.org/2024.emnlp-demo.30 " ,

pages = " 291--300 " ,

}