Xinerference Cloud · Xinerfence Enterprise ·การโฮสต์ตัวเอง·เอกสารประกอบ

Xorbits Inference (Xinference) เป็นห้องสมุดที่ทรงพลังและหลากหลายที่ออกแบบมาเพื่อให้บริการภาษาการรู้จำเสียงพูดและแบบจำลองหลายรูปแบบ ด้วยการอนุมานของ Xorbits คุณสามารถปรับใช้และให้บริการแบบจำลองในตัวของคุณหรือล้ำสมัยโดยใช้คำสั่งเดียว ไม่ว่าคุณจะเป็นนักวิจัยนักพัฒนาหรือนักวิทยาศาสตร์ด้านข้อมูลการอนุมาน Xorbits จะช่วยให้คุณปลดปล่อยศักยภาพของโมเดล AI ที่ทันสมัยอย่างเต็มที่

- การให้บริการแบบจำลองทำได้ง่าย : ทำให้กระบวนการของการให้บริการภาษาขนาดใหญ่, การรู้จำเสียงพูดและโมเดลหลายรูปแบบ คุณสามารถตั้งค่าและปรับใช้โมเดลของคุณสำหรับการทดลองและการผลิตด้วยคำสั่งเดียว

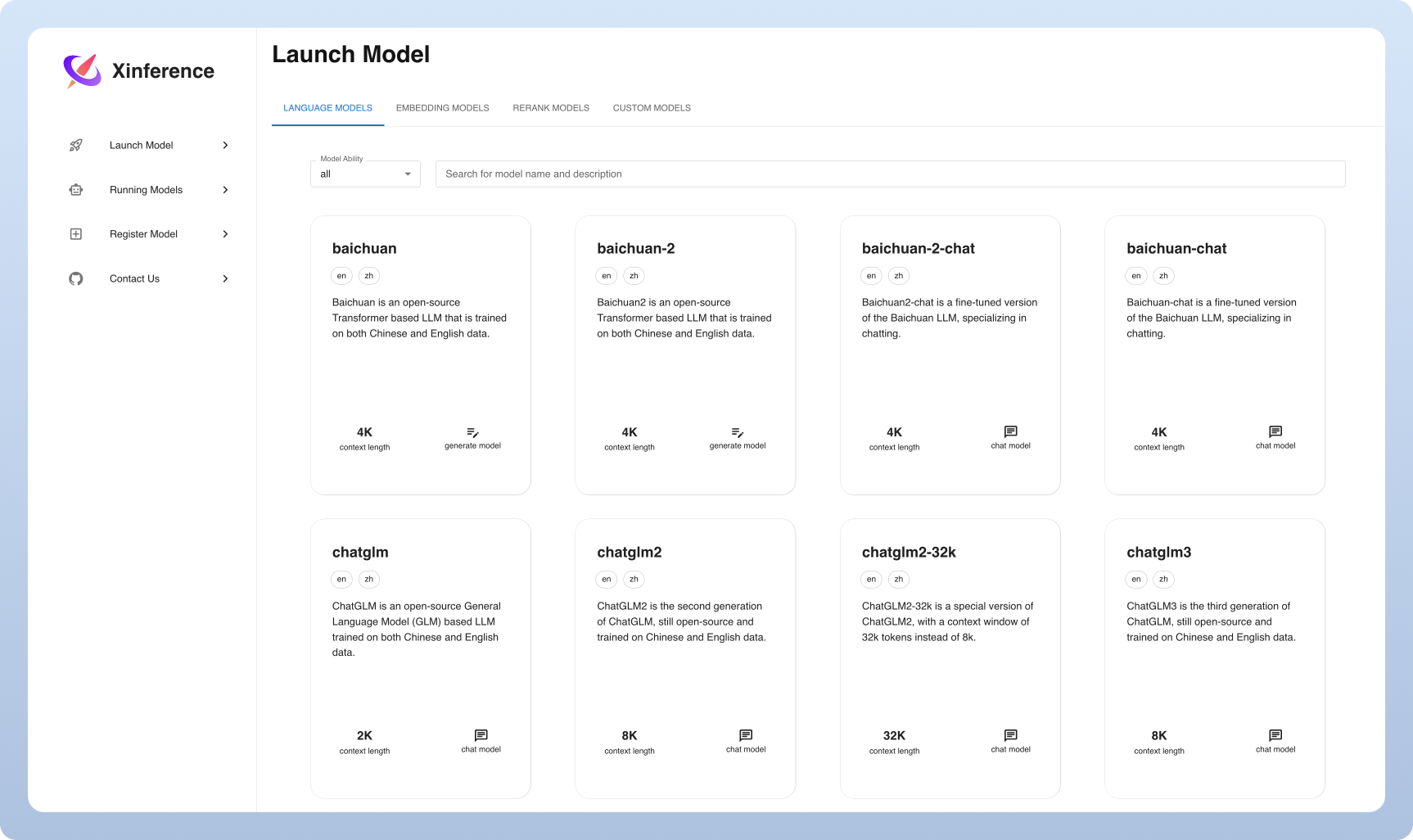

⚡ โมเดลที่ทันสมัย : ทดลองกับโมเดลในตัวที่ทันสมัยโดยใช้คำสั่งเดียว การอนุมานให้การเข้าถึงโมเดลโอเพนซอร์ซที่ทันสมัย!

- การใช้ฮาร์ดแวร์ที่แตกต่างกัน : ใช้ประโยชน์จากทรัพยากรฮาร์ดแวร์ของคุณให้ได้มากที่สุดด้วย GGML Xorbits Inference ใช้ฮาร์ดแวร์ที่แตกต่างกันอย่างชาญฉลาดรวมถึง GPU และ CPU เพื่อเร่งงานการอนุมานแบบจำลองของคุณ

API และอินเทอร์เฟซที่ยืดหยุ่น : เสนอหลายอินเทอร์เฟซสำหรับการโต้ตอบกับโมเดลของคุณรองรับ API RESTFUL ที่เข้ากันได้ของ OpenAI (รวมถึงฟังก์ชั่นการเรียก API), RPC, CLI และ WebUI สำหรับการจัดการแบบจำลองและการโต้ตอบที่ราบรื่น

การปรับใช้แบบกระจาย : Excel ในสถานการณ์การปรับใช้แบบกระจายช่วยให้การกระจายแบบจำลองการอนุมานแบบจำลองอย่างราบรื่นในอุปกรณ์หรือเครื่องจักรหลายเครื่อง

- การรวมตัวในตัวกับห้องสมุดบุคคลที่สาม : การอนุมาน Xorbits รวมเข้ากับห้องสมุดบุคคลที่สามยอดนิยมได้อย่างราบรื่นรวมถึง Langchain, Llamaidex, Dify และ Chatbox

| คุณสมบัติ | การออกเสียง | Fastchat | openllm | Rayllm |

|---|---|---|---|---|

| API พักผ่อนที่เข้ากันได้ของ Openai | ||||

| การรวม VLLM | ||||

| เอ็นจิ้นการอนุมานเพิ่มเติม (GGML, Tensorrt) | ||||

| แพลตฟอร์มเพิ่มเติม (CPU, Metal) | ||||

| การปรับใช้คลัสเตอร์แบบหลายโหนด | ||||

| รูปแบบรูปภาพ (ข้อความถึงภาพ) | ||||

| โมเดลการฝังข้อความ | ||||

| รุ่นหลายรูปแบบ | ||||

| รุ่นเสียง | ||||

| ฟังก์ชัน OpenAI เพิ่มเติม (การเรียกใช้ฟังก์ชัน) |

คลาวด์

เราโฮสต์บริการคลาวด์ Xinerference สำหรับทุกคนที่จะลองใช้การตั้งค่าเป็นศูนย์

Edition ชุมชน Xinference

ได้รับการจัดการอย่างรวดเร็วในสภาพแวดล้อมของคุณด้วยคู่มือเริ่มต้นนี้ ใช้เอกสารของเราสำหรับการอ้างอิงเพิ่มเติมและคำแนะนำในเชิงลึกเพิ่มเติม

Xinference สำหรับองค์กร / องค์กร

เรามีคุณสมบัติเพิ่มเติมขององค์กรเป็นศูนย์กลาง ส่งอีเมลถึงเราเพื่อหารือเกี่ยวกับความต้องการขององค์กร

star xinference บน GitHub และได้รับการแจ้งเตือนทันทีเกี่ยวกับการเปิดตัวใหม่

วิธีที่เบาที่สุดในการสัมผัสกับ Xinference คือลองสมุดบันทึก Jupyter ของเราบน Google Colab

ผู้ใช้ NVIDIA GPU สามารถเริ่มต้นเซิร์ฟเวอร์ XINFERIES โดยใช้ภาพ Xinerfence Docker ก่อนที่จะดำเนินการคำสั่งการติดตั้งตรวจสอบให้แน่ใจว่าทั้ง Docker และ Cuda ถูกตั้งค่าในระบบของคุณ

docker run --name xinference -d -p 9997:9997 -e XINFERENCE_HOME=/data -v < /on/your/host > :/data --gpus all xprobe/xinference:latest xinference-local -H 0.0.0.0ตรวจสอบให้แน่ใจว่าคุณมีการสนับสนุน GPU ในคลัสเตอร์ Kubernetes ของคุณจากนั้นติดตั้งดังนี้

# add repo

helm repo add xinference https://xorbitsai.github.io/xinference-helm-charts

# update indexes and query xinference versions

helm repo update xinference

helm search repo xinference/xinference --devel --versions

# install xinference

helm install xinference xinference/xinference -n xinference --version 0.0.1-v<xinference_release_version>

สำหรับวิธีการติดตั้งที่กำหนดเองเพิ่มเติมใน K8s โปรดดูเอกสารประกอบ

ติดตั้ง xinference โดยใช้ PIP ดังนี้ (สำหรับตัวเลือกเพิ่มเติมดูหน้าการติดตั้ง)

pip install " xinference[all] "ในการเริ่มต้นอินสแตนซ์ท้องถิ่นของการใช้งานให้เรียกใช้คำสั่งต่อไปนี้:

$ xinference-localเมื่อ Xinference กำลังทำงานมีหลายวิธีที่คุณสามารถลองได้: ผ่าน Web UI ผ่าน Curl ผ่านบรรทัดคำสั่งหรือผ่านไคลเอนต์ Python ของ Xinference ตรวจสอบเอกสารของเราสำหรับคำแนะนำ

| แพลตฟอร์ม | วัตถุประสงค์ |

|---|---|

| ปัญหา GitHub | การรายงานข้อบกพร่องและการร้องขอคุณสมบัติการยื่น |

| หย่อน | ร่วมมือกับผู้ใช้ Xorbits รายอื่น |

| การติดตามคุณสมบัติใหม่ ๆ |

หากงานนี้มีประโยชน์โปรดกรุณาอ้างอิงเป็น:

@inproceedings { lu2024xinference ,

title = " Xinference: Making Large Model Serving Easy " ,

author = " Lu, Weizheng and Xiong, Lingfeng and Zhang, Feng and Qin, Xuye and Chen, Yueguo " ,

booktitle = " Proceedings of the 2024 Conference on Empirical Methods in Natural Language Processing: System Demonstrations " ,

month = nov,

year = " 2024 " ,

address = " Miami, Florida, USA " ,

publisher = " Association for Computational Linguistics " ,

url = " https://aclanthology.org/2024.emnlp-demo.30 " ,

pages = " 291--300 " ,

}