Xinference Cloud · Xinerence Enterprise · Самоунижение · Документация

Вывод Xorbits (Xinerence) - это мощная и универсальная библиотека, предназначенная для обслуживания языка, распознавания речи и мультимодальных моделей. При выводе Xorbits вы можете легко развернуть и обслуживать свои или современные встроенные модели, используя только одну команду. Независимо от того, являетесь ли вы исследователем, разработчиком или ученым для данных, вывод Xorbits дает вам возможность раскрыть весь потенциал передовых моделей ИИ.

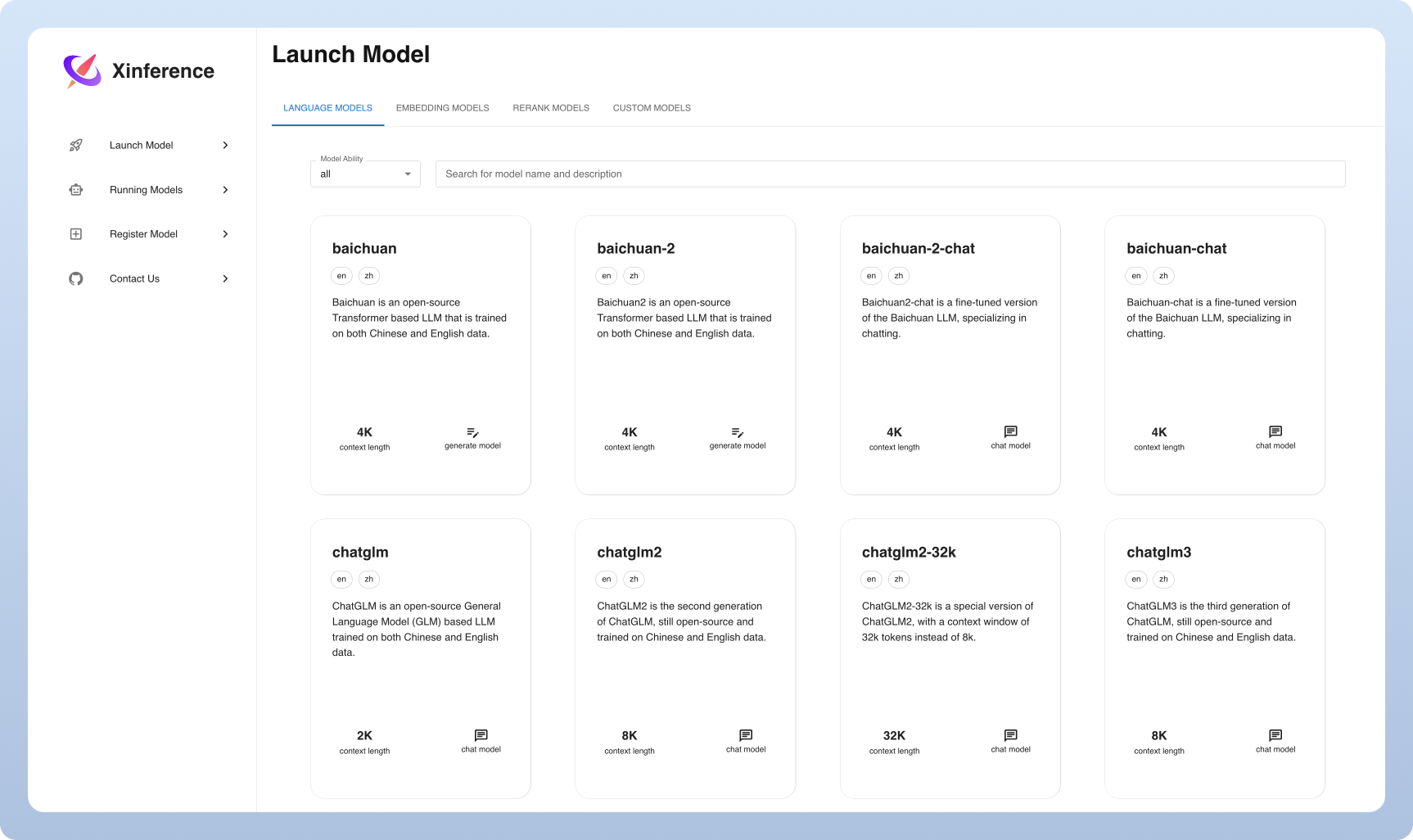

? Модель служения сделана простым : упростите процесс обслуживания большого языка, распознавания речи и мультимодальных моделей. Вы можете настроить и развернуть свои модели для экспериментов и производства с помощью одной команды.

⚡ Современные модели : экспериментируйте со передовыми встроенными моделями с использованием одной команды. Вывод обеспечивает доступ к современным моделям с открытым исходным кодом!

? Гетерогенное использование аппаратного обеспечения : максимально используйте свои аппаратные ресурсы с помощью GGML. Внедрение Xorbits интеллектуально использует гетерогенное оборудование, включая графические процессоры и процессоры, для ускорения задач вывода модели.

Гибкий API и интерфейсы : предлагайте несколько интерфейсов для взаимодействия с вашими моделями, поддерживая API RESTFUL OpenAI (включая API функции вызова), RPC, CLI и WebUI для беспрепятственного управления и взаимодействия моделей.

Распределенное развертывание : Excel в распределенных сценариях развертывания, позволяя легко распределить вывод модели на нескольких устройствах или машинах.

? Встроенная интеграция со сторонними библиотеками : вывод Xorbits плавно интегрируется с популярными сторонними библиотеками, включая Langchain, Lmamaindex, Dify и Chatbox.

| Особенность | Xinfere | Фастчат | Openllm | Rayllm |

|---|---|---|---|---|

| OpenAI-совместимый API RESTFUL | ✅ | ✅ | ✅ | ✅ |

| Интеграции VLLM | ✅ | ✅ | ✅ | ✅ |

| Больше двигателей вывода (GGML, Tensorrt) | ✅ | ✅ | ✅ | |

| Больше платформ (процессор, металл) | ✅ | ✅ | ||

| Развертывание мульти-узла кластера | ✅ | ✅ | ||

| Модели изображений (текст до изображения) | ✅ | ✅ | ||

| Текст встраивает модели | ✅ | |||

| Мультимодальные модели | ✅ | |||

| Аудио модели | ✅ | |||

| Больше функций OpenAI (вызов функции) | ✅ |

Облако

Мы проводим облачный сервис Xinerence для всех, кто может попробовать с нулевой настройкой.

Самостояние издание сообщества Xinerence

Быстро прибегайте Xinerence в вашей среде с помощью этого руководства. Используйте нашу документацию для дальнейших ссылок и дополнительных подробных инструкций.

Xinference для предприятия / организаций

Мы предоставляем дополнительные предприятия, ориентированные на предприятие. Отправьте нам электронное письмо, чтобы обсудить потребности предприятия.

Star xinference на GitHub и сразу же уведомлен о новых выпусках.

Самый легкий способ испытать Xinerence - попробовать нашу тетрадь Юпитера в Google Colab.

Пользователи NVIDIA GPU могут запустить сервер Xinference с использованием изображения Xinference Docker. Перед выполнением команды установки убедитесь, что Docker и CUDA настроены в вашей системе.

docker run --name xinference -d -p 9997:9997 -e XINFERENCE_HOME=/data -v < /on/your/host > :/data --gpus all xprobe/xinference:latest xinference-local -H 0.0.0.0Убедитесь, что у вас есть поддержка GPU в кластере Kubernetes, а затем установите следующее.

# add repo

helm repo add xinference https://xorbitsai.github.io/xinference-helm-charts

# update indexes and query xinference versions

helm repo update xinference

helm search repo xinference/xinference --devel --versions

# install xinference

helm install xinference xinference/xinference -n xinference --version 0.0.1-v<xinference_release_version>

Для получения более индивидуальных методов установки на K8, пожалуйста, обратитесь к документации.

Установите Xinfere, используя PIP следующим образом. (Для получения дополнительных параметров см. Страницу установки.)

pip install " xinference[all] "Чтобы запустить локальный экземпляр Xinference, запустите следующую команду:

$ xinference-localКак только Xinerence работает, есть несколько способов попробовать его: через веб -интерфейс через Curl, через командную строку или через клиент Python в Xinerence. Проверьте наши документы для руководства.

| Платформа | Цель |

|---|---|

| GitHub выпуски | Сообщение об ошибках и запросах функций подачи. |

| Пролечить | Сотрудничество с другими пользователями Xorbits. |

| Оставаться в курсе новых функций. |

Если эта работа полезна, пожалуйста, цитируйте как:

@inproceedings { lu2024xinference ,

title = " Xinference: Making Large Model Serving Easy " ,

author = " Lu, Weizheng and Xiong, Lingfeng and Zhang, Feng and Qin, Xuye and Chen, Yueguo " ,

booktitle = " Proceedings of the 2024 Conference on Empirical Methods in Natural Language Processing: System Demonstrations " ,

month = nov,

year = " 2024 " ,

address = " Miami, Florida, USA " ,

publisher = " Association for Computational Linguistics " ,

url = " https://aclanthology.org/2024.emnlp-demo.30 " ,

pages = " 291--300 " ,

}