Xinference Cloud · Xinference Enterprise · 자조 주최 · 문서

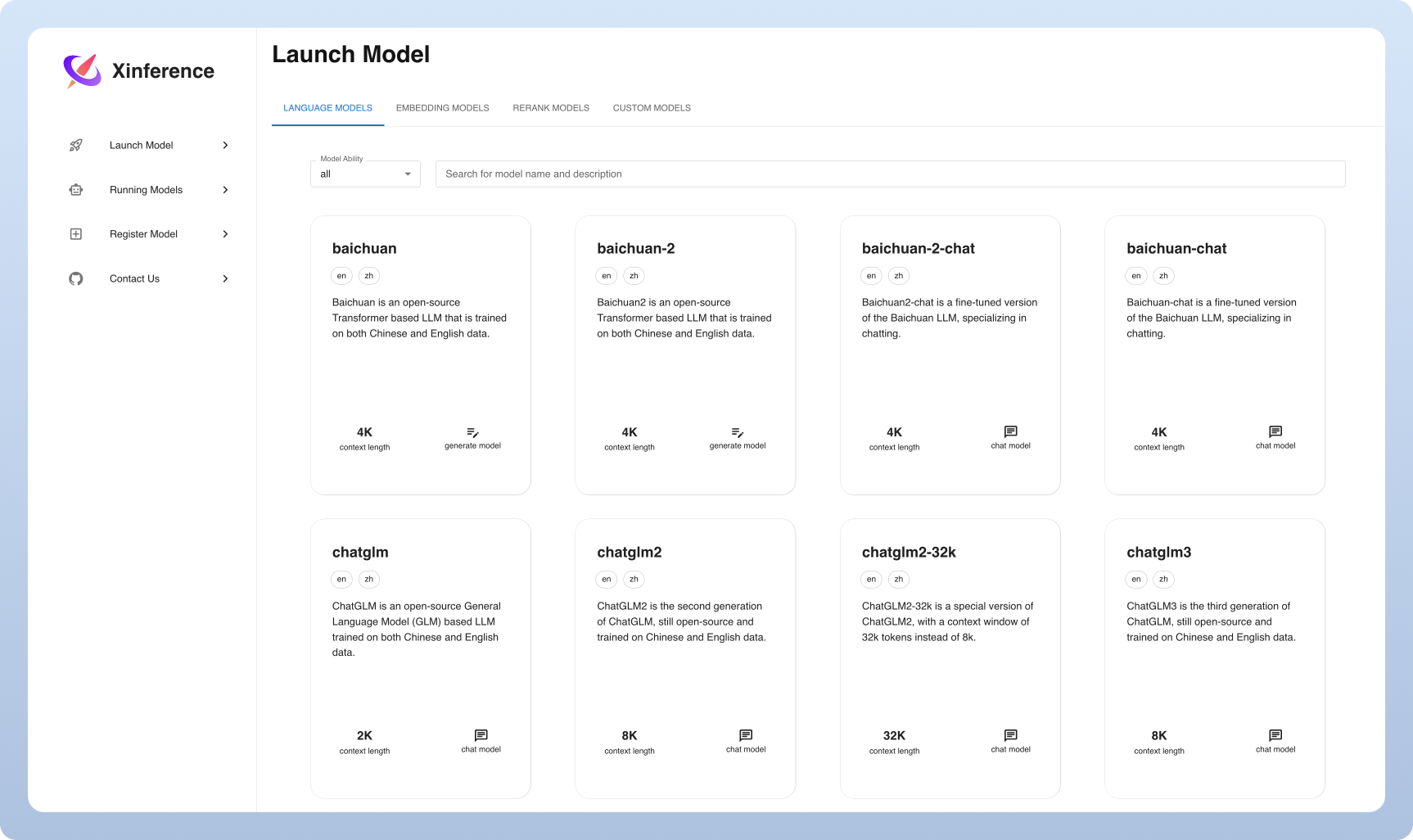

Xorbits 추론 (Xinference)은 언어, 음성 인식 및 멀티 모달 모델을 제공하도록 설계된 강력하고 다재다능한 라이브러리입니다. Xorbits 추론을 통해 단일 명령 만 사용하여 귀하 또는 최첨단 내장 모델을 쉽게 배포하고 서비스 할 수 있습니다. 귀하가 연구원, 개발자 또는 데이터 과학자이든, Xorbits 추론은 최첨단 AI 모델의 잠재력을 최대한 발휘할 수있게 해줍니다.

? 쉽게 만든 모델 서빙 : 큰 언어, 음성 인식 및 멀티 모달 모델을 제공하는 과정을 단순화합니다. 단일 명령으로 실험 및 제작을 위해 모델을 설정하고 배포 할 수 있습니다.

⚡️ 최첨단 모델 : 단일 명령을 사용한 최첨단 내장 모델을 실험하십시오. 추론은 최첨단 오픈 소스 모델에 대한 액세스를 제공합니다!

? 이기종 하드웨어 활용 : GGML을 사용하여 하드웨어 리소스를 최대한 활용하십시오. Xorbits 추론은 GPU 및 CPU를 포함한 이종 하드웨어를 지능적으로 사용하여 모델 추론 작업을 가속화합니다.

Flexible API 및 인터페이스 : 모델과 상호 작용하기위한 여러 인터페이스를 제공하여 OpenAI 호환 RESTful API (기능 호출 API 포함), RPC, CLI 및 WebUI를 지원하여 완벽한 모델 관리 및 상호 작용을 지원합니다.

분산 배포 : 분산 배포 시나리오의 Excel, 여러 장치 또는 기계에서 모델 추론의 원활한 배포를 허용합니다.

? 타사 라이브러리와의 내장 통합 : Xorbits는 Langchain, Llamaindex, Dify 및 Chatbox를 포함한 인기있는 타사 라이브러리와 완벽하게 통합됩니다.

| 특징 | xinference | Fastchat | Openllm | Rayllm |

|---|---|---|---|---|

| Openai 호환 편안한 API | ✅ | ✅ | ✅ | ✅ |

| vllm 통합 | ✅ | ✅ | ✅ | ✅ |

| 더 많은 추론 엔진 (GGML, Tensorrt) | ✅ | ✅ | ✅ | |

| 더 많은 플랫폼 (CPU, 금속) | ✅ | ✅ | ||

| 다중 노드 클러스터 배포 | ✅ | ✅ | ||

| 이미지 모델 (텍스트-이미지) | ✅ | ✅ | ||

| 텍스트 임베딩 모델 | ✅ | |||

| 멀티 모달 모델 | ✅ | |||

| 오디오 모델 | ✅ | |||

| 더 개방형 기능 (기능 호출) | ✅ |

구름

우리는 Xinference 클라우드 서비스를 호스팅하여 누구나 설정하지 않은 상태에서 시도 할 수 있습니다.

자조 Xinference Community Edition

이 스타터 가이드를 사용하여 환경에서 Xinference를 빠르게 실행하십시오. 추가 참조 및보다 심층적 인 지침을 위해 문서를 사용하십시오.

기업 / 조직을위한 Xinference

우리는 추가 엔터프라이즈 중심 기능을 제공합니다. 엔터프라이즈 요구 사항을 논의하기 위해 이메일을 보내주십시오.

Github의 Star Xinference와 새로운 릴리스를 즉시 통보받습니다.

Xinference를 경험하는 가장 가벼운 방법은 Google Colab에서 Jupyter 노트북을 사용해 보는 것입니다.

NVIDIA GPU 사용자는 Xinference Docker Image를 사용하여 Xinference Server를 시작할 수 있습니다. 설치 명령을 실행하기 전에 Docker와 Cuda가 시스템에 설정되어 있는지 확인하십시오.

docker run --name xinference -d -p 9997:9997 -e XINFERENCE_HOME=/data -v < /on/your/host > :/data --gpus all xprobe/xinference:latest xinference-local -H 0.0.0.0Kubernetes 클러스터에 GPU 지원이 있는지 확인한 다음 다음과 같이 설치하십시오.

# add repo

helm repo add xinference https://xorbitsai.github.io/xinference-helm-charts

# update indexes and query xinference versions

helm repo update xinference

helm search repo xinference/xinference --devel --versions

# install xinference

helm install xinference xinference/xinference -n xinference --version 0.0.1-v<xinference_release_version>

K8에 대한보다 맞춤형 설치 방법은 문서를 참조하십시오.

다음과 같이 PIP를 사용하여 xinference를 설치하십시오. (더 많은 옵션은 설치 페이지를 참조하십시오.)

pip install " xinference[all] "Xinference의 로컬 인스턴스를 시작하려면 다음 명령을 실행하십시오.

$ xinference-localXinference가 실행되면 웹 UI를 통해 CURL, 명령 줄을 통해 또는 Xinference의 Python 클라이언트를 통해 시도 할 수있는 여러 가지 방법이 있습니다. 가이드에 대한 문서를 확인하십시오.

| 플랫폼 | 목적 |

|---|---|

| Github 문제 | 버그보고 및 제출 기능 요청. |

| 느슨하게 | 다른 Xorbits 사용자와 협력합니다. |

| 지저귀다 | 새로운 기능에 대해 최신 상태를 유지합니다. |

이 작업이 도움이되면 친절하게 인용하십시오.

@inproceedings { lu2024xinference ,

title = " Xinference: Making Large Model Serving Easy " ,

author = " Lu, Weizheng and Xiong, Lingfeng and Zhang, Feng and Qin, Xuye and Chen, Yueguo " ,

booktitle = " Proceedings of the 2024 Conference on Empirical Methods in Natural Language Processing: System Demonstrations " ,

month = nov,

year = " 2024 " ,

address = " Miami, Florida, USA " ,

publisher = " Association for Computational Linguistics " ,

url = " https://aclanthology.org/2024.emnlp-demo.30 " ,

pages = " 291--300 " ,

}