Xinference Cloud・Xinference Enterprise・自己ホスティング・ドキュメント

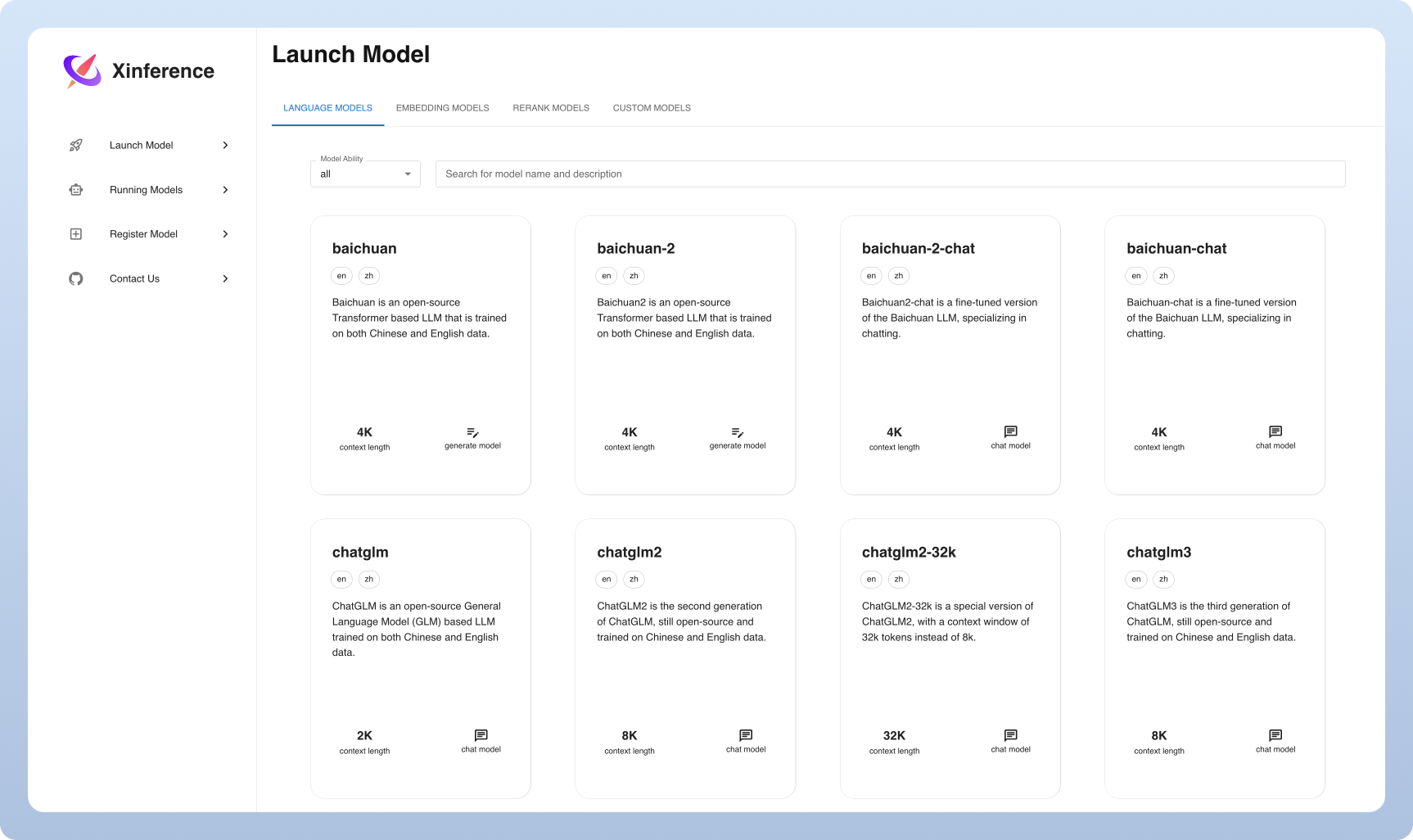

Xorbitsの推論(Xinference)は、言語、音声認識、およびマルチモーダルモデルを提供するように設計された強力で多目的なライブラリです。 Xorbitsの推論を使用すると、単一のコマンドを使用して、または最先端の組み込みモデルを簡単に展開して提供できます。あなたが研究者、開発者、またはデータサイエンティストであろうと、Xorbitsの推論は、最先端のAIモデルの可能性を最大限に発揮することを可能にします。

?モデルのサービングが簡単になりました:大規模な言語、音声認識、マルチモーダルモデルを提供するプロセスを簡素化します。単一のコマンドを使用して、実験と生産のためにモデルをセットアップして展開できます。

over-of-of-artモデル:単一のコマンドを使用して、最先端の組み込みモデルを実験します。推論は、最先端のオープンソースモデルへのアクセスを提供します!

?不均一なハードウェアの使用率:GGMLでハードウェアリソースを最大限に活用します。 Xorbitsの推論は、GPUやCPUを含む異種ハードウェアをインテリジェントに利用して、モデル推論タスクを加速します。

柔軟なAPIおよびインターフェイス:モデルと対話するための複数のインターフェイスを提供し、Seamless Modelの管理とインタラクションのために、OpenAI互換RESTFUL API(関数呼び出しAPIを含む)、RPC、CLI、WebUIをサポートします。

分散展開:分散展開シナリオでのExcel。複数のデバイスまたはマシンにわたってモデル推論のシームレスな分布を可能にします。

?サードパーティライブラリとの組み込み統合:Xorbitsの推論は、Langchain、Llamaindex、Dify、Chatboxなどの一般的なサードパーティライブラリとシームレスに統合されます。

| 特徴 | xinference | FastChat | Openllm | Rayllm |

|---|---|---|---|---|

| OpenAI互換のRESTFUL API | ✅ | ✅ | ✅ | ✅ |

| VLLM統合 | ✅ | ✅ | ✅ | ✅ |

| より多くの推論エンジン(GGML、TENSORRT) | ✅ | ✅ | ✅ | |

| その他のプラットフォーム(CPU、メタル) | ✅ | ✅ | ||

| マルチノードクラスター展開 | ✅ | ✅ | ||

| 画像モデル(テキストからイメージ) | ✅ | ✅ | ||

| テキスト埋め込みモデル | ✅ | |||

| マルチモーダルモデル | ✅ | |||

| オーディオモデル | ✅ | |||

| より多くのOpenAI機能(関数呼び出し) | ✅ |

雲

誰でもゼロセットアップで試してみるためのXinferenceクラウドサービスをホストしています。

セルフホストXinferenceコミュニティエディション

このスターターガイドを使用して、環境でXinferenceをすばやく実行してください。詳細な参照と詳細な手順については、ドキュメントを使用してください。

エンタープライズ /組織のためのXinference

追加のエンタープライズ中心の機能を提供します。エンタープライズのニーズについて話し合うためのメールを送信してください。

Githubでの星のXinferenceと新しいリリースの即座に通知されます。

Xinferenceを体験する最も軽い方法は、Google ColabでJupyterノートブックを試すことです。

NVIDIA GPUユーザーは、Xinference Docker Imageを使用してXinference Serverを開始できます。インストールコマンドを実行する前に、DockerとCUDAの両方がシステムに設定されていることを確認してください。

docker run --name xinference -d -p 9997:9997 -e XINFERENCE_HOME=/data -v < /on/your/host > :/data --gpus all xprobe/xinference:latest xinference-local -H 0.0.0.0KubernetesクラスターにGPUサポートがあることを確認し、次のようにインストールしてください。

# add repo

helm repo add xinference https://xorbitsai.github.io/xinference-helm-charts

# update indexes and query xinference versions

helm repo update xinference

helm search repo xinference/xinference --devel --versions

# install xinference

helm install xinference xinference/xinference -n xinference --version 0.0.1-v<xinference_release_version>

K8Sでのカスタマイズされたインストール方法については、ドキュメントを参照してください。

次のようにPIPを使用してXinferenceをインストールします。 (その他のオプションについては、インストールページを参照してください。)

pip install " xinference[all] "Xinferenceのローカルインスタンスを開始するには、次のコマンドを実行します。

$ xinference-localXinferenceが実行されると、試してみることができる複数の方法があります。WebUIを介して、Curlを介して、コマンドラインを介して、またはXinferenceのPythonクライアントを介して。ガイドのドキュメントをご覧ください。

| プラットフォーム | 目的 |

|---|---|

| githubの問題 | バグとファイリング機能のリクエストの報告。 |

| スラック | 他のXorbitsユーザーと協力しています。 |

| ツイッター | 新機能について最新の状態を維持します。 |

この作業が役立つ場合は、次のように引用してください。

@inproceedings { lu2024xinference ,

title = " Xinference: Making Large Model Serving Easy " ,

author = " Lu, Weizheng and Xiong, Lingfeng and Zhang, Feng and Qin, Xuye and Chen, Yueguo " ,

booktitle = " Proceedings of the 2024 Conference on Empirical Methods in Natural Language Processing: System Demonstrations " ,

month = nov,

year = " 2024 " ,

address = " Miami, Florida, USA " ,

publisher = " Association for Computational Linguistics " ,

url = " https://aclanthology.org/2024.emnlp-demo.30 " ,

pages = " 291--300 " ,

}