Xinference Cloud · Xinference Enterprise · Self-Hosting · Dokumentasi

Xorbits Inference (Xinference) adalah perpustakaan yang kuat dan serbaguna yang dirancang untuk melayani bahasa, pengenalan ucapan, dan model multimodal. Dengan inferensi Xorbits, Anda dapat dengan mudah menggunakan dan melayani model bawaan Anda atau hanya menggunakan satu perintah. Apakah Anda seorang peneliti, pengembang, atau ilmuwan data, inferensi Xorbits memberdayakan Anda untuk melepaskan potensi penuh model AI mutakhir.

? Model yang melayani menjadi mudah : Sederhanakan proses melayani bahasa besar, pengenalan ucapan, dan model multimodal. Anda dapat mengatur dan menggunakan model Anda untuk eksperimen dan produksi dengan satu perintah.

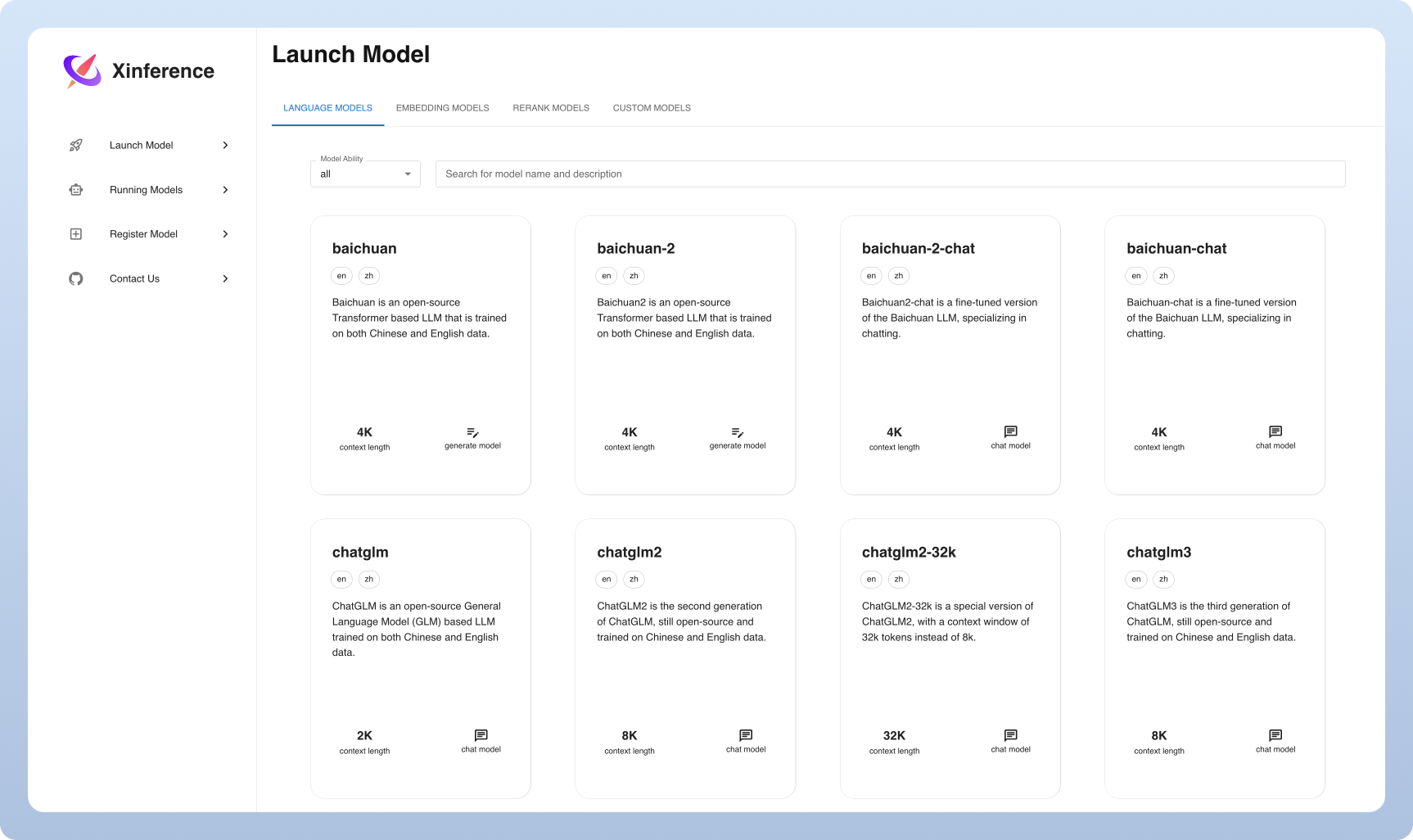

⚡️ Model canggih : Eksperimen dengan model bawaan mutakhir menggunakan perintah tunggal. Inferensi menyediakan akses ke model sumber terbuka yang canggih!

? Pemanfaatan perangkat keras yang heterogen : Manfaatkan sumber daya perangkat keras Anda dengan GGML. Xorbits Inference dengan cerdas menggunakan perangkat keras heterogen, termasuk GPU dan CPU, untuk mempercepat tugas inferensi model Anda.

API dan Antarmuka Fleksibel : Menawarkan beberapa antarmuka untuk berinteraksi dengan model Anda, mendukung API RESTful OpenAi yang kompatibel (termasuk fungsi panggilan API), RPC, CLI dan WebUI untuk manajemen dan interaksi model yang mulus.

Penyebaran Terdistribusi : Excel dalam skenario penyebaran terdistribusi, memungkinkan distribusi inferensi model yang mulus di beberapa perangkat atau mesin.

? Integrasi bawaan dengan perpustakaan pihak ketiga : Inferensi Xorbits dengan mulus terintegrasi dengan perpustakaan pihak ketiga yang populer termasuk Langchain, Llamaindex, Diy, dan Chatbox.

| Fitur | Xinference | Fastchat | Openllm | Rayllm |

|---|---|---|---|---|

| API RESTful yang kompatibel dengan Openai | ✅ | ✅ | ✅ | ✅ |

| Integrasi VLLM | ✅ | ✅ | ✅ | ✅ |

| Lebih banyak mesin inferensi (GGML, Tensorrt) | ✅ | ✅ | ✅ | |

| Lebih Banyak Platform (CPU, Logam) | ✅ | ✅ | ||

| Penyebaran Cluster Multi-Node | ✅ | ✅ | ||

| Model gambar (Teks-ke-gambar) | ✅ | ✅ | ||

| Model embedding teks | ✅ | |||

| Model multimodal | ✅ | |||

| Model audio | ✅ | |||

| Lebih banyak fungsi OpenAI (panggilan fungsi) | ✅ |

Awan

Kami meng -host layanan cloud xinference untuk siapa saja untuk mencoba dengan pengaturan nol.

Edisi Komunitas Xinferensi Self-Hosting

Dengan cepat mendapatkan xinference berjalan di lingkungan Anda dengan panduan starter ini. Gunakan dokumentasi kami untuk referensi lebih lanjut dan instruksi yang lebih mendalam.

Xinference untuk perusahaan / organisasi

Kami menyediakan fitur tambahan perusahaan-sentris. Kirimi kami email untuk membahas kebutuhan perusahaan.

Bintang Xinference di GitHub dan langsung diberitahu tentang rilis baru.

Cara paling ringan untuk mengalami xinference adalah dengan mencoba buku catatan Jupyter kami di Google Colab.

Pengguna NVIDIA GPU dapat memulai server Xinference menggunakan gambar Xinference Docker. Sebelum menjalankan perintah instalasi, pastikan bahwa Docker dan CUDA diatur pada sistem Anda.

docker run --name xinference -d -p 9997:9997 -e XINFERENCE_HOME=/data -v < /on/your/host > :/data --gpus all xprobe/xinference:latest xinference-local -H 0.0.0.0Pastikan Anda memiliki dukungan GPU di kluster Kubernetes Anda, lalu instal sebagai berikut.

# add repo

helm repo add xinference https://xorbitsai.github.io/xinference-helm-charts

# update indexes and query xinference versions

helm repo update xinference

helm search repo xinference/xinference --devel --versions

# install xinference

helm install xinference xinference/xinference -n xinference --version 0.0.1-v<xinference_release_version>

Untuk metode instalasi yang lebih disesuaikan di K8S, silakan merujuk ke dokumentasi.

Instal Xinference dengan menggunakan PIP sebagai berikut. (Untuk lebih banyak opsi, lihat halaman instalasi.)

pip install " xinference[all] "Untuk memulai instance lokal xinference, jalankan perintah berikut:

$ xinference-localSetelah Xinference berjalan, ada beberapa cara Anda dapat mencobanya: melalui Web UI, melalui Curl, melalui baris perintah, atau melalui klien Python Xinference. Lihat dokumen kami untuk panduan ini.

| Platform | Tujuan |

|---|---|

| Masalah GitHub | Melaporkan bug dan permintaan fitur pengarsipan. |

| Kendur | Berkolaborasi dengan pengguna Xorbits lainnya. |

| Tetap terkini tentang fitur baru. |

Jika pekerjaan ini bermanfaat, silakan mengutip sebagai:

@inproceedings { lu2024xinference ,

title = " Xinference: Making Large Model Serving Easy " ,

author = " Lu, Weizheng and Xiong, Lingfeng and Zhang, Feng and Qin, Xuye and Chen, Yueguo " ,

booktitle = " Proceedings of the 2024 Conference on Empirical Methods in Natural Language Processing: System Demonstrations " ,

month = nov,

year = " 2024 " ,

address = " Miami, Florida, USA " ,

publisher = " Association for Computational Linguistics " ,

url = " https://aclanthology.org/2024.emnlp-demo.30 " ,

pages = " 291--300 " ,

}