pytorch中的深入增强学习

该存储库包含Pytorch中所有基于模型和基于模型的RL算法。 (还可能包含我目前正在研究的一些研究想法)

对于pytorch-rl的C ++版本:pytorch-rl-cpp

这是什么?

Pytorch-RL在Pytorch中实现了一些最先进的深入学习算法,尤其是那些与持续动作空间有关的算法。您可以在CPU或GPU上有效训练算法。此外,Pytorch-RL开箱即用的Openai Gym。这意味着评估和使用不同算法进行播放很容易。当然,您可以根据自己的需求扩展Pytorch-rl。 TL:DR:Pytorch-RL使运行最新的深入增强学习算法变得非常容易。

安装

从PYPI安装Pytorch-RL(推荐):

PIP安装Pytorch-Policy

依赖性

- Pytorch

- 健身房(Openai)

- mujoco-py(用于体育馆的物理模拟和机器人环境)

- Pybullet(即将推出)

- MPI(仅支持MPI后端Pytorch安装)

- TensorBoardX(https://github.com/lanpa/tensorboardx)

RL算法

- DQN(带双Q学习)

- DDPG

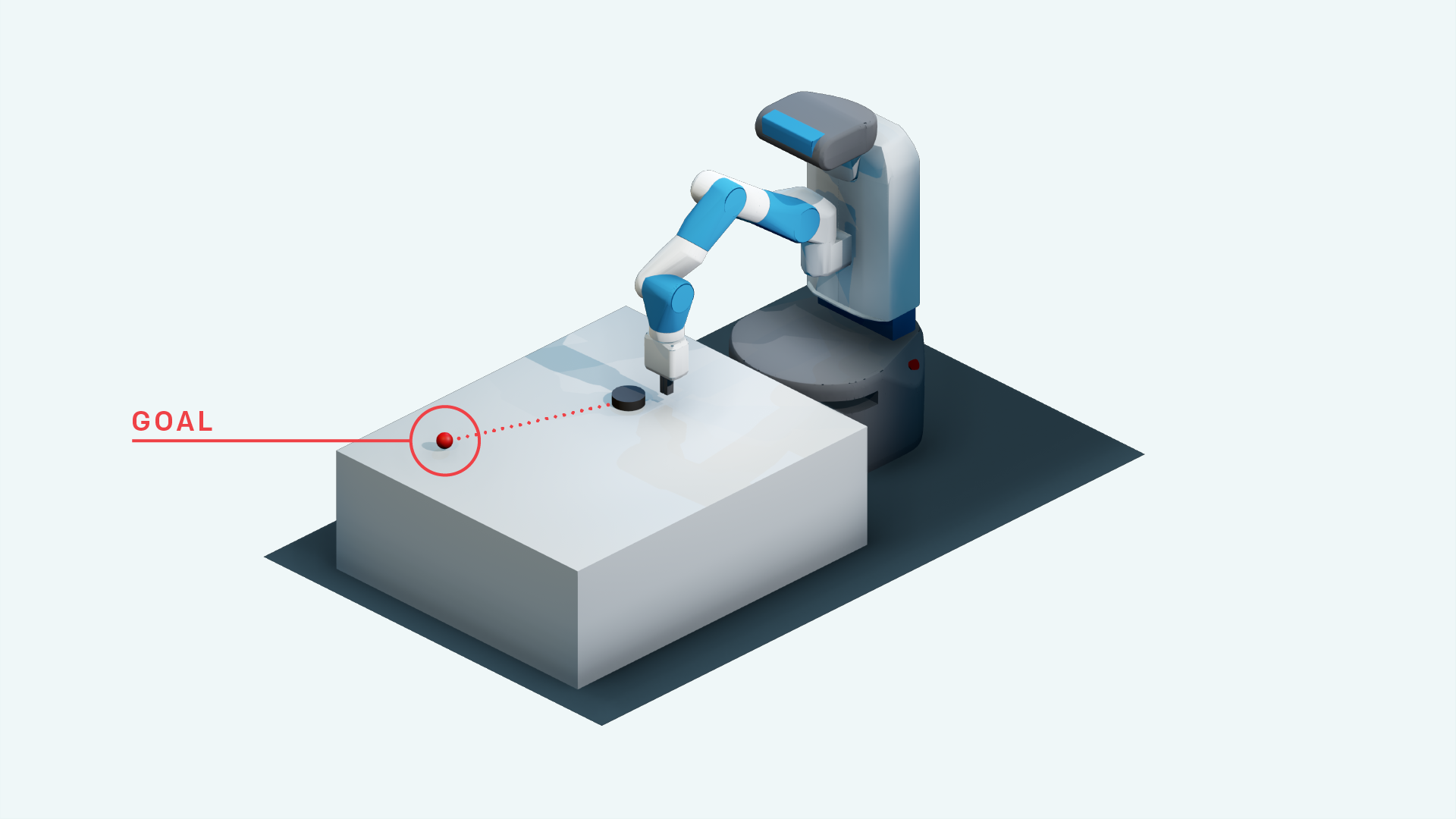

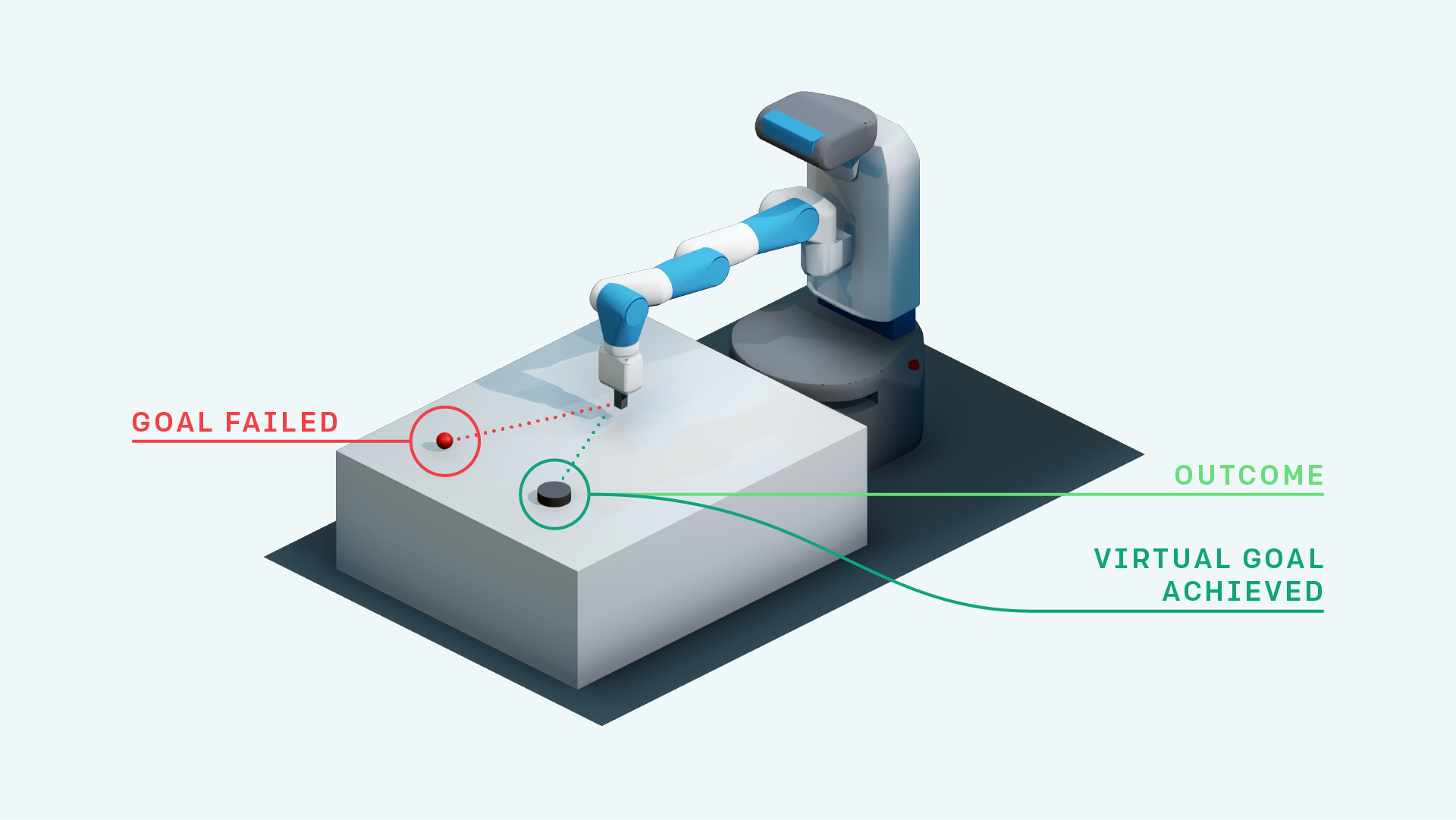

- 与她一起ddpg(用于Openai提取环境)

- 继承制度的增强学习

- 优先经验重播 + DDPG

- DDPG具有优先考虑的事后经验重播(研究)

- 具有A3C的神经图(即将推出)

- 彩虹DQN(即将推出)

- PPO(https://github.com/ikostrikov/pytorch-a2c-ppo-acktr)

- 她以自我关注的目标替代(研究)

- A3C(即将推出)

- ACER(即将推出)

- 达拉

- TDM

- 世界模型

- 软演员评论

- 授权驱动探索(TensorFlow实施:https://github.com/navneet-nmk/empowerment-powerment-drive-driven-decploration)

环境

- 突破

- 乒乓球(即将推出)

- 手工操纵机器人任务

- 提取机器人任务

- 手持机器人任务

- 块操纵机器人任务

- 蒙特祖玛的复仇(当前研究)

- 陷阱

- 重力

- 载载

- Super Mario Bros(遵循安装健身房的说明https://github.com/openai/retro)

- OpenSim Prosthetics NIPS挑战赛(https://www.crowdai.org/challenges/nips-2018-ai-for-prosthetics-challenge)

环境建模(用于探索和域的适应)

由于训练发电机和歧视者的不稳定,已经使用了多种gan训练技巧。有关更多信息,请参考https://github.com/soumith/ganhacks。

即使使用这些技巧,也很难训练gan融合。但是,在使用光谱归一化(https://arxiv.org/abs/1802.05957)之后,Infogan进行了训练以收敛。

对于图像以使用gan和VAE的图像图像翻译任务,Skip Connection的培训确实有助于培训。

- beta-vae

- Infogan

- cvae-gan

- 基于流量的生成模型(研究)

- 萨根

- 顺序参加,推断,重复

- 好奇心驱动的探索

- 探索的参数空间噪声

- 嘈杂的网络

参考

- 与深度强化学习一起玩atari,Mnih等,2013

- 通过深度强化学习的人类水平控制,Mnih等,2015

- 通过双Q学习深度加固学习,Van Hasselt等,2015

- Lillicrap等,2015

- CVAE-GAN:通过不对称训练生成细粒的图像,Bao等,2017

- Beta-vae:Higgins等人,2017年学习基本的视觉概念

- Hindsight Experience重播,Andrychowicz等,2017

- Infogan:可解释的表示通过信息通过最大化生成对抗网的信息,Chen等,2016

- 世界模型,Ha等,2018

- 生成对抗网络的光谱归一化,Miyato等,2018

- 自我发作的生成对抗网络,Zhang等,2018

- 好奇心驱动的自我监督预测的探索,Pathak等,2017

- 软演员 - 批评:与随机演员的非政策最大熵深钢筋学习,Haarnoja等,2018

- 参数探索的参数空间噪声,Plappert等,2018

- Fortunato等,2018

- 近端政策优化算法,Schulman等,2017

- 通过赋权无监督的实时控制,Karl等,2017

- 共同信息神经估计,Belghazi等,2018

- 使用共同信息估计的授权驱动探索,Kumar等,2018