Pytorchの深い補強学習

このリポジトリには、Pytorchのすべての標準モデルフリーおよびモデルベースの(来る)RLアルゴリズムが含まれています。 (私が現在取り組んでいるいくつかの研究のアイデアも含まれているかもしれません)

pytorch-rlのC ++バージョン:pytorch-rl-cpp

それは何ですか?

Pytorch-RLは、Pytorchの最先端の深い強化学習アルゴリズム、特に継続的な行動スペースに関係するものを実装しています。アルゴリズムをCPUまたはGPUで効率的にトレーニングできます。さらに、Pytorch-RLはOpenai Gymを箱から出して動作します。これは、異なるアルゴリズムを評価して遊ぶのが簡単であることを意味します。もちろん、あなた自身のニーズに応じてPytorch-RLを拡張できます。 TL:DR:Pytorch-RLにより、最先端のディープ補強学習アルゴリズムを簡単に実行できます。

インストール

Pytorch-RLをPypiからインストールします(推奨):

ピップインストールpytorch-policy

依存関係

- Pytorch

- ジム(オープン)

- Mujoco-Py(ジムの物理シミュレーションとロボティクスenv用)

- pybullet(近日公開)

- MPI(MPIバックエンドPytorchのインストールでのみサポート)

- tensorboardx(https://github.com/lanpa/tensorboardx)

RLアルゴリズム

- dqn(ダブルq学習付き)

- DDPG

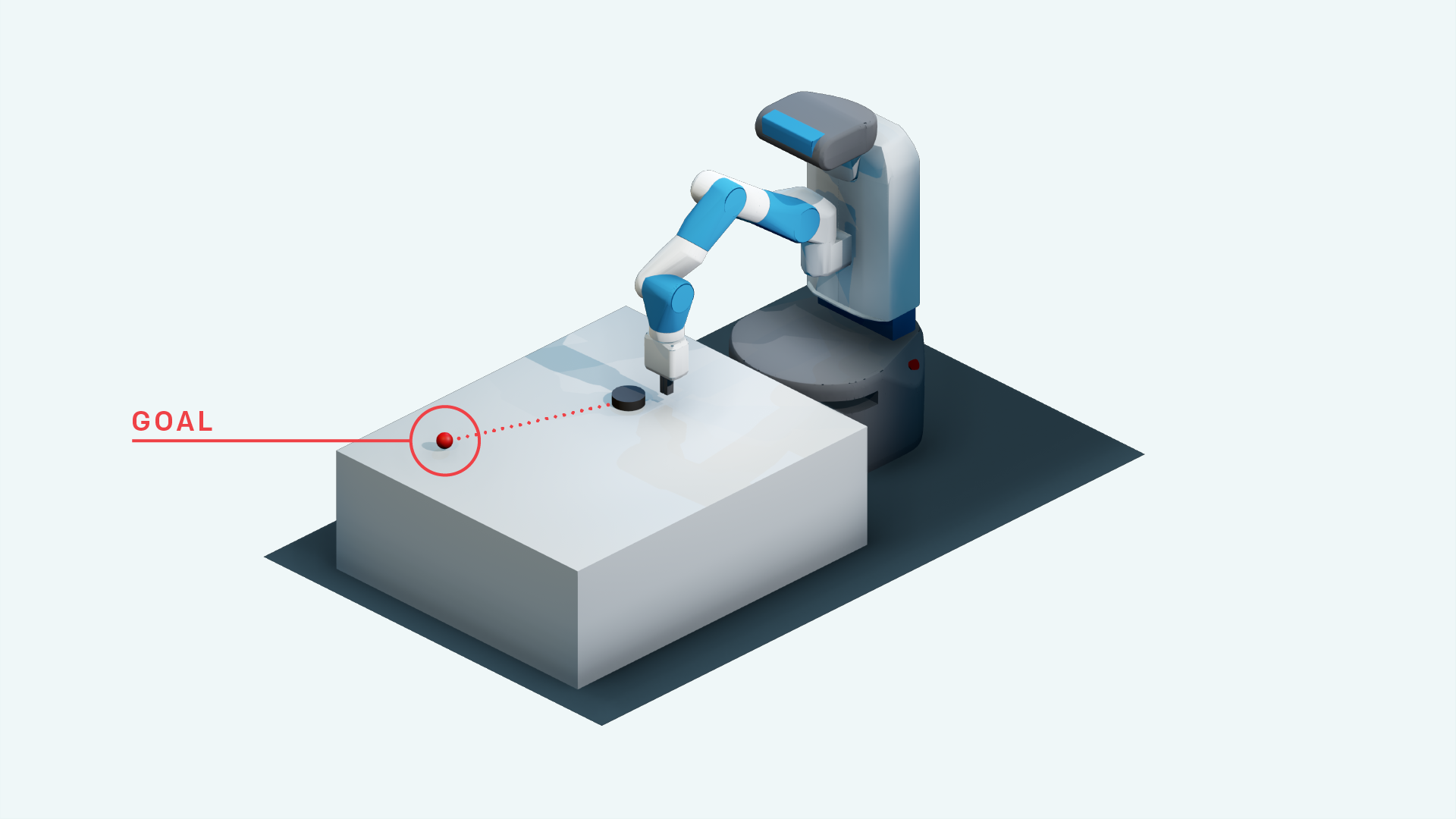

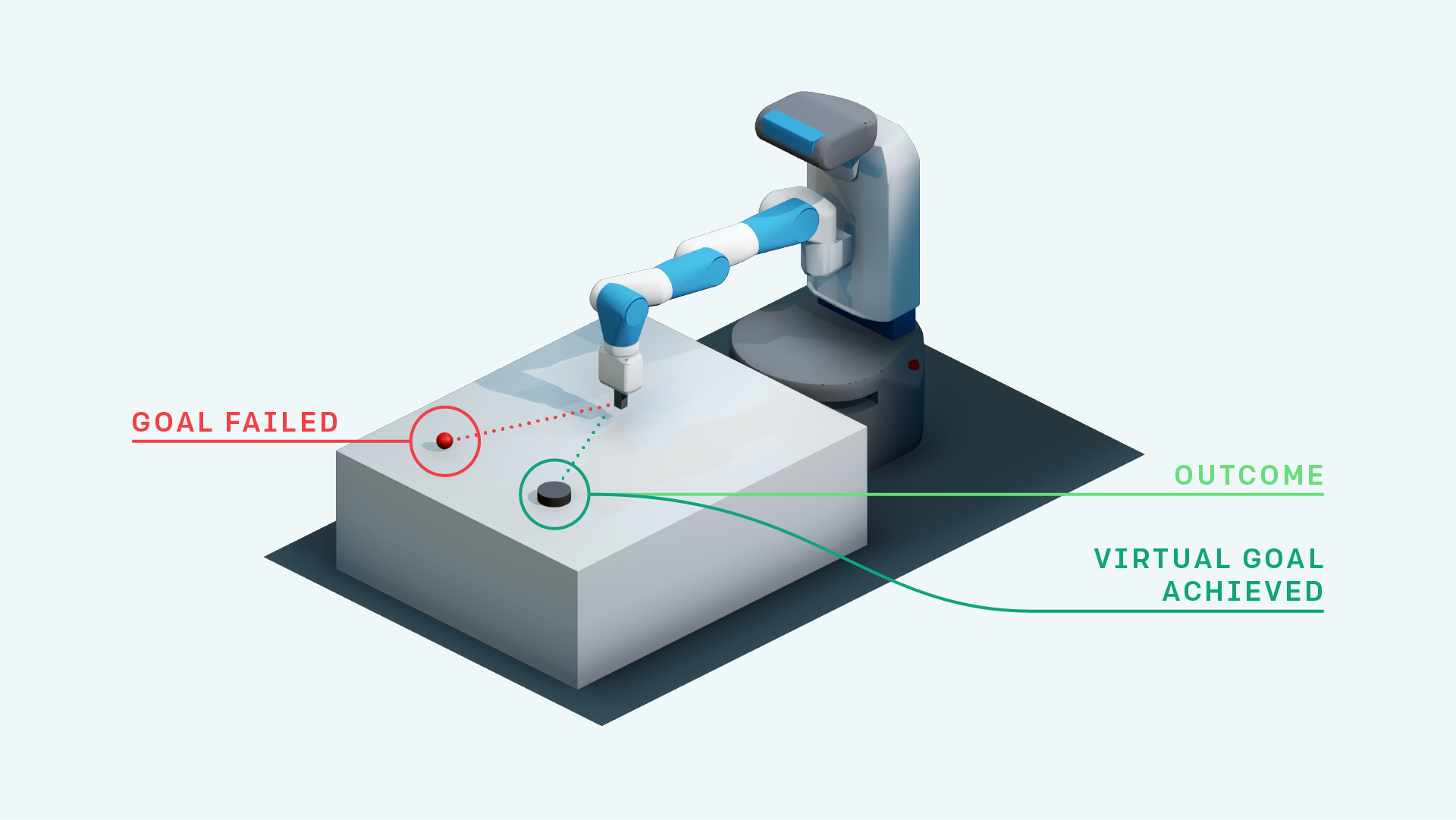

- 彼女とのDDPG(Openai Fetch環境の場合)

- 相続補強学習

- 優先順位付けされたエクスペリエンスリプレイ + DDPG

- 優先順位付けされた後知恵体験リプレイを備えたDDPG(研究)

- A3cのニューラルマップ(近日公開)

- レインボーDQN(近日公開)

- PPO(https://github.com/ikostrikov/pytorch-a2c-ppo-acktr)

- 目標代替のために自己注意を払っている(研究)

- A3c(近日公開)

- Acer(近日公開)

- ダーラ

- TDM

- 世界モデル

- ソフト俳優批評家

- エンパワーメント駆動型探査(TensorFlow実装:https://github.com/navneet-nmk/empowerment-driven-exploration)

環境

- 起こる

- ポン(近日公開)

- ハンドマニピュレーションロボットタスク

- フェッチリーチロボットタスク

- ハンドリーチロボットタスク

- ブロック操作ロボットタスク

- モンテズマの復ven(現在の研究)

- 落とし穴

- グラビタ

- キャラシング

- スーパーマリオブラザーズ(ジム - レトロhttps://github.com/openai/retroのインストールの指示に従ってください)

- opensim prsthetics nips Challenge(https://www.crowdai.org/challenges/nips-2018-ai-for-prusthetics-challenge)

環境モデリング(探索とドメインの適応のため)

ジェネレーターと判別器のトレーニングに不安定性があるため、複数のGANトレーニングトリックが使用されています。詳細については、https://github.com/soumith/ganhacksを参照してください。

トリックを使用した後でも、ガンを収束するように訓練することは本当に困難でした。ただし、スペクトル正規化(https://arxiv.org/abs/1802.05957)を使用した後、インフォガンは収束のために訓練されました。

Image to Image Translation Tasks with Gansと一般的なVAEの場合、Skip Connectionでのトレーニングは、トレーニングに本当に役立ちます。

- ベータヴェ

- インフォガン

- cvae-gan

- フローベースの生成モデル(研究)

- サガン

- シーケンシャルに出席し、推測し、繰り返します

- 好奇心駆動型探査

- 探索のためのパラメータースペースノイズ

- 騒々しいネットワーク

参照

- 深い補強学習でアタリをプレイする、Mnih et al。、2013

- 深い強化学習による人間レベルの制御、Mnih et al。、2015

- ダブルQラーニングによる深い補強学習、van Hasselt et al。、2015

- 深い強化学習を伴う継続的な制御、Lillicrap et al。、2015

- CVAE-GAN:非対称トレーニングを通じて微調整された画像生成、Bao et al。、2017

- Beta-Vae:制約された変動フレームワークを使用した基本的な視覚概念の学習、Higgins et al。、2017

- Hindsight Experience Replay、Andrychowicz et al。、2017

- Infogan:情報による解釈可能な表現学習生成敵の網を最大化する、Chen et al。、2016

- World Models、Ha et al。、2018

- 生成敵のネットワークのスペクトル正規化、Miyato et al。、2018

- 自己関節生成敵対的ネットワーク、Zhang et al。、2018

- 自己監視された予測による好奇心による探求、Pathak et al。、2017

- ソフト俳優批評家:確率的俳優とのオフポリシー最大エントロピーディープ補強学習、Haarnoja et al。、2018

- パラメータースペース探索のためのノイズ、Plappert et al。、2018

- 探検のための騒音ネットワーク、Fortunato et al。、2018

- 近位政策最適化アルゴリズム、Schulman et al。、2017

- 変分エンパワーメントによる監視なしリアルタイムコントロール、Karl et al。、2017

- 相互情報ニューラル推定、Belghazi et al。、2018

- 相互情報推定を使用したエンパワーメント主導の探索、Kumar et al。、2018