การเรียนรู้การเสริมแรงอย่างลึกซึ้งใน Pytorch

พื้นที่เก็บข้อมูลนี้มีอัลกอริทึม RL แบบฟรีแบบจำลองและแบบจำลองทั้งหมด (มา) ใน Pytorch (อาจมีแนวคิดการวิจัยบางอย่างที่ฉันกำลังทำอยู่ในปัจจุบัน)

สำหรับ c ++ เวอร์ชันของ pytorch-rl: pytorch-rl-cpp

มันคืออะไร?

Pytorch-RL ใช้อัลกอริธึมการเรียนรู้การเสริมแรงอย่างลึกล้ำของศิลปะใน Pytorch โดยเฉพาะอย่างยิ่งผู้ที่เกี่ยวข้องกับพื้นที่แอ็คชั่นอย่างต่อเนื่อง คุณสามารถฝึกอัลกอริทึมของคุณได้อย่างมีประสิทธิภาพทั้งใน CPU หรือ GPU นอกจากนี้ Pytorch-RL ยังทำงานร่วมกับ Openai Gym นอกกรอบ ซึ่งหมายความว่าการประเมินและเล่นกับอัลกอริทึมที่แตกต่างกันนั้นง่าย แน่นอนคุณสามารถขยาย Pytorch-RL ตามความต้องการของคุณเอง TL: DR: Pytorch-RL ทำให้ง่ายต่อการใช้อัลกอริธึมการเรียนรู้การเสริมแรงที่ล้ำสมัย

การติดตั้ง

ติดตั้ง Pytorch-RL จาก PYPI (แนะนำ):

PIP ติดตั้ง pytorch-policy

การพึ่งพาอาศัยกัน

- pytorch

- โรงยิม (Openai)

- Mujoco-py (สำหรับการจำลองฟิสิกส์และหุ่นยนต์ env ในโรงยิม)

- Pybullet (เร็ว ๆ นี้)

- MPI (รองรับการติดตั้ง MPI Backend Pytorch เท่านั้น)

- tensorboardx (https://github.com/lanpa/tensorboardx)

อัลกอริทึม RL

- DQN (พร้อมการเรียนรู้สองครั้ง)

- DDPG

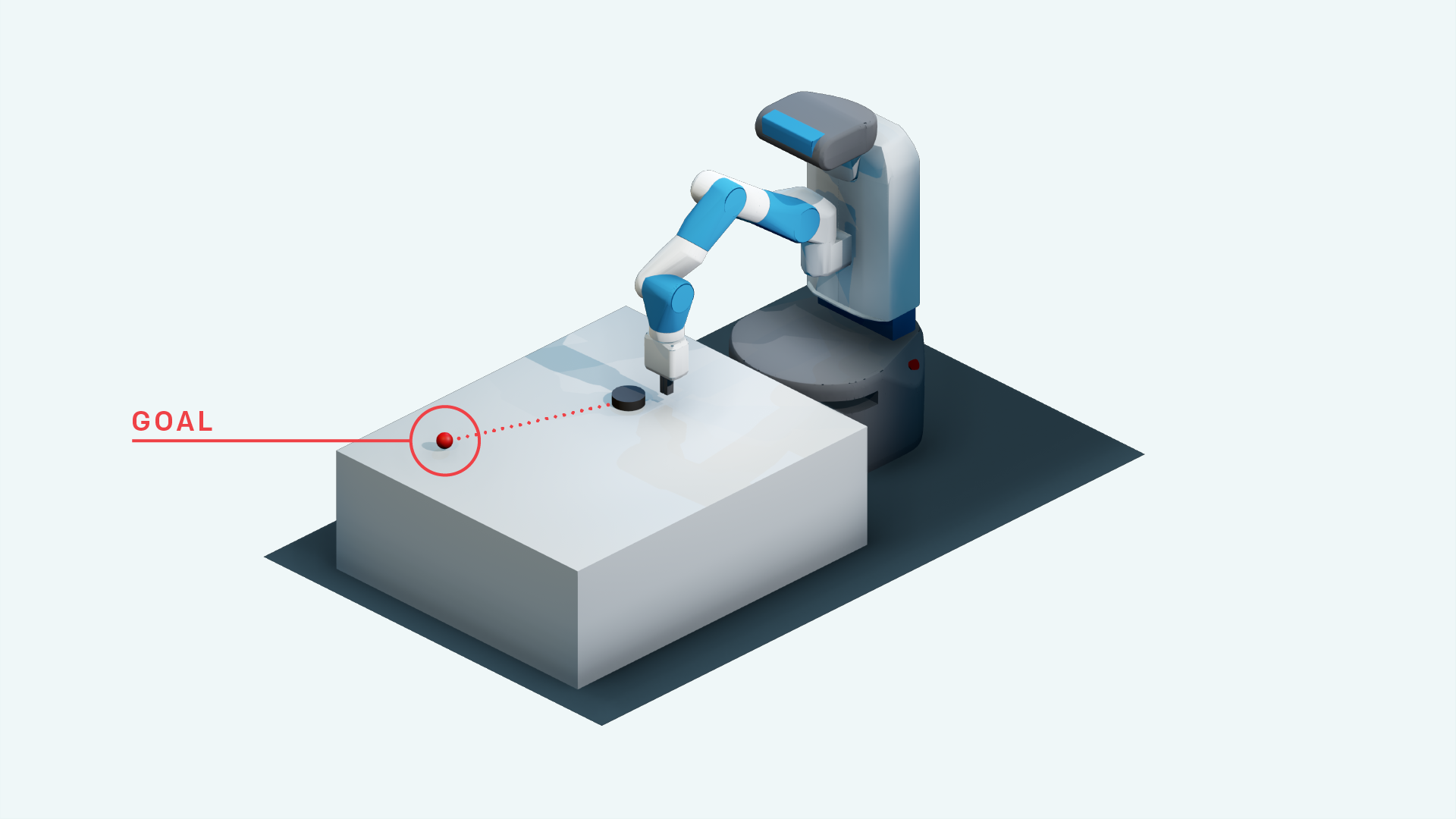

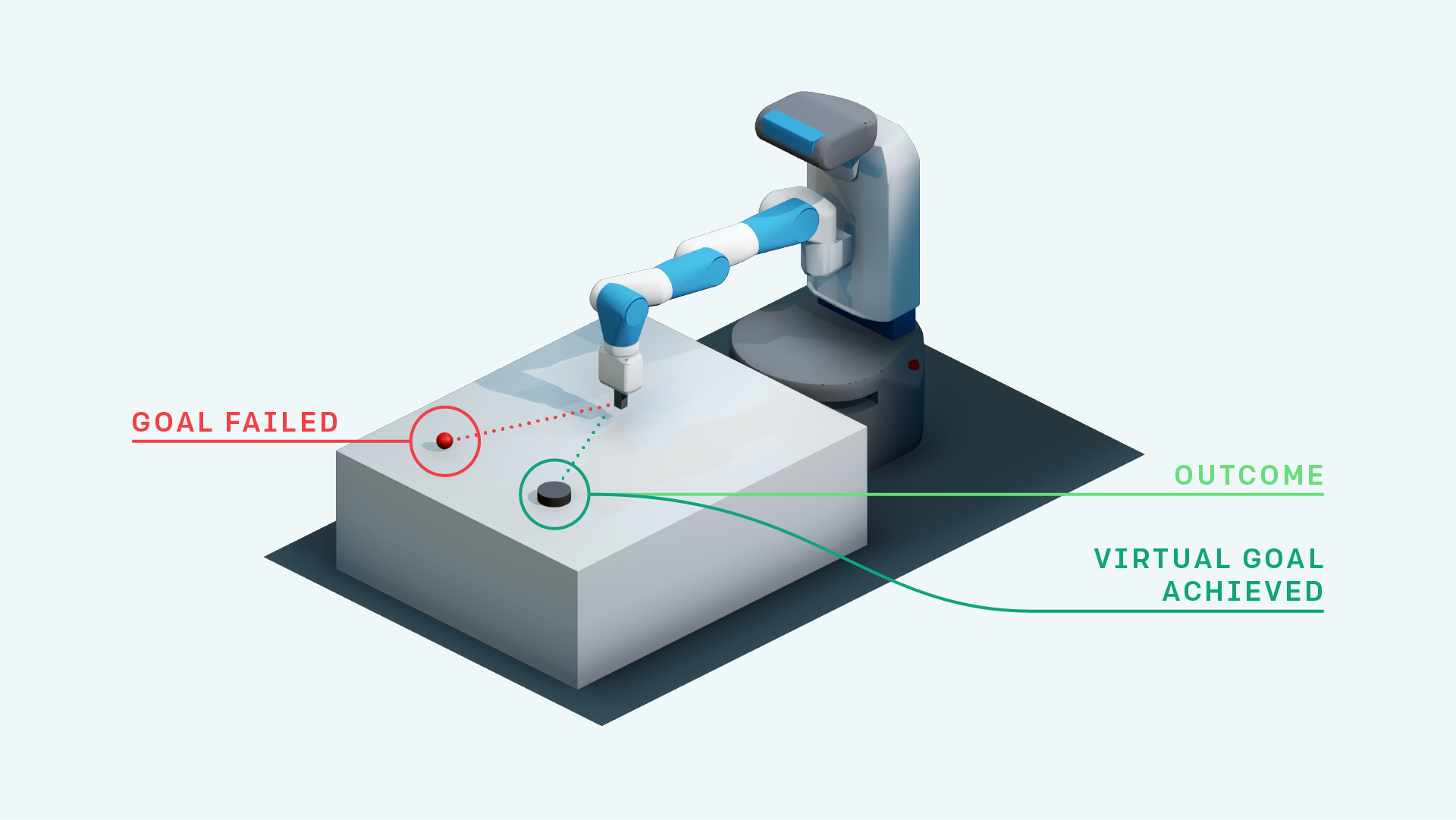

- DDPG กับเธอ (สำหรับสภาพแวดล้อมการดึงข้อมูล openai)

- การเรียนรู้การเสริมแรงจากทายาท

- ประสบการณ์การเล่นซ้ำ + DDPG

- DDPG พร้อมการเล่นซ้ำประสบการณ์ย้อนหลัง (การวิจัย)

- แผนที่ประสาทด้วย A3C (เร็ว ๆ นี้)

- Rainbow DQN (เร็ว ๆ นี้)

- PPO (https://github.com/ikostrikov/pytorch-a2c-ppo-acktr)

- เธอด้วยความสนใจในตัวเองเพื่อทดแทนเป้าหมาย (การวิจัย)

- A3C (เร็ว ๆ นี้)

- Acer (เร็ว ๆ นี้)

- ดาร์ลา

- TDM

- นางแบบโลก

- นักแสดงที่อ่อนนุ่ม

- Empowerment Driven Driven Exploration (การใช้งาน TensorFlow: https://github.com/navneet-nmk/empowerment-driven-exploration)

สภาพแวดล้อม

- การฝ่าวงล้อม

- พงษ์ (เร็ว ๆ นี้)

- งานหุ่นยนต์จัดการมือ

- งานหุ่นยนต์ที่เข้าถึงได้

- งานหุ่นยนต์ที่เข้าถึงได้ด้วยมือ

- บล็อกงานหุ่นยนต์จัดการ

- การแก้แค้นของ Montezuma (การวิจัยในปัจจุบัน)

- ความผิดพลาด

- แรงหน่วง

- การแร็ก

- Super Mario Bros (ทำตามคำแนะนำในการติดตั้ง Gym-Retro https://github.com/openai/retro)

- OpenSim Prosthetics NIPS Challenge (https://www.crowdai.org/challenges/nips-2018-ai-for-for-for-racthetics-challenge)

การสร้างแบบจำลองสภาพแวดล้อม (สำหรับการสำรวจและการปรับโดเมน)

มีการใช้เทคนิคการฝึกอบรม GAN หลายครั้งเนื่องจากความไม่แน่นอนในการฝึกอบรมเครื่องกำเนิดไฟฟ้าและผู้เลือกปฏิบัติ โปรดดูที่ https://github.com/soumith/ganhacks สำหรับข้อมูลเพิ่มเติม

แม้หลังจากใช้กลอุบายมันก็ยากที่จะฝึกฝน Gan เพื่อการบรรจบกัน อย่างไรก็ตามหลังจากใช้การทำให้เป็นมาตรฐานสเปกตรัม (https://arxiv.org/abs/1802.05957) Infogan ได้รับการฝึกฝนให้เข้าบรรจบกัน

สำหรับงานการแปลภาพกับภาพกับ GANS และสำหรับ VAES โดยทั่วไปการฝึกอบรมด้วยการเชื่อมต่อข้ามช่วยการฝึกอบรมจริงๆ

- เบต้า-วา

- คนอินฟ็กโก

- cvae-gan

- แบบจำลองการกำเนิดจากการไหล (การวิจัย)

- คนเจ้าชู้

- การเข้าร่วมตามลำดับอนุมานทำซ้ำ

- การสำรวจความอยากรู้อยากเห็น

- เสียงอวกาศพารามิเตอร์สำหรับการสำรวจ

- เครือข่ายที่มีเสียงดัง

การอ้างอิง

- เล่นอาตาริด้วยการเรียนรู้การเสริมแรงอย่างลึกซึ้ง MNIH และคณะ, 2013

- การควบคุมระดับมนุษย์ผ่านการเรียนรู้การเสริมแรงอย่างลึกล้ำ MNIH et al., 2015

- การเรียนรู้การเสริมแรงอย่างลึกล้ำด้วยการเรียนรู้แบบสองครั้ง, Van Hasselt et al., 2015

- การควบคุมอย่างต่อเนื่องด้วยการเรียนรู้การเสริมแรงอย่างลึกล้ำ Lillicrap et al., 2015

- CVAE-GAN: การสร้างภาพที่ละเอียดผ่านการฝึกอบรมแบบไม่สมมาตร, Bao et al., 2017

- Beta-vae: การเรียนรู้แนวคิดการมองเห็นขั้นพื้นฐานด้วยกรอบการแปรปรวนแบบ จำกัด , Higgins et al., 2017

- Experience Hindsight Replay, Andrychowicz et al., 2017

- Infogan: การเรียนรู้การเป็นตัวแทนที่ตีความได้โดยการเพิ่มข้อมูลสูงสุดของอวน antcersarial generative, Chen et al., 2016

- โมเดลโลก Ha et al., 2018

- การทำให้เป็นมาตรฐานทางสเปกตรัมสำหรับเครือข่ายฝ่ายตรงข้าม Generative, Miyato et al., 2018

- เครือข่ายฝ่ายตรงข้ามที่เกิดขึ้นเอง, Zhang et al., 2018

- การสำรวจที่ขับเคลื่อนด้วยความอยากรู้อยากเห็นโดยการทำนายตนเองที่ดูแลตนเอง Pathak et al., 2017

- Soft Actor-Critic: การเรียนรู้การเสริมแรงอย่างลึกซึ้งสูงสุดของเอนโทรปีกับนักแสดงสุ่ม, Haarnoja et al., 2018

- พารามิเตอร์เสียงอวกาศสำหรับการสำรวจ Plappert et al., 2018

- เครือข่ายที่มีเสียงดังสำหรับการสำรวจ Fortunato et al., 2018

- อัลกอริทึมการเพิ่มประสิทธิภาพนโยบายใกล้เคียง, Schulman et al., 2017

- การควบคุมแบบเรียลไทม์ที่ไม่ได้รับการดูแลผ่านการเสริมพลังแบบแปรปรวน Karl et al., 2017

- ข้อมูลร่วมกันการประมาณระบบประสาท Belghazi et al., 2018

- การสำรวจที่ขับเคลื่อนด้วยพลังโดยใช้การประมาณข้อมูลร่วมกัน Kumar et al., 2018