Pembelajaran Penguatan yang mendalam di Pytorch

Repositori ini berisi semua algoritma RL yang bebas model dan berbasis model (datang) di Pytorch. (Mungkin juga berisi beberapa ide penelitian yang sedang saya kerjakan saat ini)

Untuk C ++ versi Pytorch-RL: Pytorch-Rl-CPP

Apa itu?

Pytorch-Rl mengimplementasikan beberapa algoritma pembelajaran penguatan mendalam yang canggih di Pytorch, terutama yang berkaitan dengan ruang tindakan berkelanjutan. Anda dapat melatih algoritma Anda secara efisien baik di CPU atau GPU. Selain itu, Pytorch-RL bekerja dengan Openai Gym di luar kotak. Ini berarti bahwa mengevaluasi dan bermain -main dengan algoritma yang berbeda itu mudah. Tentu saja Anda dapat memperluas Pytorch-RL sesuai dengan kebutuhan Anda sendiri. TL: DR: Pytorch-RL membuatnya sangat mudah untuk menjalankan algoritma pembelajaran penguatan dalam yang canggih.

Instalasi

Instal Pytorch-RL dari PYPI (Direkomendasikan):

Pip Instal Pytorch-Policy

Dependensi

- Pytorch

- Gym (openai)

- mujoco-py (untuk simulasi fisika dan robotika env di gym)

- Pybullet (segera hadir)

- MPI (hanya didukung dengan instalasi MPI backend pytorch)

- Tensorboardx (https://github.com/lanpa/tensorboardx)

Algoritma RL

- DQN (dengan pembelajaran Q ganda)

- Ddpg

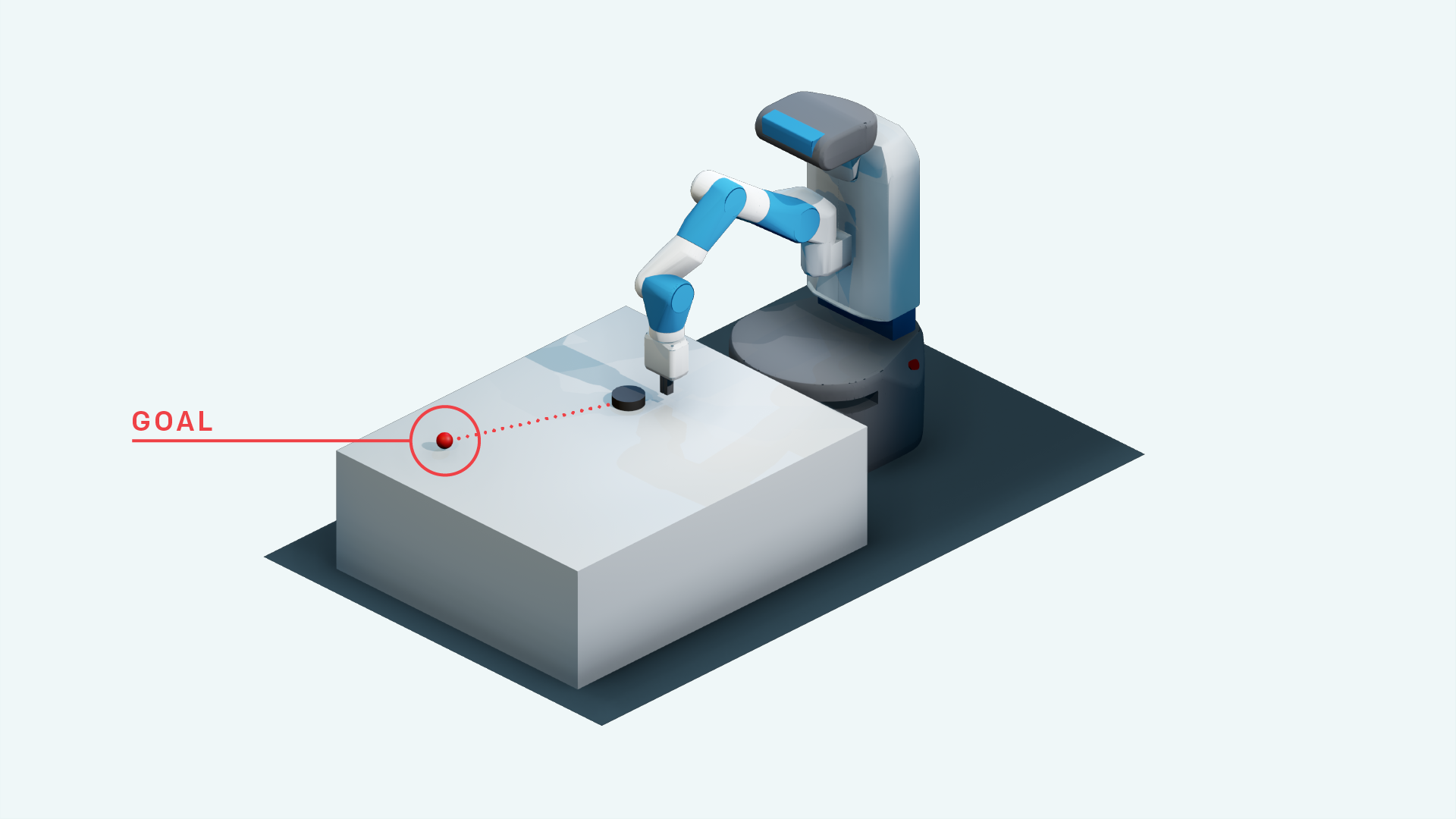

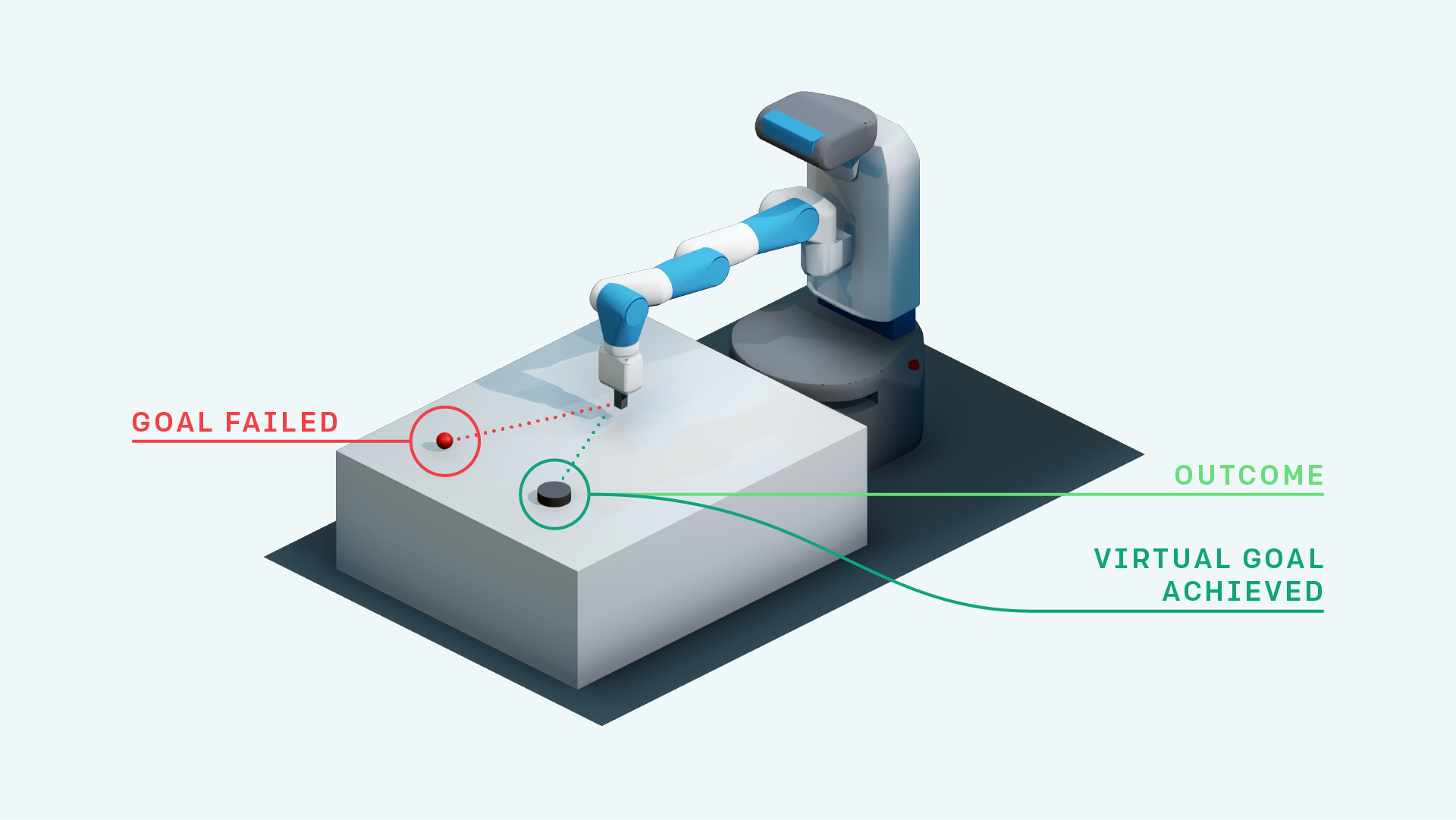

- DDPG dengan dia (untuk lingkungan pengambilan openai)

- Pembelajaran Penguatan Heirarkis

- Pengalaman Prioritas Replay + DDPG

- DDPG dengan replay Pengalaman Hindsight yang diprioritaskan (Penelitian)

- Peta saraf dengan A3C (segera hadir)

- Rainbow DQN (segera hadir)

- PPO (https://github.com/ikostrikov/pytorch-a2c-ppo-acktr)

- Dia dengan perhatian diri untuk substitusi tujuan (penelitian)

- A3C (segera hadir)

- Acer (segera hadir)

- Darla

- Tdm

- Model Dunia

- Aktor-kritik lunak

- Eksplorasi Digerakkan Pemberdayaan (Implementasi TensorFlow: https://github.com/navneet-nmk/empowment-driven-exploration)

Lingkungan

- Kesuksesan besar

- Pong (segera hadir)

- Tugas robot manipulasi tangan

- Mengambil tugas robot jangkauan

- Tugas robot yang dijangkau dengan tangan

- Blok manipulasi tugas robot

- Balas dendam Montezuma (penelitian saat ini)

- Jebakan

- Gravitar

- Carracing

- Super Mario Bros (Ikuti Instruksi untuk Menginstal Gym-Retro https://github.com/openai/retro)

- Opensim Prosthetics NIPS Challenge (https://www.crowdai.org/challenges/nips-2018-ai-for-prosthetics-challenge)

Pemodelan Lingkungan (untuk eksplorasi dan adaptasi domain)

Beberapa trik pelatihan GAN telah digunakan karena ketidakstabilan dalam melatih generator dan diskriminator. Silakan merujuk ke https://github.com/soumith/ganhacks untuk informasi lebih lanjut.

Bahkan setelah menggunakan trik, sangat sulit untuk melatih Gan ke konvergensi. Namun, setelah menggunakan normalisasi spektral (https://arxiv.org/abs/1802.05957) Infogan dilatih untuk konvergensi.

Untuk tugas -tugas terjemahan gambar ke gambar dengan GAN dan untuk VAE secara umum, pelatihan dengan Koneksi Skip benar -benar membantu pelatihan.

- beta-vae

- Infogan

- CVAE-GAN

- Model generatif berbasis aliran (penelitian)

- Sagan

- Hadir berurutan, menyimpulkan, ulangi

- Eksplorasi yang didorong oleh rasa ingin tahu

- Parameter Space Noise untuk Eksplorasi

- Jaringan bising

Referensi

- Bermain Atari dengan pembelajaran penguatan yang mendalam, Mnih et al., 2013

- Kontrol tingkat manusia melalui pembelajaran penguatan mendalam, Mnih et al., 2015

- Pembelajaran penguatan mendalam dengan learning Q ganda, van Hasselt et al., 2015

- Kontrol berkelanjutan dengan pembelajaran penguatan yang mendalam, Lillicrap et al., 2015

- CVAE-GAN: Generasi gambar berbutir halus melalui pelatihan asimetris, Bao et al., 2017

- Beta-Vae: Belajar Konsep Visual Dasar Dengan Kerangka Kerja Variasional Terkendala, Higgins et al., 2017

- Replay Pengalaman Hindsight, Andrychowicz et al., 2017

- Infogan: Pembelajaran Representasi yang Dapat Ditafsirkan dengan Informasi Memaksimalkan Nets Adversarial Generatif, Chen et al., 2016

- Model Dunia, Ha et al., 2018

- Normalisasi spektral untuk jaringan permusuhan generatif, Miyato et al., 2018

- Jaringan permusuhan generatif diri sendiri, Zhang et al., 2018

- Eksplorasi yang digerakkan oleh rasa ingin tahu dengan prediksi yang diatur sendiri, Pathak et al., 2017

- Aktor Soft-Critic: Off-Policy Maximum Entropy Inforforcement Belajar dengan aktor stokastik, Haarnoja et al., 2018

- Parameter Space Noise untuk Eksplorasi, Plappert et al., 2018

- Jaringan bising untuk eksplorasi, Fortunato et al., 2018

- Algoritma Optimasi Kebijakan Proksimal, Schulman et al., 2017

- Kontrol real-time tanpa pengawasan melalui pemberdayaan variasional, Karl et al., 2017

- Estimasi Saraf Saraf Reksa, Belghazi et al., 2018

- Eksplorasi yang digerakkan oleh pemberdayaan menggunakan estimasi informasi timbal balik, Kumar et al., 2018