Глубокое обучение подкреплению в Pytorch

Этот репозиторий содержит все стандартные алгоритмы RL на основе моделей и модели в Pytorch. (Может также содержать некоторые исследовательские идеи, над которыми я работаю в настоящее время)

Для C ++ версии Pytorch-RL: Pytorch-RL-CPP

Что это такое?

Pytorch-RL реализует некоторые современные алгоритмы обучения глубоким подкреплением в Pytorch, особенно тех, кто связан с непрерывными действиями. Вы можете эффективно обучить свой алгоритм либо на ЦП, либо в графическом процессоре. Кроме того, Pytorch-RL работает с Gym Openai Out из коробки. Это означает, что оценка и поиска с разными алгоритмами легко. Конечно, вы можете расширить Pytorch-RL в соответствии с вашими собственными потребностями. TL: DR: Pytorch-RL позволяет очень легко запустить современные алгоритмы обучения глубоким подкреплением.

Установка

Установите Pytorch-RL из PYPI (рекомендуется):

PIP установить Pytorch-Policy

Зависимости

- Пирог

- Тренажерный зал (OpenAI)

- Mujoco-Py (для симуляции физики и Env Robotics в тренажерном зале)

- Pybullet (скоро)

- MPI (поддерживается только с помощью MPI Backend Pytorch Install)

- Tensorboardx (https://github.com/lanpa/tensorboardx)

Алгоритмы RL

- DQN (с двойным Q Learning)

- DDPG

- DDPG с ней (для среды Openai Fetch)

- HEIRARCHICAL ARTERMARCIONS LEASION

- Приоритетный опыт воспроизведение + ddpg

- DDPG с приоритетным задним опытом воспроизведения (исследования)

- Нейронная карта с A3C (скоро)

- Rainbow DQN (скоро)

- PPO (https://github.com/ikostrikov/pytorch-a2c-ppo-acktr)

- Она с самообещающим вниманием к замене цели (исследование)

- A3C (скоро)

- Застенчивый (скоро)

- Дарла

- TDM

- Мировые модели

- Мягкий актер-критик

- Расследование по расширению прав и возможностей (реализация TensorFlow: https://github.com/navneet-nmk/empowerment-diven-exploration)

Среда

- Разразиться

- Понг (скоро)

- Роботизированная задача ручной манипуляции

- Задача робота из-за извлечения

- Роботизированная задача ручной работы

- Блок манипулирования роботизированной задачей

- Месть Монтесумы (текущее исследование)

- Ловушка

- Гравитар

- Перевозка

- Super Mario Bros (следуйте инструкциям по установке Gym-Retro https://github.com/openai/retro)

- OpenSim Prosthetics Nips Challenge (https://www.crowdai.org/challenges/nips-2018-ai-for-prosthetics-challenge)

Моделирование окружающей среды (для разведки и адаптации доменов)

Многочисленные тренировочные трюки GAN использовались из -за нестабильности в обучении генераторов и дискриминаторов. Пожалуйста, обратитесь к https://github.com/soumith/ganhacks для получения дополнительной информации.

Даже после использования трюков было действительно трудно тренировать Gan к конвергенции. Однако после использования спектральной нормализации (https://arxiv.org/abs/1802.05957) инфоган был обучен сходимости.

Для задач перевода изображения с изображением с Gans и для VAE в целом тренировка с Skip Connection действительно помогает обучению.

- бета-вар

- Infogan

- Cvae-gan

- Генеративные модели на основе потока (исследования)

- Саган

- Последовательное посещение, вывод, повторить

- Исследование, вызванное любопытством

- Параметр пространственного шума для исследования

- Шумная сеть

Ссылки

- Играя в Атари с глубоким подкреплением, Mnih et al., 2013

- Контроль на уровне человека через обучение глубокому подкреплению, Mnih et al., 2015

- Глубокое обучение подкреплению с двойным Q-обучением, Van Hasselt et al., 2015

- Непрерывный контроль с глубоким обучением подкрепления, Lillicrap et al., 2015

- CVAE-GAN: мелкозернистая генерация изображений через асимметричную тренировку, Bao et al., 2017

- Beta-Vae: изучение основных визуальных концепций с ограниченной вариационной структурой, Higgins et al., 2017

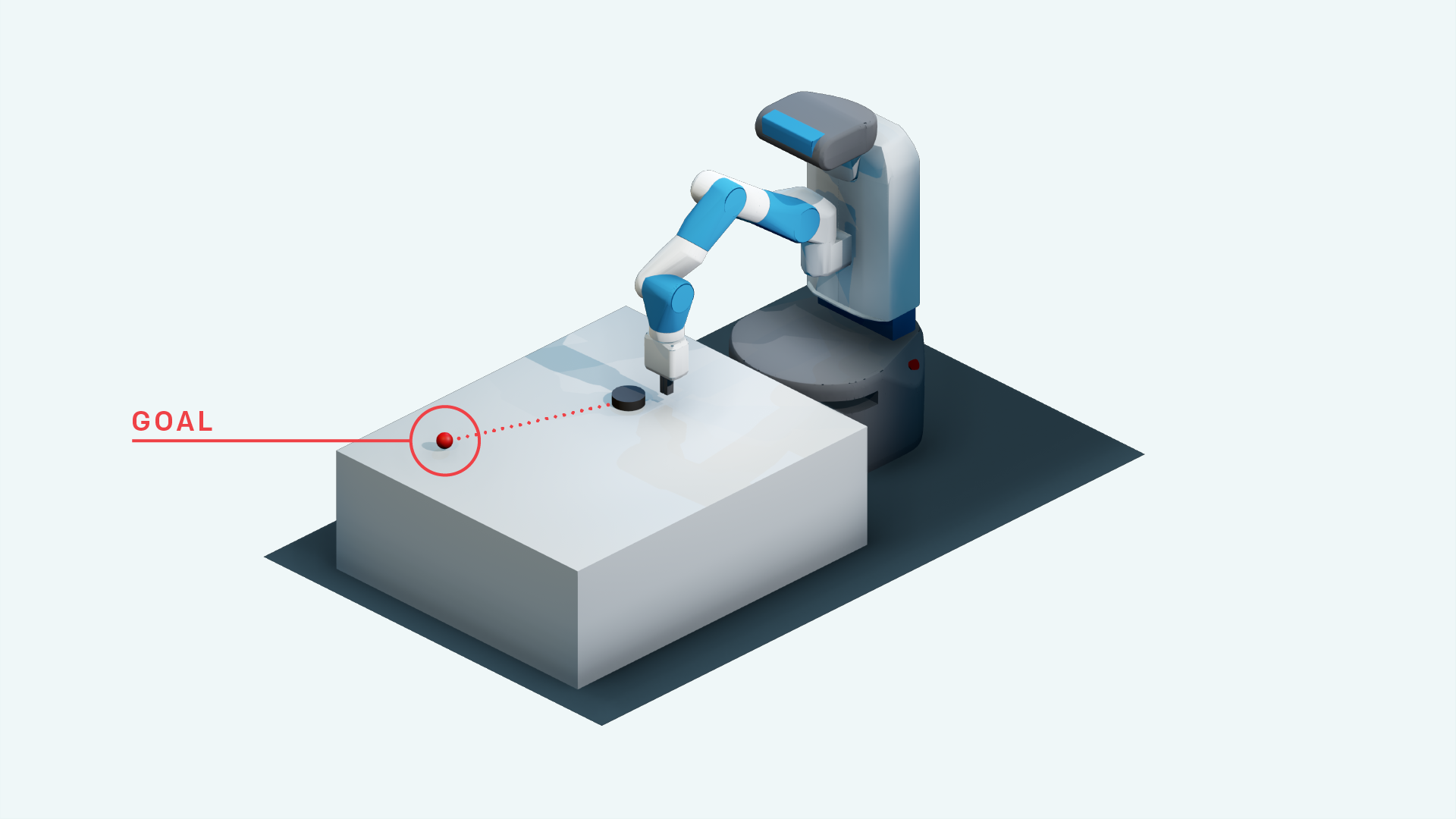

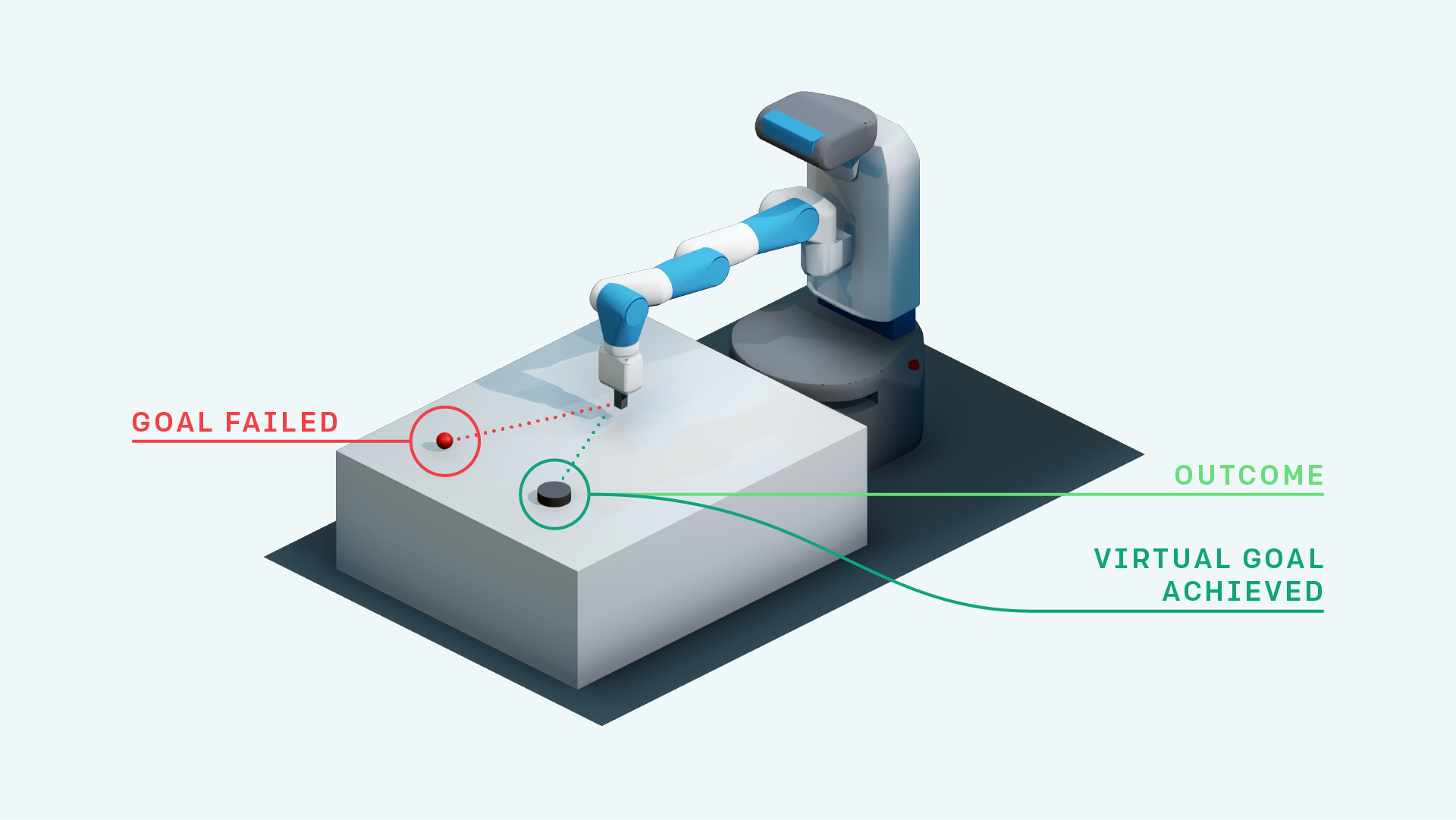

- Опыт повторяется, Andrychowicz et al., 2017

- Infogan: Интерпретируемое обучение представлений с помощью информации максимизирует генеративные состязательные сети, Chen et al., 2016

- World Models, Ha et al., 2018

- Спектральная нормализация для генеративных состязательных сетей, Miyato et al., 2018

- Самоализация генеративных состязательных сетей, Zhang et al., 2018

- Исследование, основанное на любопытства с помощью самоотверженного прогноза, Pathak et al., 2017

- Мягкий актер-критик: максимальная энтропия в вне политики.

- Параметр Пространственный шум для разведки, Plappert et al., 2018

- Noisy Network for Exploration, Fortunato et al., 2018

- Алгоритмы оптимизации проксимальной политики, Schulman et al., 2017

- Неконтролируемый контроль в режиме реального времени через вариационные возможности, Karl et al., 2017

- Нейронная оценка взаимной информации, Belghazi et al., 2018

- Расследование, управляемое возможностями, с использованием оценки взаимной информации, Kumar et al., 2018