Pytorch의 깊은 강화 학습

이 저장소에는 Pytorch의 모든 표준 모델 프리 및 모델 기반 (Coming) RL 알고리즘이 포함되어 있습니다. (내가 현재 작업중 인 몇 가지 연구 아이디어를 포함 할 수도 있음)

Pytorch-RL의 C ++ 버전 : Pytorch-RL-CPP

무엇입니까?

Pytorch-RL은 Pytorch의 최첨단 깊은 강화 학습 알고리즘, 특히 지속적인 행동 공간과 관련된 최첨단 심층 강화 학습 알고리즘을 구현합니다. CPU 또는 GPU에서 알고리즘을 효율적으로 교육 할 수 있습니다. 또한 Pytorch-RL은 OpenAi 체육관에서 상자에서 작동합니다. 이것은 다른 알고리즘으로 평가하고 재생하는 것이 쉽다는 것을 의미합니다. 물론 자신의 요구에 따라 Pytorch-RL을 확장 할 수 있습니다. TL : DR : PYTORCH-RL을 사용하면 최첨단 깊은 강화 학습 알고리즘을 쉽게 실행할 수 있습니다.

설치

pypi에서 pytorch-rl 설치 (권장) :

PIP Pytorch-Policy를 설치하십시오

의존성

- Pytorch

- 체육관 (Openai)

- Mujoco-Py (체육관의 물리 시뮬레이션 및 로봇 환경)

- Pybullet (곧 출시)

- MPI (MPI 백엔드 Pytorch 설치로만 지원)

- Tensorboardx (https://github.com/lanpa/tensorboardx)

RL 알고리즘

- DQN (Double Q 학습)

- DDPG

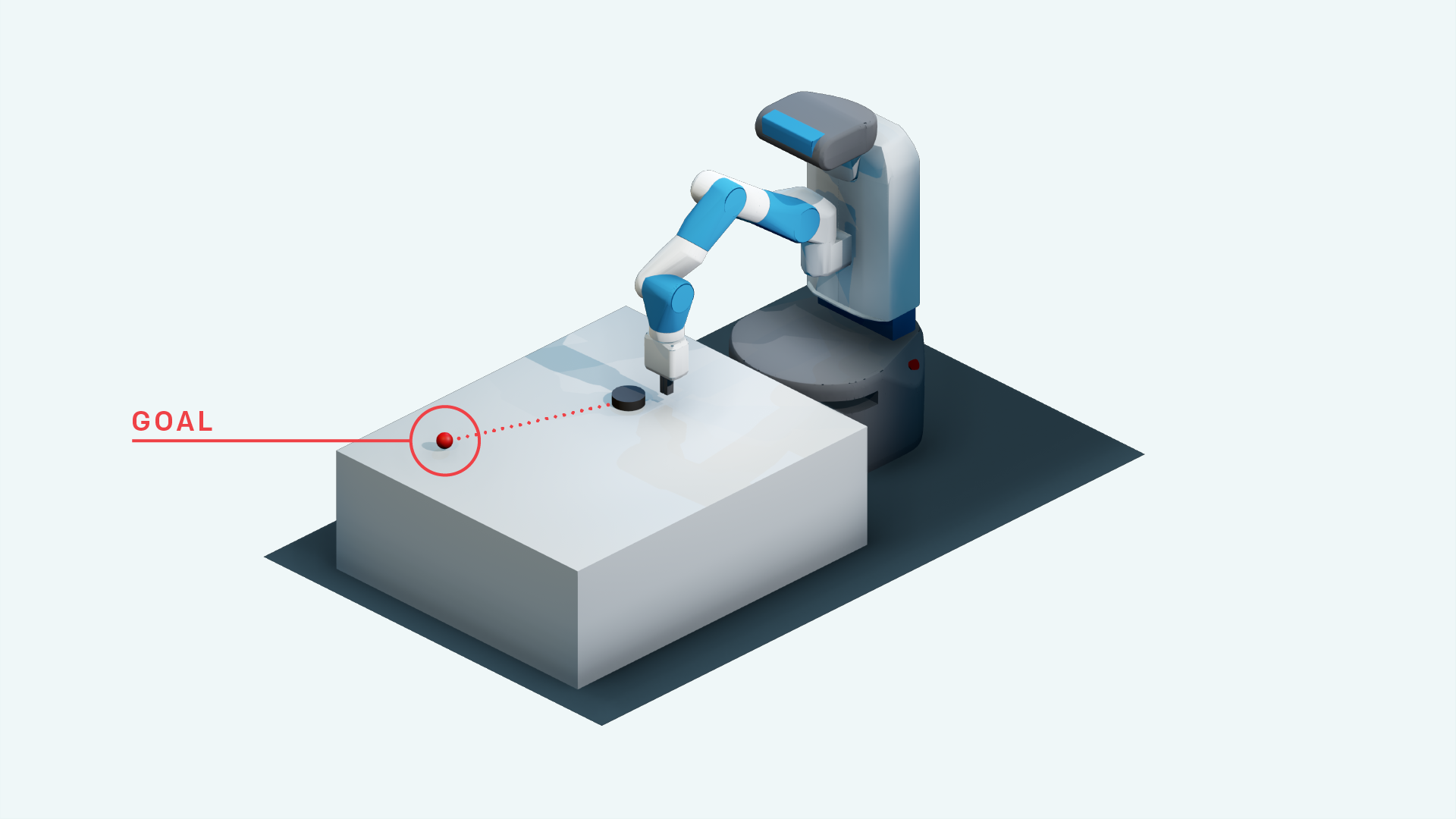

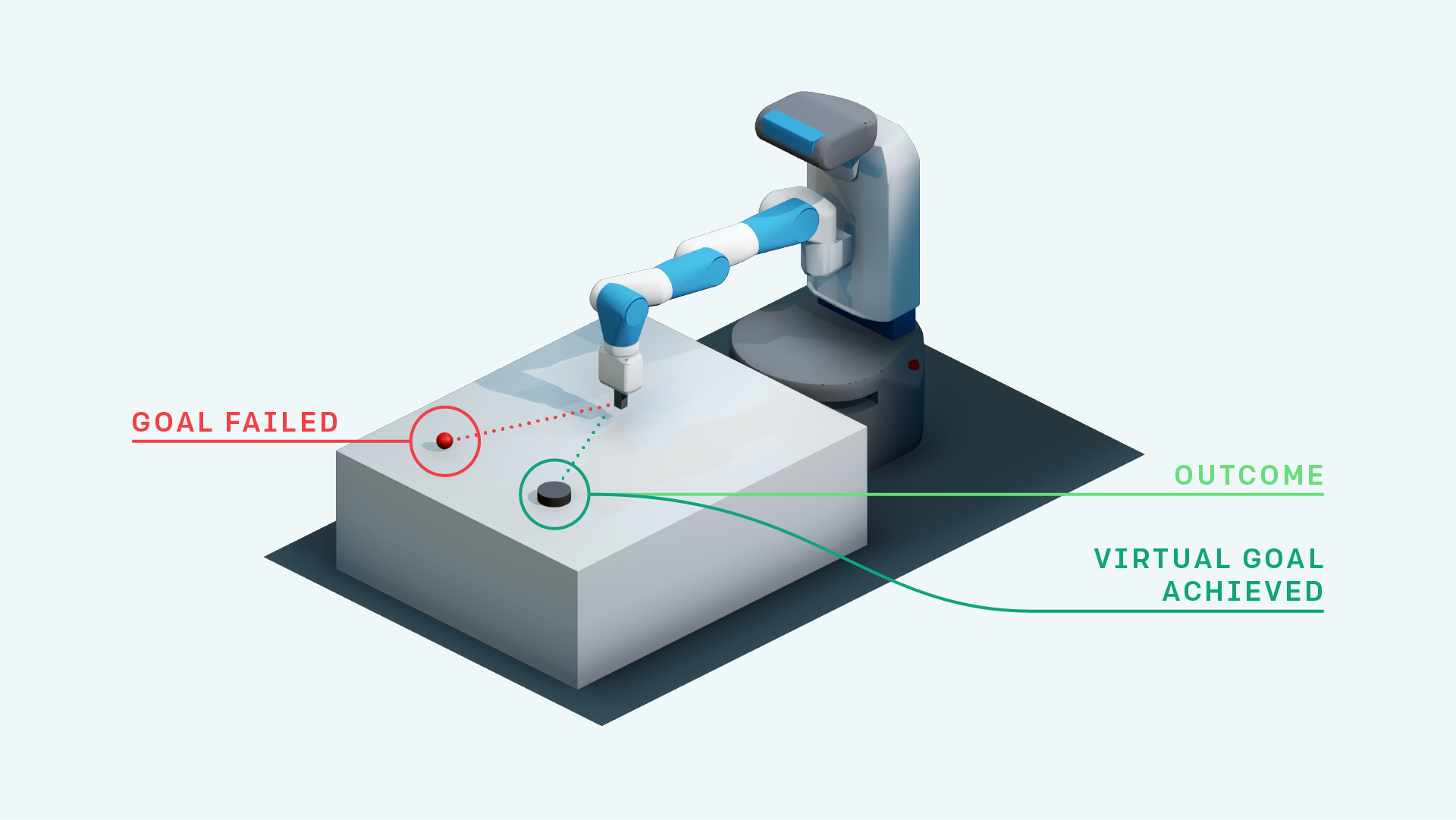

- 그녀와 DDPG (Openai Fetch 환경)

- 상속 적 강화 학습

- 우선 순위가 좋은 경험 재생 + DDPG

- 우선 순위가 1 인 DDPG 재생 (Research)

- A3C가있는 신경지도 (곧 출시)

- Rainbow DQN (곧 출시)

- PPO (https://github.com/ikostrikov/pytorch-a2c-ppo-acktr)

- 목표 대체에 대한 자기 관심을 가진 그녀 (연구)

- A3C (곧 출시)

- Acer (곧 출시)

- 달라

- TDM

- 세계 모델

- 부드러운 액터-비법

- 권한 부여 중심 탐사 (Tensorflow 구현 : https://github.com/navneet-nmk/empowerment-driven-exploration)

환경

- 브레이크 아웃

- Pong (곧 출시)

- 손 조작 로봇 작업

- 로봇 과제를 가져옵니다

- 손을 뻗는 로봇 과제

- 블록 조작 로봇 작업

- 몬테 주마의 복수 (현재 연구)

- 함정

- 그라비타

- 당근

- Super Mario Bros (Gym-Retro https://github.com/openai/retro를 설치하려면 지침을 따르십시오)

- Opensim Prosthetics Nips Challenge (https://www.crowdai.org/challenges/nips-2018-ai-for-prosthetics-challenge)

환경 모델링 (탐색 및 도메인 적응 용)

발전기와 차별자 훈련의 불안정성 때문에 여러 GAN 훈련 트릭이 사용되었습니다. 자세한 내용은 https://github.com/soumith/ganhacks를 참조하십시오.

트릭을 사용한 후에도 GAN을 수렴으로 훈련시키는 것은 정말 어려웠습니다. 그러나 스펙트럼 정규화 (https://arxiv.org/abs/1802.05957)를 사용한 후, 인포 제는 수렴으로 훈련되었습니다.

GANS와 일반적으로 VAES를 사용하여 이미지에서 이미지로 번역 작업을 수행하려면 Skip Connection을 사용한 교육이 실제로 교육에 도움이됩니다.

- 베타 VAE

- Infogan

- cvae-gan

- 흐름 기반 생성 모델 (연구)

- 사간

- 순차적으로 참석하고 추론하고 반복하십시오

- 호기심 추진 탐사

- 탐색을위한 매개 변수 공간 노이즈

- 시끄러운 네트워크

참조

- 깊은 강화 학습과 함께 Atari, Mnih et al., 2013

- 깊은 강화 학습을 통한 인간 수준의 통제, Mnih et al., 2015

- 이중 Q- 러닝을 가진 깊은 강화 학습, Van Hasselt et al., 2015

- 깊은 강화 학습을 통한 지속적인 제어, Lillicrap et al., 2015

- CVAE-Gan : 비대칭 훈련을 통한 세밀한 이미지 생성, Bao et al., 2017

- 베타 VAE : 제한된 변형 프레임 워크를 사용하여 기본적인 시각적 개념 학습, Higgins et al., 2017

- 후시 경험 재생, Andrychowicz et al., 2017

- Infogan : 생성 적대성 그물을 극대화하는 정보에 의한 해석 가능한 표현 학습, Chen et al., 2016

- World Models, Ha et al., 2018

- 생성 적대 네트워크에 대한 스펙트럼 정규화, Miyato et al., 2018

- 자체 변환 생성 적대적 네트워크, Zhang et al., 2018

- 자체 감독 예측에 의한 호기심 중심의 탐사, Pathak et al., 2017

- 소프트 액터 크리티어 : 확률 론적 행위자와 함께하는 정책 최대 엔트로피 깊은 강화 학습, Haarnoja et al., 2018

- 탐색을위한 매개 변수 공간 노이즈, Plappert et al., 2018

- 탐사를위한 시끄러운 네트워크, Fortunato et al., 2018

- 근위 정책 최적화 알고리즘, Schulman et al., 2017

- 변형 권한 부여를 통한 감독되지 않은 실시간 제어, Karl et al., 2017

- 상호 정보 신경 추정, Belghazi et al., 2018

- 상호 정보 추정을 이용한 권한 부여 중심 탐사, Kumar et al., 2018