英语| 简体中文| 日本语

通过AI的力量和您的个人知识库来构建自动化工作流程。

只需拖放即可创建强大的工作流,而无需任何编程。

Vectorvein是一种不受Langchain和Langflow启发的无代码AI工作流软件,旨在结合大型语言模型的强大功能,使用户能够轻松实现各种日常任务的智能和自动化工作流程。

您可以在此处体验Vectorvein的在线版本,而无需下载或安装。

官方网站在线文档

从发行版下载vectorvein后,该程序将在安装目录中创建一个“数据”文件夹,以存储数据库和静态文件资源。

Vectorvein是使用Pywebview构建的,基于WebView2内核,因此您需要安装WebView2运行时。如果无法打开该软件,则可能需要从https://developer.microsoft.com/en-us/microsoft-ge/webview2/手动下载WebView2运行时

重要的

如果解压缩后无法打开该软件,请检查下载的压缩软件包.zip文件是否已锁定。您可以通过右键单击压缩软件包并选择“ Unblock”来解决此问题。

该软件中的大多数工作流程和代理都涉及使用AI大语言模型,因此您至少应该为大型语言模型提供可用的配置。对于工作流程,您可以看到界面中使用了哪些大语言模型,如下图所示。

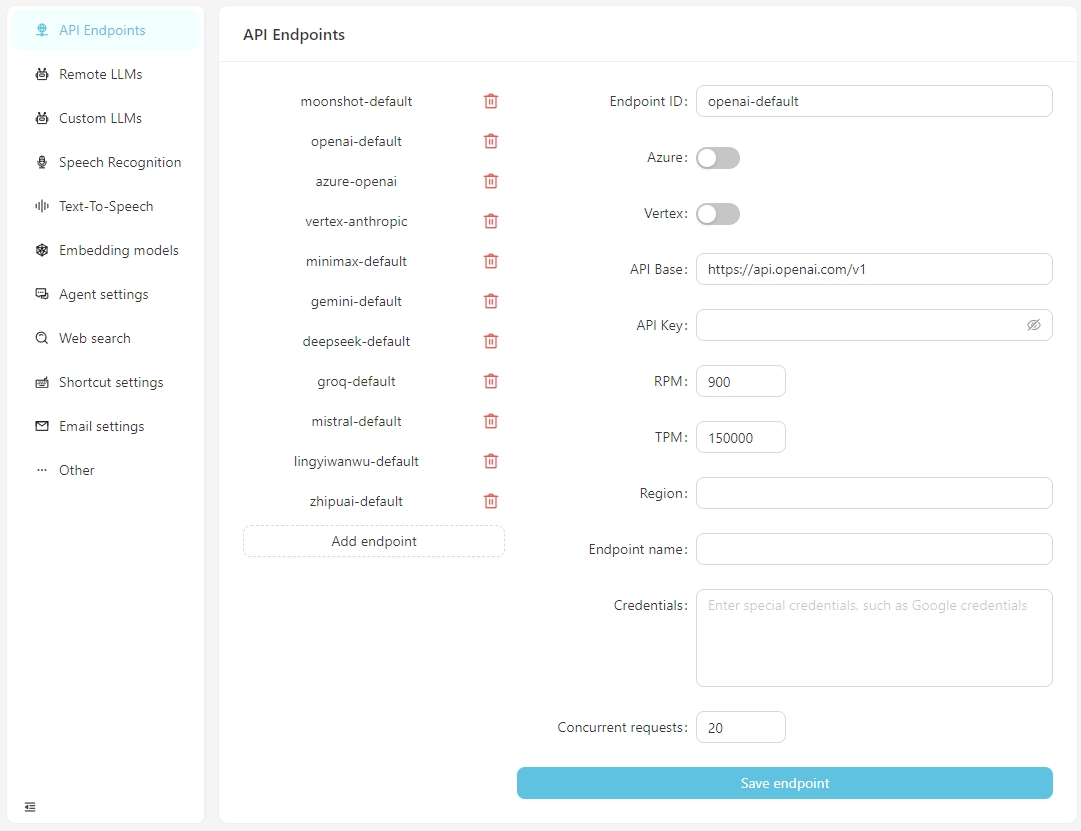

从v0.2.10开始,vectorpulse将API端点和大型语言模型配置分开,允许使用相同大型语言模型的多个API端点。

软件正常打开后,单击“打开设置”按钮,您可以根据需要为每个API端点配置信息,或添加自定义API端点。当前,API端点支持与OpenAI兼容的接口,可以连接到本地运行的服务,例如LM-STUDIO,OLLAMA,VLLM,ETC。

LM-Studio的API基础通常为http:// localhost:1234/v1/

Ollama的API基础通常为http:// localhost:11434/v1/

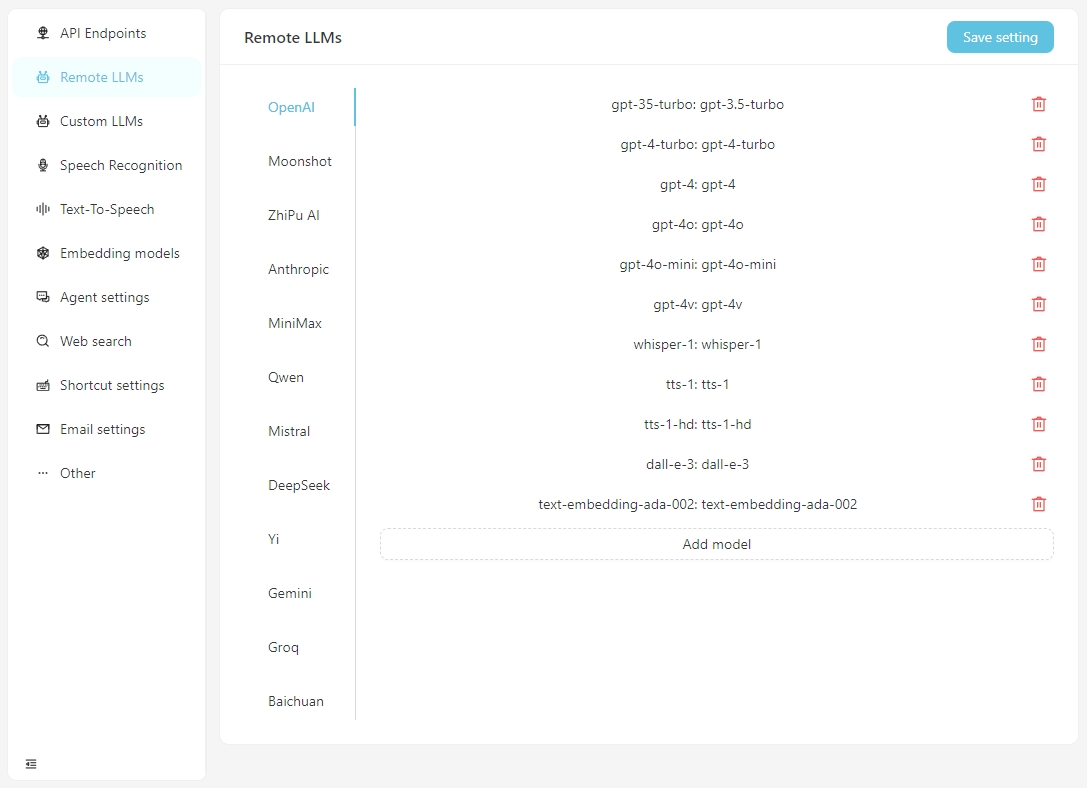

请在Remote LLMs选项卡中为每个模型配置特定信息。

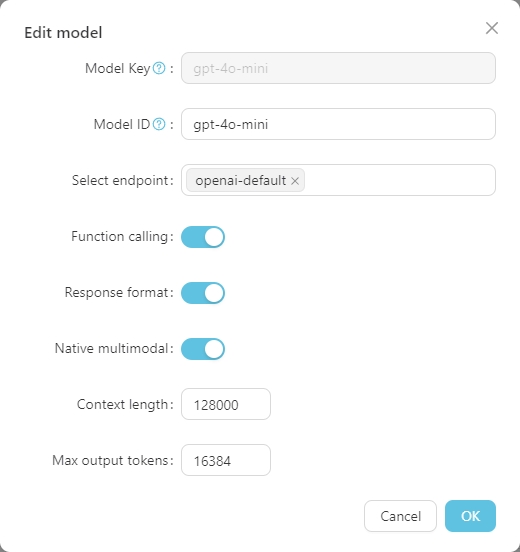

单击任何模型以设置其特定配置,如下所示。

Model Key是大型模型的标准名称,通常不需要调整。 Model ID是实际部署过程中使用的名称,通常与Model Key匹配。但是,在Azure OpenAI等部署中, Model ID是用户定义的,因此需要根据实际情况进行调整。

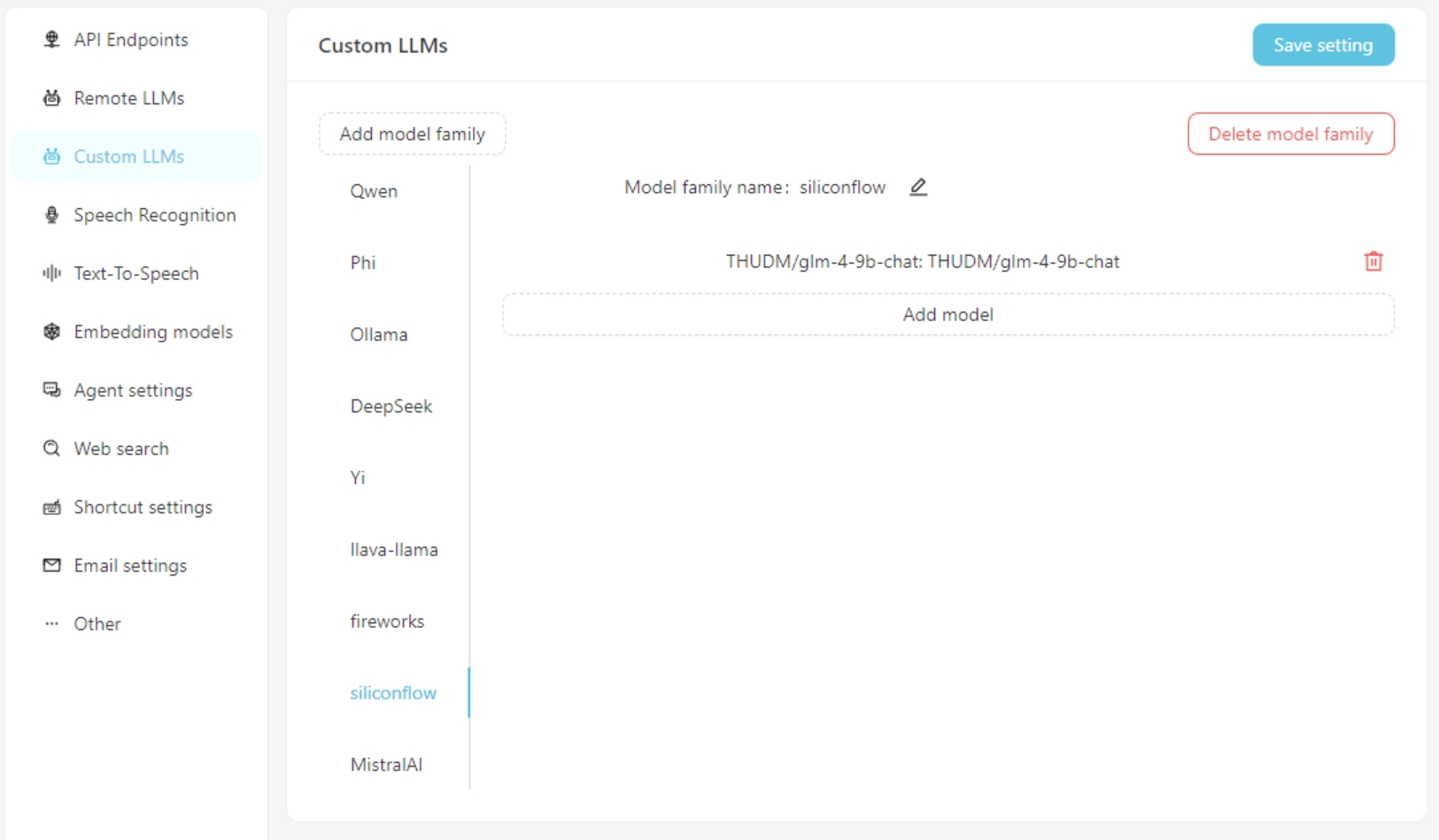

如果使用自定义大型语言模型,请填写“自Custom LLMs选项卡上的自定义模型配置信息。目前,支持与OpenAI兼容的接口,例如LM-Studio,Ollama,Vllm,Ett。

首先,添加自定义模型家族,然后添加自定义模型。不要忘记单击Save Settings按钮。

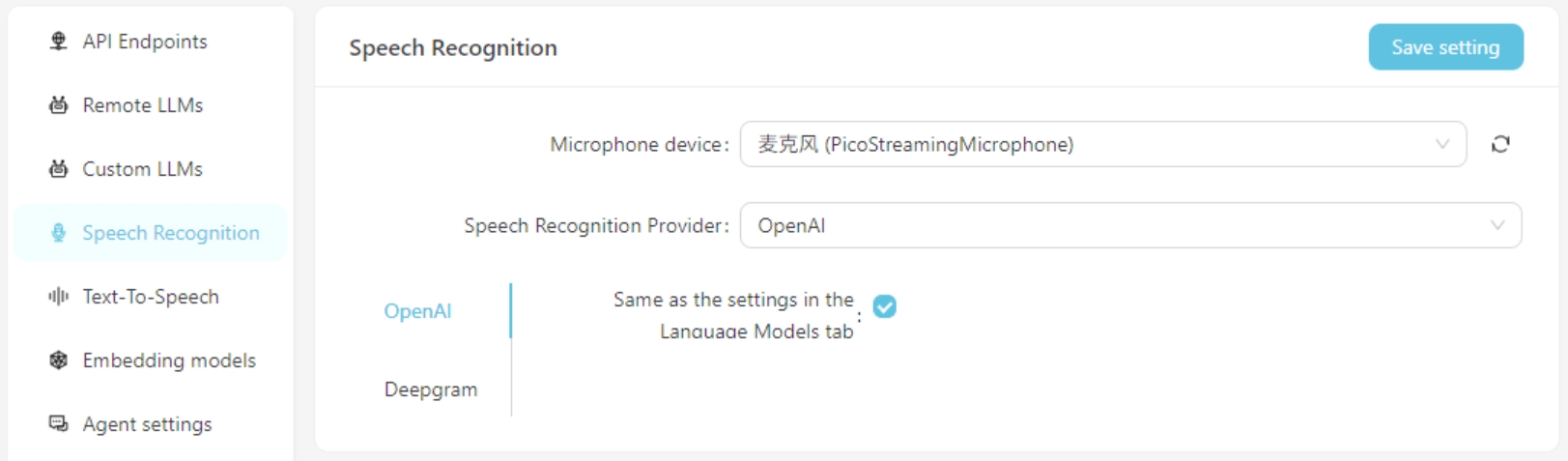

目前,支持OpenAI/Deepgram的语音识别服务。对于OpenAI Services,您可以使用与大语言模型相同的配置,也可以设置与OpenAI API兼容的语音识别服务(例如GROQ)。

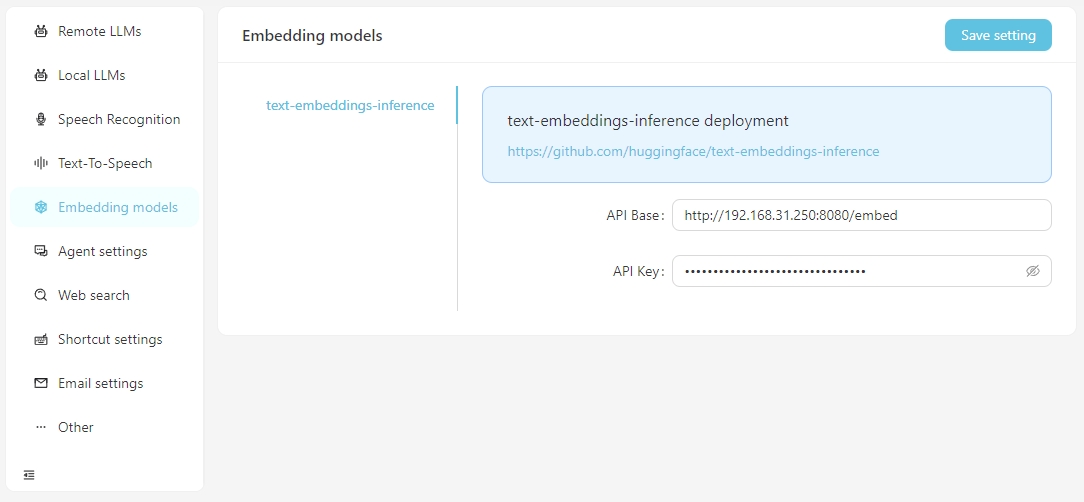

当您需要使用向量数据执行向量搜索时,您可以选择使用OpenAI提供的嵌入式服务或在Embedding Model设置中配置本地嵌入式服务。当前,支持的本地嵌入式服务要求您自己设置文本插件推论。

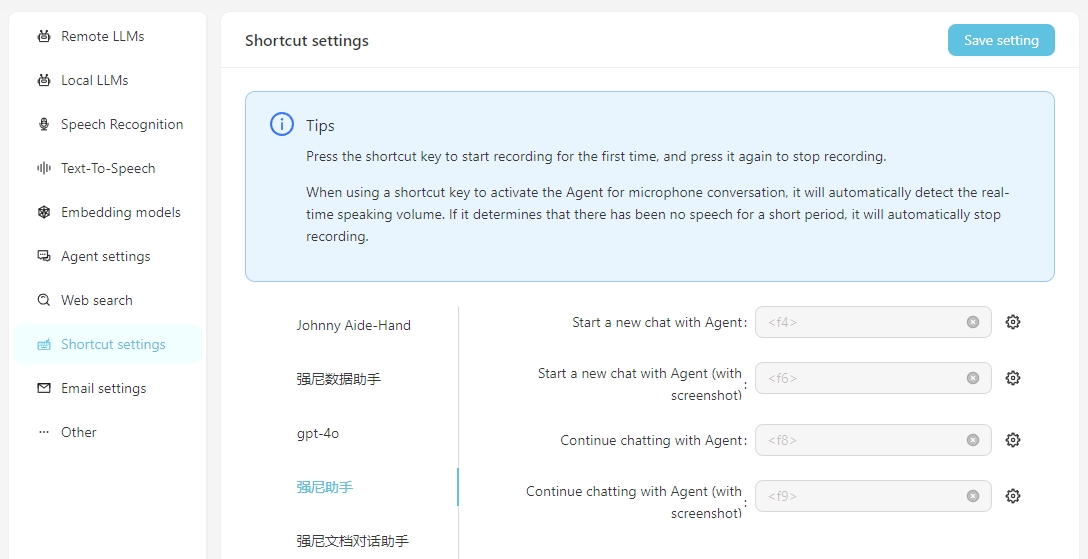

为了易于日常使用,您可以配置快捷方式以快速启动与代理商的语音对话。通过快捷方式启动,您可以通过语音识别直接与代理商进行交互。重要的是要确保事先正确配置语音识别服务。

包含屏幕截图意味着在开始对话时,将作为对话的附件拍摄并上传屏幕的屏幕截图。

要使用自己的本地稳定扩散API,您需要将参数-api添加到webui-user.bat的启动项目中,即

set COMMANDLINE_ARGS=--api

工作流代表工作任务过程,包括输入,输出以及如何处理输入以达到输出结果。

示例:

翻译工作流程:输入是一个英文文字文档,输出也是Word文档。您可以设计工作流程以翻译输入中文文档并生成中文文档输出。

思维映射工作流程:如果翻译工作流的输出更改为思维映射,则可以获得一个读取英语Word文档并将其汇总到中文思维映射中的工作流程。

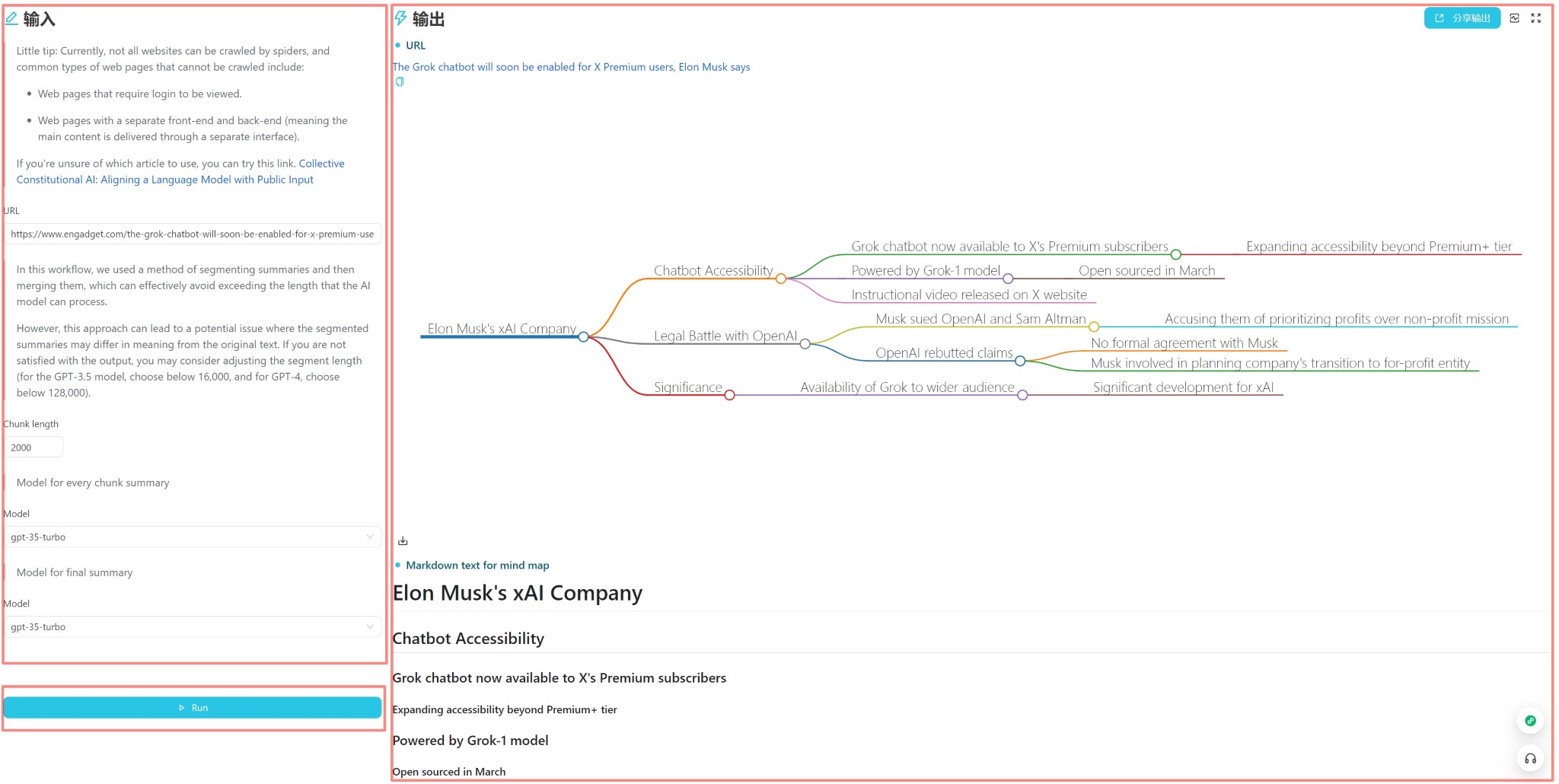

Web文章摘要工作流程:如果思维映射工作流的输入更改为Web文章的URL,则可以获得读取Web文章并将其汇总到中国思维映射中的工作流程。

自动分类客户投诉工作流程:输入是包含投诉内容的表,您可以自定义需要分类的关键字,以便可以自动对投诉进行分类。输出是一个自动生成的Excel表,其中包含分类结果。

每个工作流都有一个用户界面和一个编辑器界面。用户界面用于日常工作流操作,编辑器界面用于工作流编辑。通常,在设计工作流程后,您只需要在用户界面中运行它,而无需在编辑器界面中修改它即可。

用户界面如上所述,分为三个部分:输入,输出和触发器(通常是运行按钮)。您可以直接输入每日使用内容,单击“运行”按钮以查看输出结果。

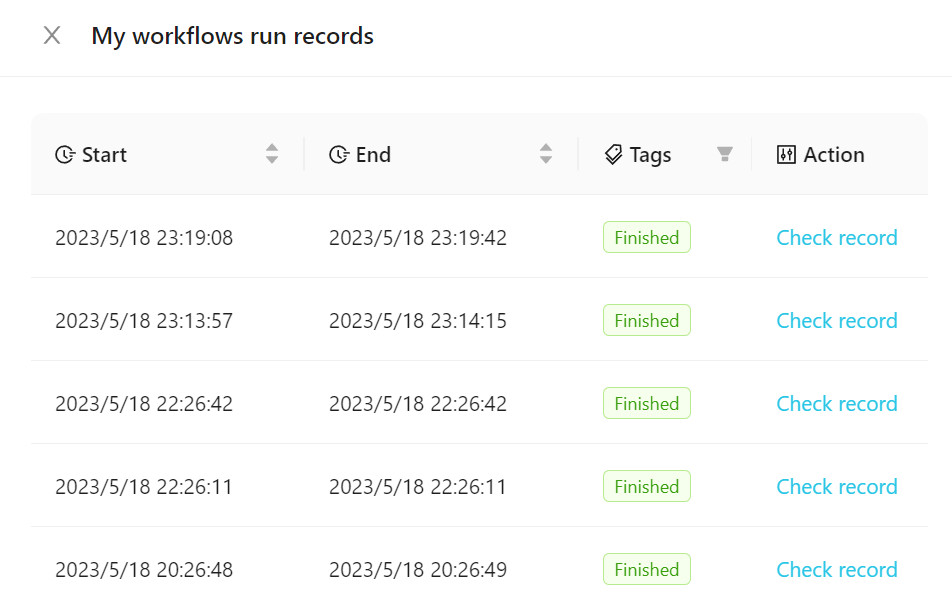

要查看执行的工作流程,请单击“工作流”运行记录,如下图所示。

您可以将我们的官方模板添加到您的工作流程中,也可以创建一个新模板。建议您熟悉使用官方模板在开始时使用工作流程的熟悉。

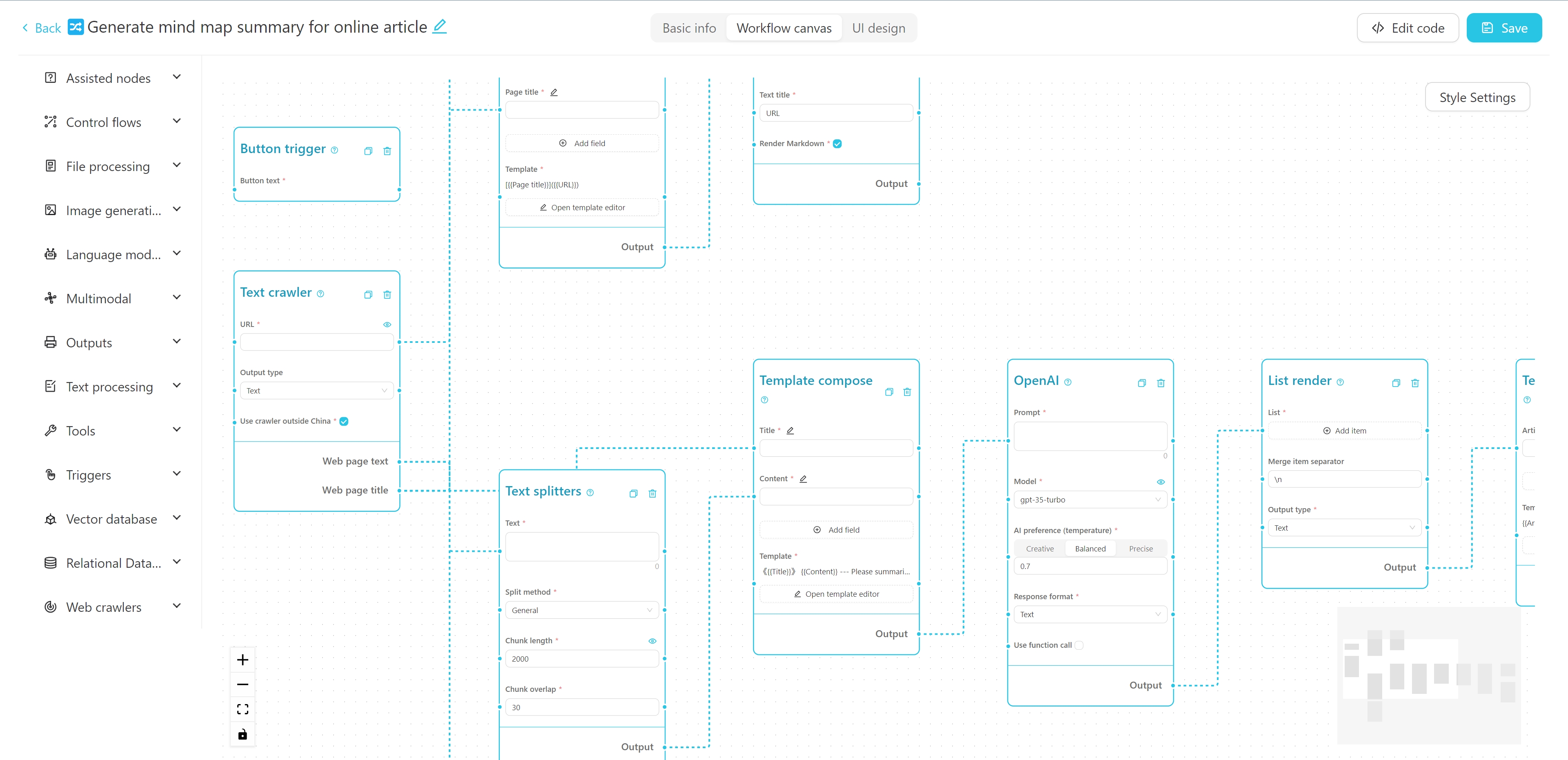

工作流编辑器接口如上所述。您可以在顶部编辑名称,标签和详细说明。左侧是工作流的节点列表,右侧是工作流的画布。您可以将所需的节点从左侧拖到画布,然后通过电线连接节点以形成工作流程。

您可以在此处查看有关创建一个简单的爬网 + AI摘要Mind Map Workflow的教程。

您也可以尝试此在线互动教程。

后端

Python 3.8〜Python 3.11

安装了PDM

前端

VUE3

Vite

在后端目录中运行以下命令以安装依赖项:

PDM安装

PDM安装-G Mac

通常,PDM会自动找到系统的Python并创建虚拟环境并安装依赖关系。

安装后,运行以下命令以启动后端开发服务器并查看运行效果:

PDM Run Dev

如果您需要修改前端代码,则需要在前端目录中运行以下命令以安装依赖项:

PNPM安装

首次拉动项目代码时,您还需要运行

pnpm install以安装前端依赖项。如果您根本不需要开发任何前端代码,则可以将

web文件夹从发行版本直接复制到backend文件夹中。

安装前端依赖关系后,您需要将前端代码编译到后端的静态文件目录中。项目中提供了快捷方式指令。在后端目录中运行以下命令以打包并复制前端资源:

PDM运行构建前

警告

在更改数据库结构之前,请备份您的数据库(位于您配置的data目录中的my_database.db ),否则您可能会丢失数据。

如果您已经修改了backend/models中的模型结构,则需要在backend目录中运行以下命令以更新数据库结构:

首先,输入Python环境:

PDM运行Python

从型号导入create_migrationscreate_migrations(“ migration_name”)#根据所做的更改

操作后,使用文件名格式xxx_migration_name.py在backend/migrations目录中将生成一个新的迁移文件。建议首先检查迁移文件的内容,以确保其正确,然后重新启动主程序。主程序将自动执行迁移。

该项目使用Pyinstaller进行包装。在后端目录中运行以下命令,以将其包装到可执行文件中:

PDM运行构建

包装后,将在后端/DIST目录中生成可执行文件。

Vectorvein是一种支持个人非商业用途的开源软件。请参阅许可以获取特定协议。