Englisch | 简体中文 | 日本語

Erstellen Sie Ihren Automatisierungs -Workflow mit der Kraft der KI und Ihrer persönlichen Wissensbasis.

Erstellen Sie leistungsstarke Workflows mit nur Drag & Drop ohne Programmierung.

Vectorvein ist eine No-Code-AI-Workflow-Software, die von Langchain und Langflow inspiriert ist und die leistungsstarken Funktionen großer Sprachmodelle kombinieren und es Benutzern ermöglichen können, intelligente und automatisierte Workflows für verschiedene tägliche Aufgaben einfach zu erreichen.

Hier können Sie die Online -Version von Vectorvein erleben, ohne dass sie herunterladen oder installieren müssen.

Offizielle Website Online -Dokumentation

Nach dem Herunterladen von Vectorvein aus der Version erstellt das Programm im Installationsverzeichnis einen "Daten" -Fordner, um die Datenbank- und statische Dateiressourcen zu speichern.

Vectorvein wird mit PYWebView basierend auf dem WebView2 -Kernel erstellt. Sie müssen daher die WebView2 -Laufzeit installieren. Wenn die Software nicht geöffnet werden kann, müssen Sie möglicherweise die WebView2-Laufzeit manuell von https://developer.microsoft.com/en-us/microsoft-eded/webview2/ herunterladen

Wichtig

Wenn die Software nach der Dekompression nicht geöffnet werden kann, überprüfen Sie bitte, ob die heruntergeladene komprimierte Paket .zip -Datei gesperrt ist. Sie können dieses Problem lösen, indem Sie mit der rechten Maustaste auf das komprimierte Paket klicken und "entsperren" auswählen.

Die meisten Workflows und Agenten in der Software beinhalten die Verwendung von KI -Großsprachenmodellen. Sie sollten daher zumindest eine nutzbare Konfiguration für ein großes Sprachmodell bereitstellen. Bei Workflows können Sie sehen, welche großsprachigen Modelle in der Schnittstelle verwendet werden, wie im Bild unten gezeigt.

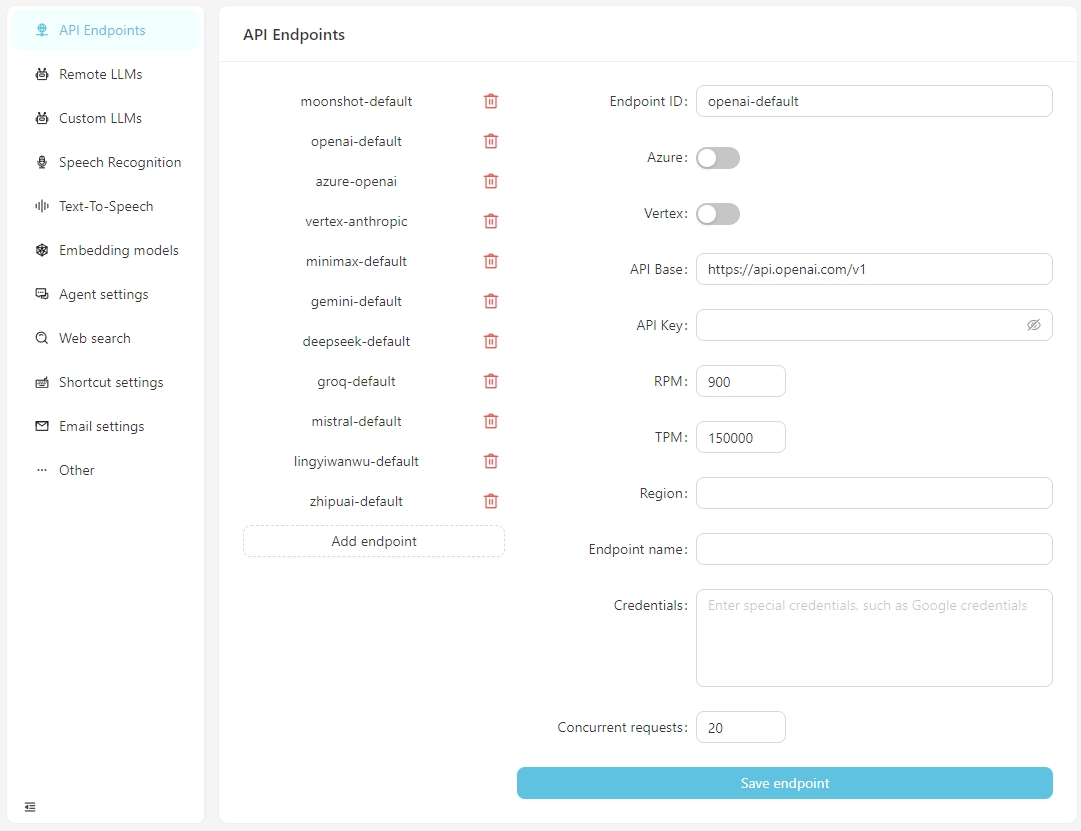

Ab V0.2.10 trennt VectorPulse die API -Endpunkte und großsprachige Modellkonfigurationen, sodass mehrere API -Endpunkte für dasselbe großes Sprachmodell ermöglicht werden können.

Nachdem sich die Software normal geöffnet hat, klicken Sie auf die Schaltfläche Einstellungen öffnen und Sie können die Informationen für jeden API -Endpunkt nach Bedarf konfigurieren oder benutzerdefinierte API -Endpunkte hinzufügen. Derzeit unterstützen die API-Endpunkte OpenAI-kompatible Schnittstellen, die mit lokal laufenden Diensten wie LM-Studio, Ollama, VLLM usw. verbunden werden können.

Die API-Basis für LM-Studio ist typischerweise http: // localhost: 1234/v1/

Die API -Basis für Ollama ist typischerweise http: // localhost: 11434/v1/

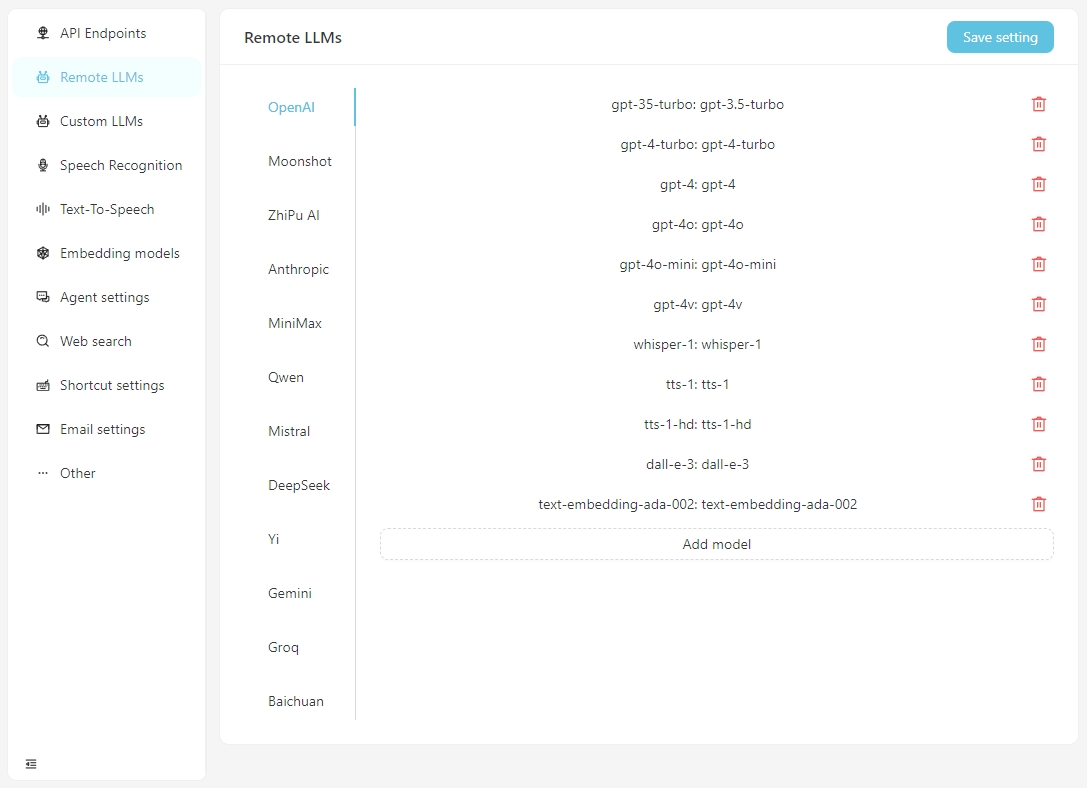

Bitte konfigurieren Sie die spezifischen Informationen für jedes Modell auf der Registerkarte Remote LLMs .

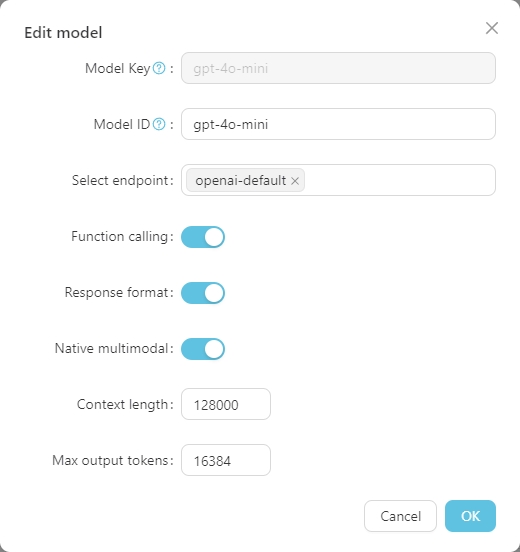

Klicken Sie auf ein beliebiges Modell, um die spezifische Konfiguration festzulegen, wie unten gezeigt.

Der Model Key ist der Standardname des großen Modells und muss im Allgemeinen nicht angepasst werden. Die Model ID ist der Name, der während der tatsächlichen Bereitstellung verwendet wird und normalerweise mit der Model Key übereinstimmt. In Bereitstellungen wie Azure OpenAI ist die Model ID jedoch benutzerdefiniert und muss daher entsprechend der tatsächlichen Situation angepasst werden.

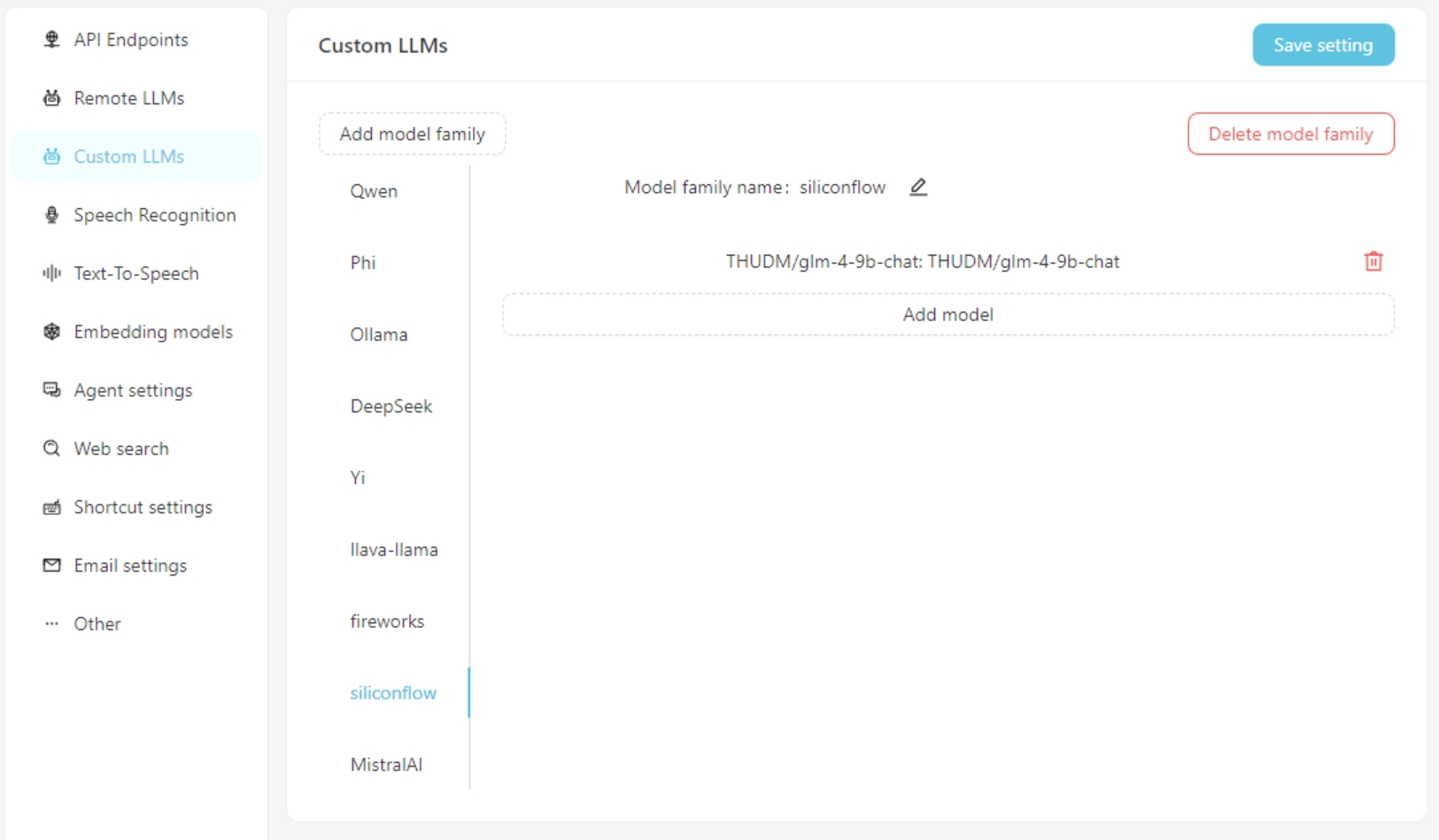

Wenn Sie ein benutzerdefiniertes großes Sprachmodell verwenden, geben Sie die benutzerdefinierten Modellkonfigurationsinformationen auf der Registerkarte Custom LLMs ein. Derzeit werden Schnittstellen, die mit OpenAI kompatibel sind, unterstützt, wie LM-Studio, Ollama, VLLM usw.

Fügen Sie zuerst eine benutzerdefinierte Modellfamilie hinzu und fügen Sie dann ein benutzerdefiniertes Modell hinzu. Vergessen Sie nicht, auf die Schaltfläche Save Settings zu klicken.

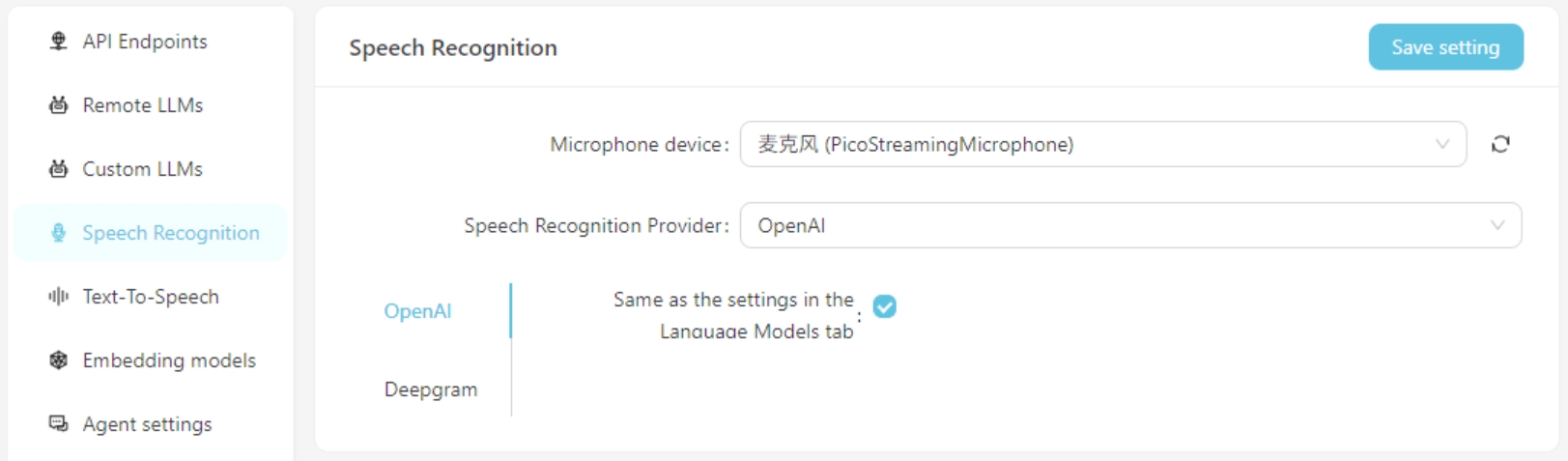

Derzeit werden die Spracherkennungsdienste von OpenAI/Deepgram unterstützt. Für OpenAI -Dienste können Sie dieselbe Konfiguration wie das große Sprachmodell verwenden oder einen Spracherkennungsdienst einrichten, der mit der OpenAI -API (wie GROQ) kompatibel ist.

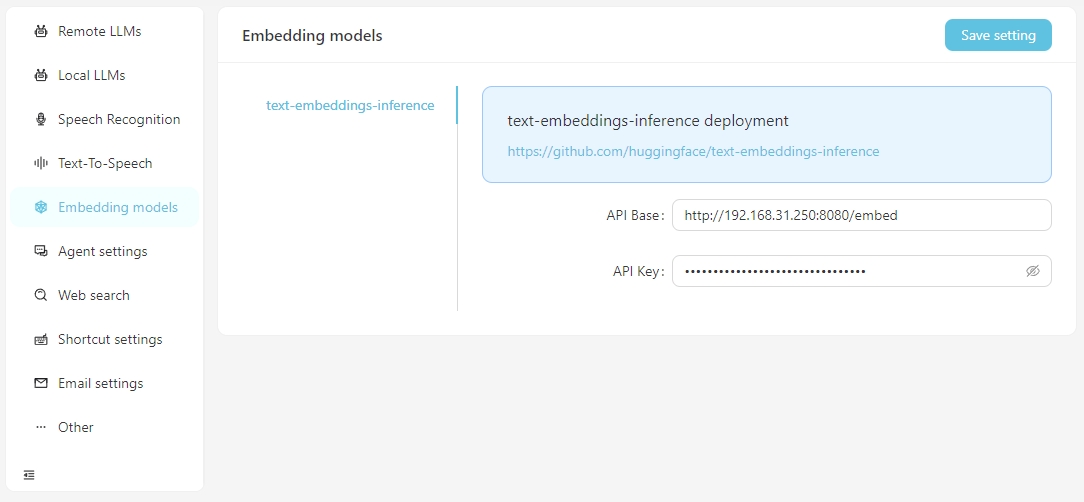

Wenn Sie Vektorsuche mithilfe von Vektordaten durchführen müssen, haben Sie die Option, Einbettungsdienste von OpenAI zu verwenden oder lokale Einbettungsdienste in den Embedding Model zu konfigurieren. Für unterstützte lokale Einbettungsdienste müssen Sie derzeit selbst Text-Embeddings-Inferenz einrichten.

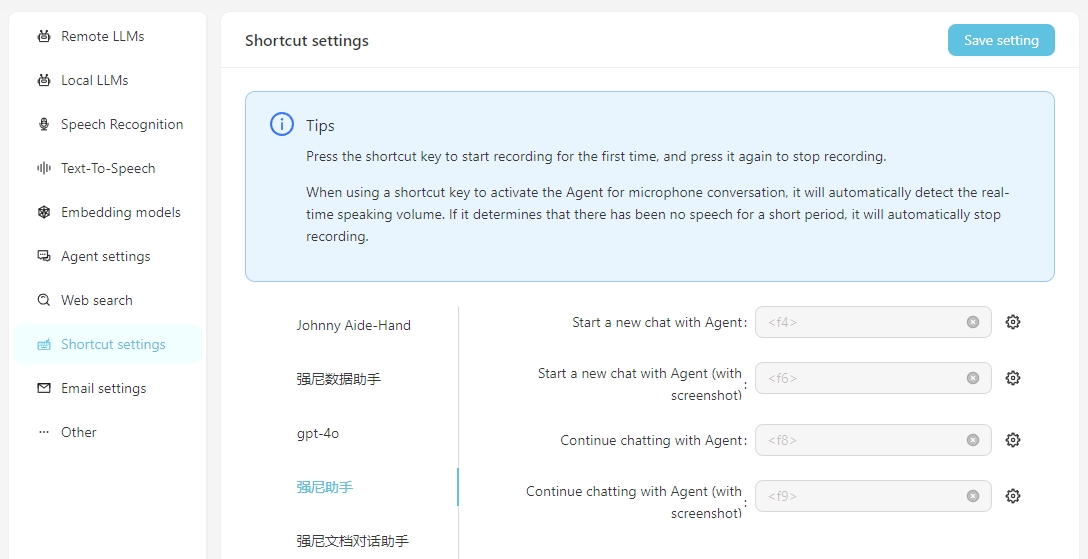

Um den täglichen Gebrauch zu vereinfachen, können Sie Verknüpfungen konfigurieren, um schnell Sprachgespräche mit dem Agenten zu initiieren. Durch die Durchführung der Verknüpfung können Sie direkt mit dem Agenten über die Spracherkennung interagieren. Es ist wichtig sicherzustellen, dass der Spracherkennungsdienst im Voraus korrekt konfiguriert ist.

Einschließen von Screenshot bedeutet, dass beim Starten der Konversation ein Screenshot des Bildschirms als Anhang an die Konversation aufgenommen und hochgeladen wird.

Um Ihre eigene lokale stabile Diffusions-API zu verwenden, müssen Sie den Parameter-API dem Startelement von webui-user.bat, das heißt, hinzufügen

set COMMANDLINE_ARGS=--api

Ein Workflow stellt einen Arbeitsaufgabeprozess dar, einschließlich Eingabe, Ausgabe und der Verarbeitung des Eingangs, um das Ausgabeergebnis zu erreichen.

Beispiele:

Übersetzungsworkflow : Die Eingabe ist ein englisches Wortdokument, und die Ausgabe ist auch ein Word -Dokument. Sie können einen Workflow entwerfen, um das chinesische Eingangsdokument zu übersetzen und eine chinesische Dokumentausgabe zu generieren.

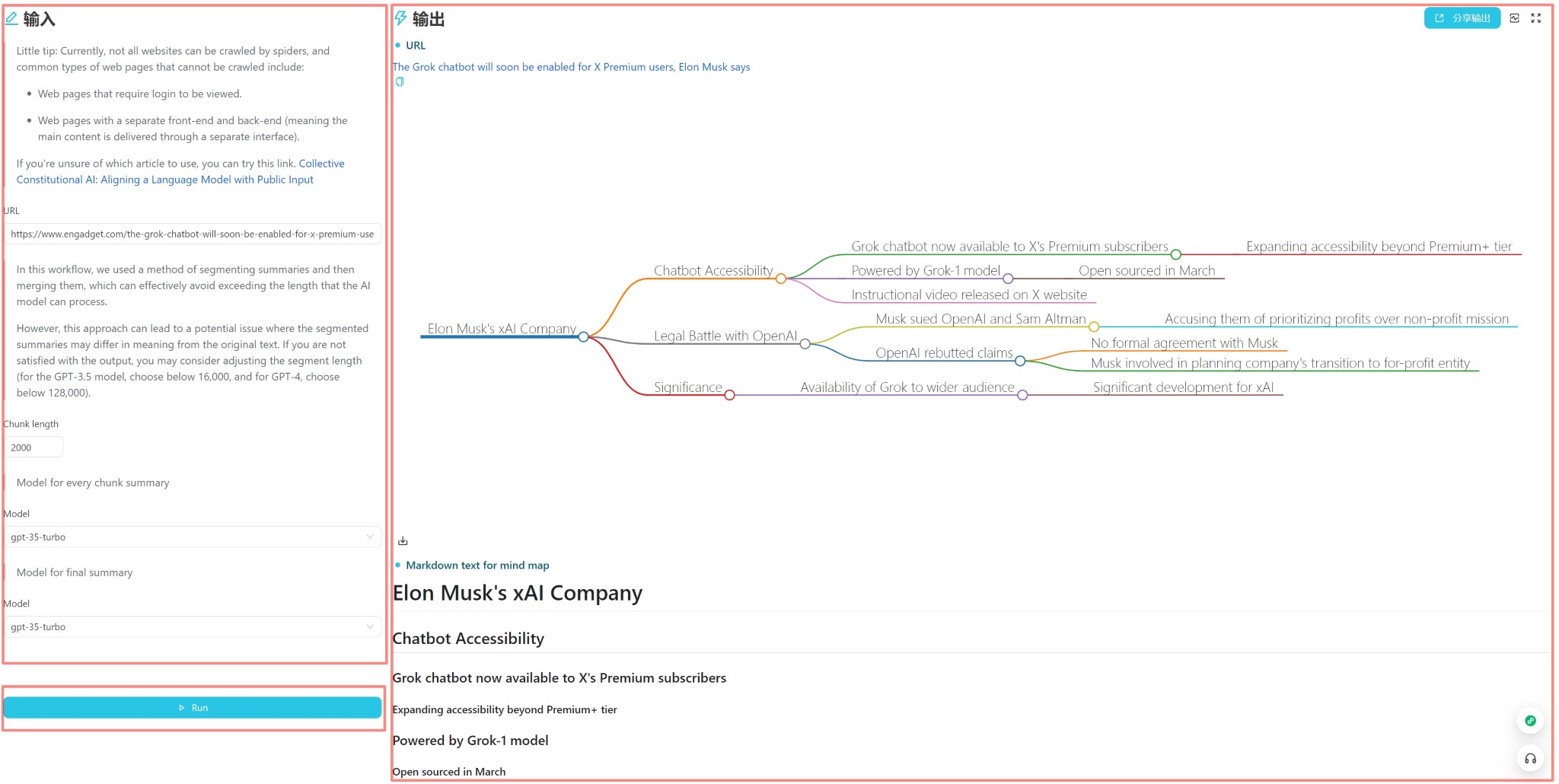

Mind Map Workflow : Wenn die Ausgabe des Übersetzungs -Workflows in eine Mind Map geändert wird, können Sie einen Workflow erhalten, der ein englisches Wortdokument liest und ihn in eine chinesische Mind -Karte zusammenfasst.

Zusammenfassender Workflow für Webartikel : Wenn die Eingabe des Mind Map Workflows in eine URL eines Webartikels geändert wird, können Sie einen Workflow erhalten, der einen Webartikel liest und ihn in eine chinesische Mind -Karte zusammenfasst.

Automatische Klassifizierung von Kundenbeschwerden Workflow : Die Eingabe ist eine Tabelle mit Beschwerdeinhalten, und Sie können die Schlüsselwörter anpassen, die klassifiziert werden müssen, damit die Beschwerden automatisch klassifiziert werden können. Die Ausgabe ist eine automatisch generierte Excel -Tabelle, die die Klassifizierungsergebnisse enthält.

Jeder Workflow verfügt über eine Benutzeroberfläche und eine Editor -Oberfläche . Die Benutzeroberfläche wird für den täglichen Workflow -Operationen verwendet, und die Editor -Schnittstelle wird für die Bearbeitung von Workflow verwendet. Normalerweise müssen Sie nach dem Entwerfen eines Workflows ihn nur in der Benutzeroberfläche ausführen und nicht in der Editor -Schnittstelle ändern.

Die Benutzeroberfläche ist oben angezeigt und in drei Teile unterteilt: Eingabe, Ausgabe und Trigger (normalerweise eine Taste für die Ausführung). Sie können den Inhalt direkt für den täglichen Gebrauch eingeben. Klicken Sie auf die Schaltfläche Ausführen, um das Ausgabeergebnis anzuzeigen.

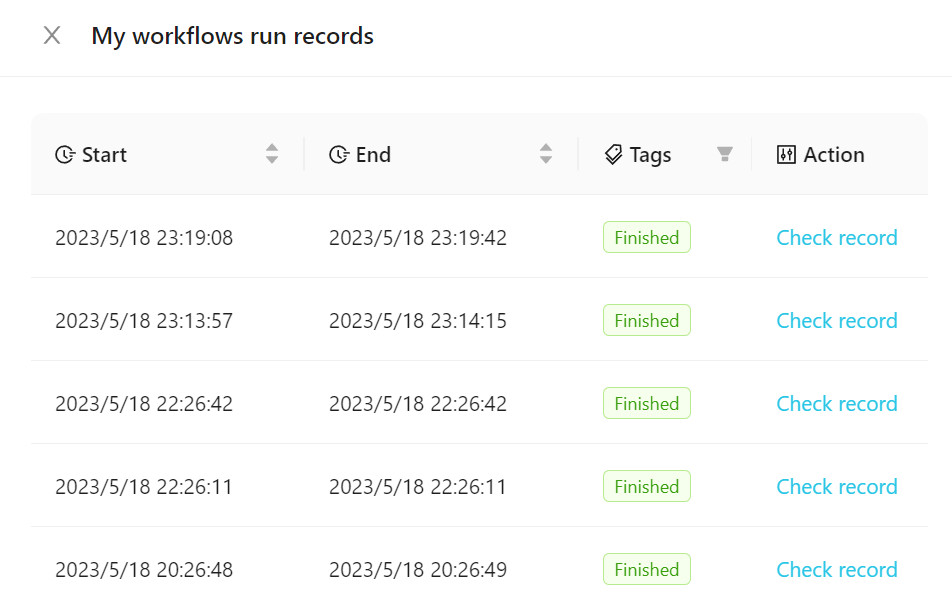

Klicken Sie, um den ausgeführten Workflow anzuzeigen, auf Workflow -Ausführungsdatensätze , wie in der folgenden Abbildung gezeigt.

Sie können unsere offiziellen Vorlagen zu Ihrem Workflow hinzufügen oder eine neue erstellen. Es wird empfohlen, sich mit der Verwendung von Workflows mit offiziellen Vorlagen am Anfang vertraut zu machen.

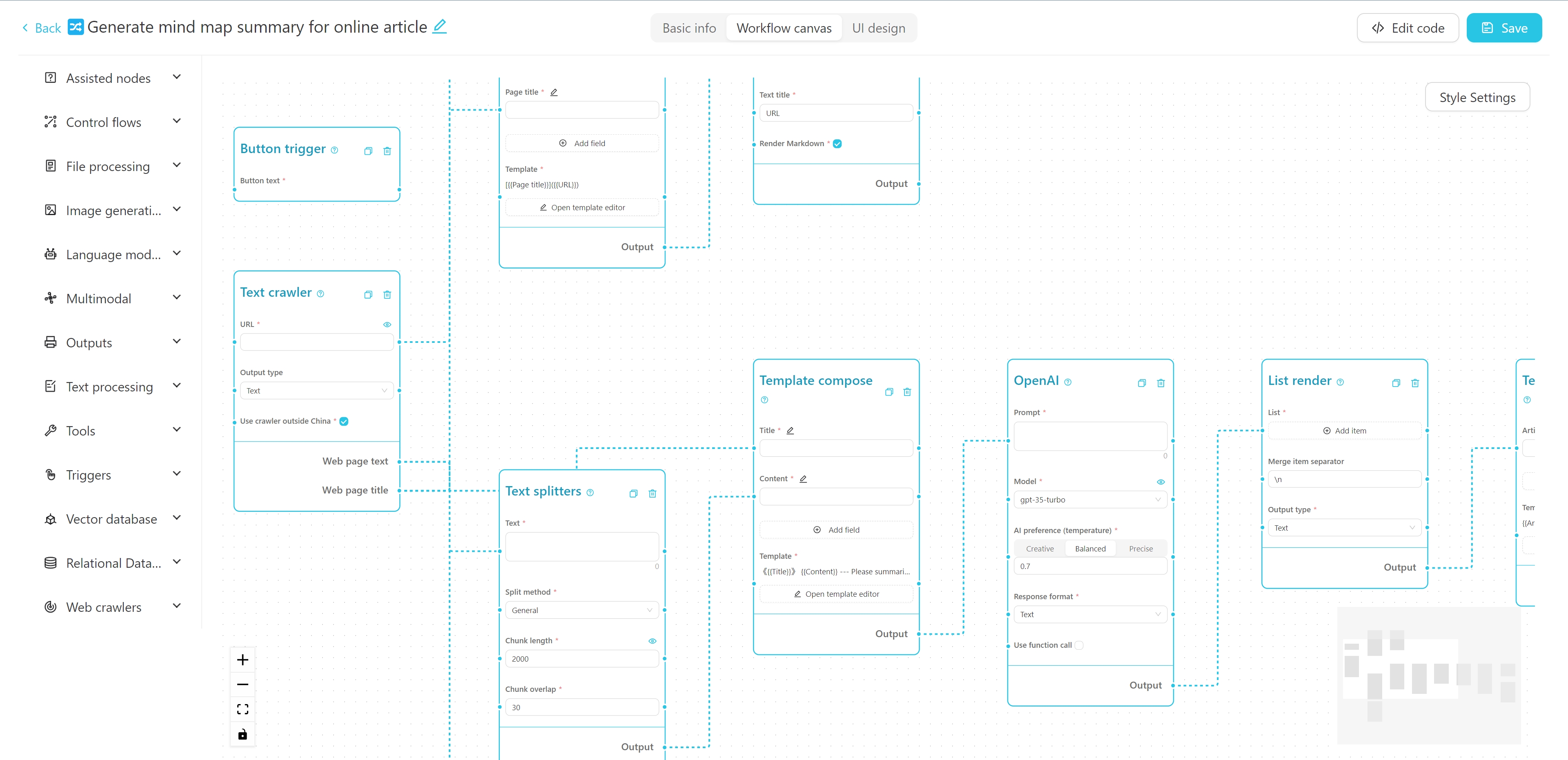

Die Workflow -Editor -Schnittstelle ist oben gezeigt. Sie können den Namen, die Tags und die detaillierte Beschreibung oben bearbeiten. Die linke Seite ist die Knotenliste des Workflows und die rechte Leinwand des Workflows. Sie können den gewünschten Knoten von der linken Seite zur Leinwand ziehen und dann den Knoten durch den Kabel anschließen, um einen Workflow zu bilden.

Sie können hier ein Tutorial zum Erstellen eines einfachen Crawler + AI -Zusammenfassungskarten -Workflows anzeigen.

Sie können dieses interaktive Online -Tutorial auch ausprobieren.

Backend

Python 3.8 ~ Python 3.11

PDM installiert

Frontend

VUE3

Vite

Führen Sie den folgenden Befehl im Backend -Verzeichnis aus, um Abhängigkeiten zu installieren:

PDM Installation

PDM install -g Mac

Normalerweise findet PDM automatisch das Python des Systems und erstellt eine virtuelle Umgebung und installiert Abhängigkeiten.

Führen Sie nach der Installation den folgenden Befehl aus, um den Backend Development Server zu starten und den laufenden Effekt zu sehen:

PDM Run Dev

Wenn Sie den Frontend -Code ändern müssen, müssen Sie den folgenden Befehl im Frontend -Verzeichnis ausführen, um Abhängigkeiten zu installieren:

PNPM Installation

Wenn Sie den Projektcode zum ersten Mal ziehen, müssen Sie auch

pnpm installausführen, um die Front-End-Abhängigkeiten zu installieren.Wenn Sie überhaupt keinen Front-End-Code entwickeln müssen, können Sie den

webdirekt aus der Versionsversion in denbackend-Ordner kopieren.

Nachdem die Frontend -Abhängigkeiten installiert sind, müssen Sie den Frontend -Code in das statische Dateiverzeichnis des Backends zusammenstellen. Im Projekt wurde eine Verknüpfungsanweisung vorgelegt. Führen Sie den folgenden Befehl im Backend -Verzeichnis aus, um die Frontend -Ressourcen zu packen und zu kopieren:

PDM Run Build-Front

Warnung

Bevor Sie Änderungen an der Datenbankstruktur vornehmen, sehen Sie bitte Ihre Datenbank (befindet sich unter my_database.db in Ihrem konfigurierten data ). Andernfalls können Sie Daten verlieren.

Wenn Sie die Modellstruktur in backend/models geändert haben, müssen Sie die folgenden Befehle im backend -Verzeichnis ausführen, um die Datenbankstruktur zu aktualisieren:

Geben Sie zunächst die Python -Umgebung ein:

PDM Run Python

Aus den Modellen importieren create_minrationscreate_minrations ("migration_name") # Name gemäß den vorgenommenen Änderungen Nach dem Vorgang wird eine neue Migrationsdatei im backend/migrations -Verzeichnis mit dem Dateiname -Format xxx_migration_name.py generiert. Es wird empfohlen, den Inhalt der Migrationsdatei zuerst zu überprüfen, um sicherzustellen, dass sie korrekt ist, und dann das Hauptprogramm neu zu starten. Das Hauptprogramm führt automatisch die Migration aus.

Das Projekt verwendet Pyinstaller für die Verpackung. Führen Sie den folgenden Befehl im Backend -Verzeichnis aus, um ihn in eine ausführbare Datei zu verpacken:

PDM Run Build

Nach der Verpackung wird die ausführbare Datei im Backend/Dist -Verzeichnis generiert.

Vectorvein ist eine Open-Source-Software, die den persönlichen nichtkommerziellen Gebrauch unterstützt. Bitte beachten Sie die Lizenz für bestimmte Vereinbarungen.