ragapp

v0.1.5

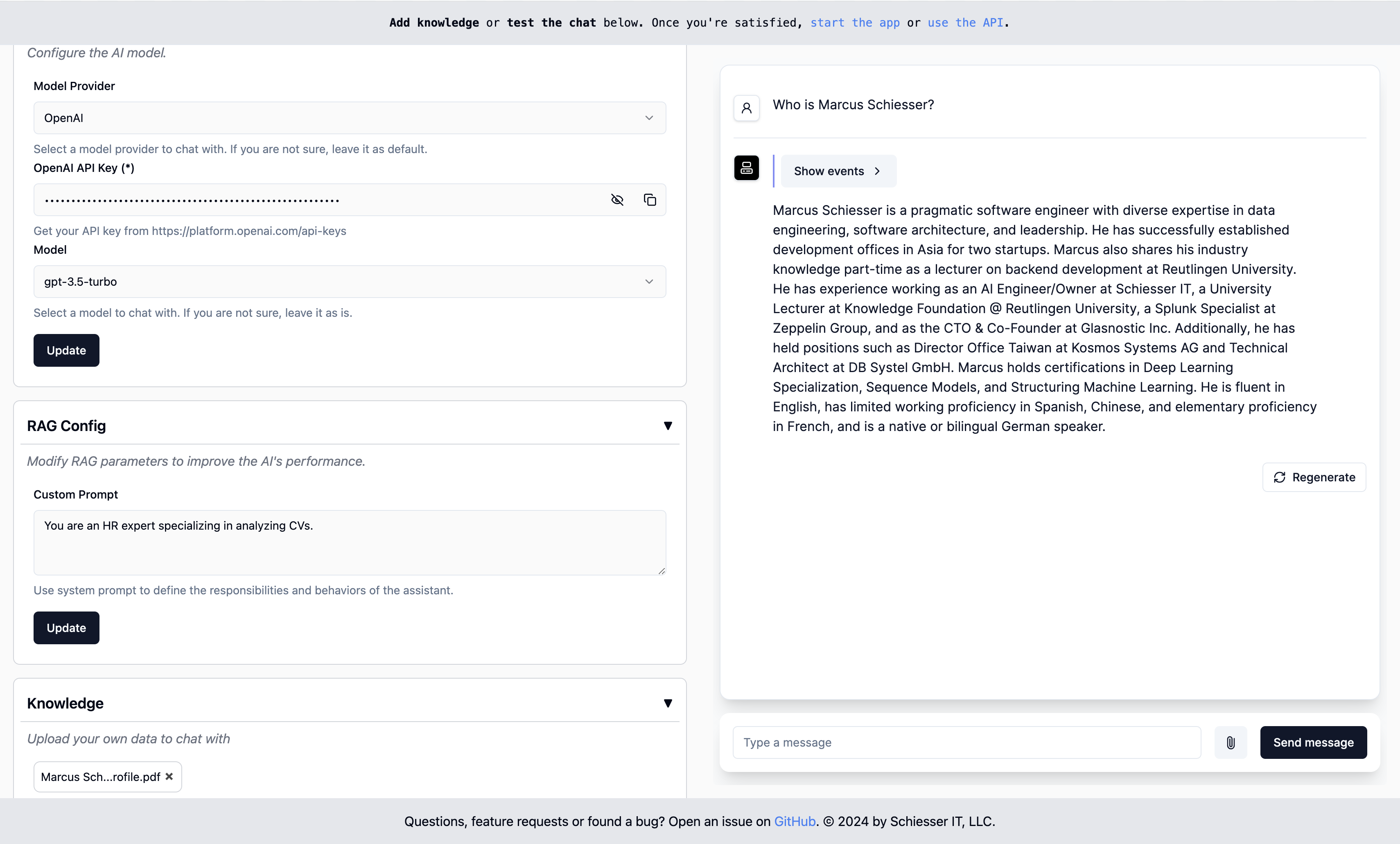

在任何企业中使用代理抹布的最简单方法。

易于配置为OpenAI的自定义GPT,但可以在您自己的云基础架构中使用Docker部署。使用LlamainDex建造。

入门·端点·部署·联系人

要运行,请使用我们的图像启动Docker容器:

docker run -p 8000:8000 ragapp/ragapp然后,通过http:// localhost访问管理UI:8000/admin配置您的ragapp。

您可以使用OpenAI或Gemini的托管AI型号以及使用Ollama的本地模型。

注意:要避免遇到任何错误,我们建议使用最新版本的Docker和(如果需要)Docker组成。

Docker容器公开以下端点:

注意:仅在配置ragapp时,CHAT UI和API才起作用。

只是ragapp容器不带设计任何身份验证层。这是API网关将流量路由到Ragapp的任务。此步骤在很大程度上取决于您的云提供商和您使用的服务。对于纯的Docker组成环境,您可以通过管理UI部署来查看我们的Ragapp。

Ragapp的后期版本将支持基于从API网关转发或类似的访问令牌的限制访问。

您可以通过其中一种docker组成的部署来轻松地将ragapp部署到自己的基础架构上:

在您自己的云基础架构中部署Ragapp很容易。定制的K8部署描述符即将推出。

重要的是:该项目源代码的一部分是从创建式项目中动态检索的。在进行更改之前,请确保通过调用

make build-frontends来更新源代码。

移动到SRC/RAGAPP目录,然后从这些命令开始:

export ENVIRONMENT=dev

poetry install --no-root

make build-frontends

make dev然后,要查看Admin UI,请访问http:// localhost:3000/admin。

注意:确保安装了诗歌。

问题,功能请求还是找到错误?打开问题或与Marcusschiesser接触。