あらゆる企業でエージェントラグを使用する最も簡単な方法。

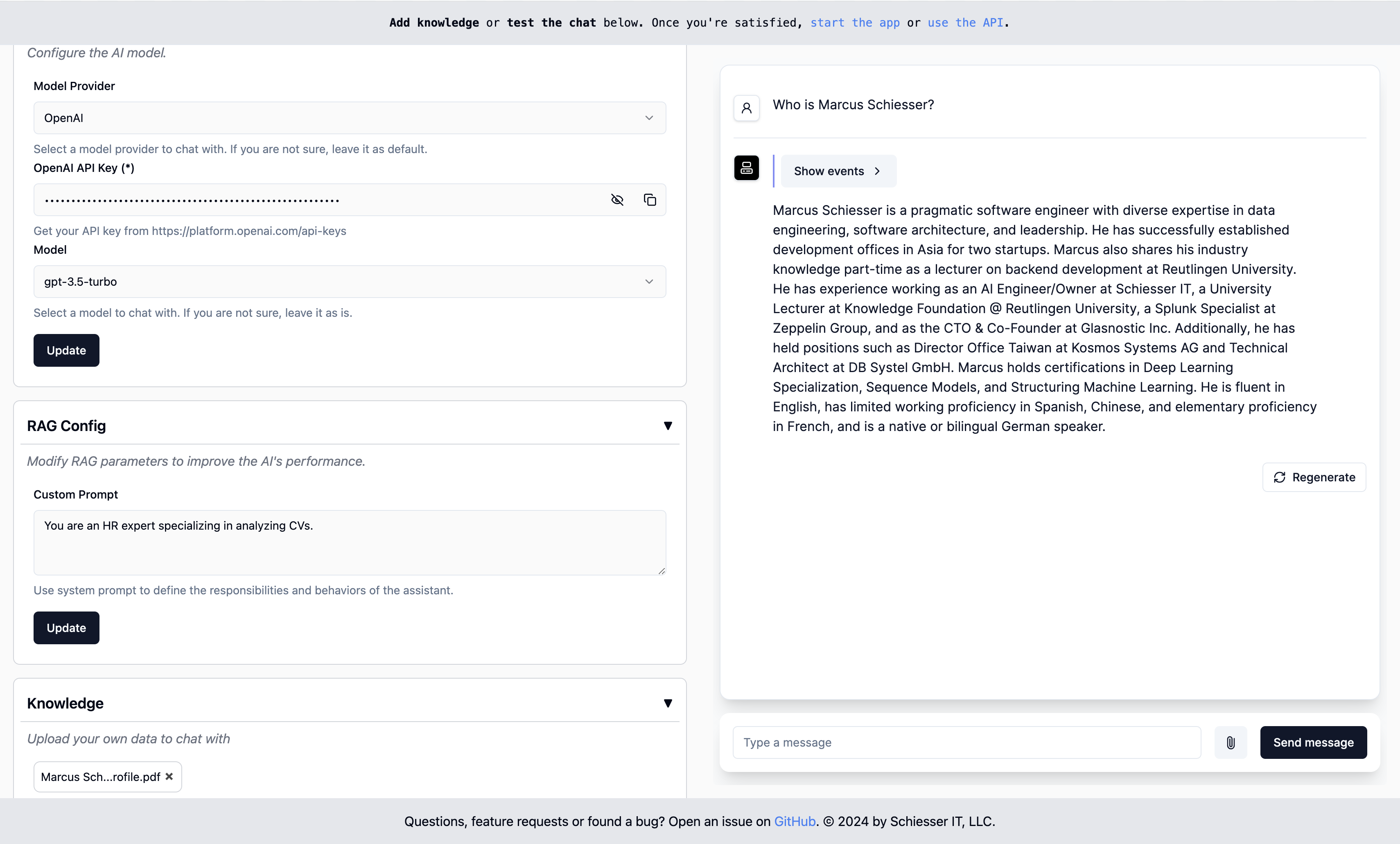

OpenaiのカスタムGPTとして簡単に構成できますが、Dockerを使用して独自のクラウドインフラストラクチャに展開できます。 LlamainDexを使用して構築されています。

開始します・エンドポイント・展開・連絡先

実行するには、画像でDockerコンテナを開始します。

docker run -p 8000:8000 ragapp/ragapp次に、http:// localhost:8000/adminで管理者UIにアクセスして、ragappを構成します。

OpenaiまたはGeminiのホストAIモデル、Ollamaを使用してローカルモデルを使用できます。

注:エラーが発生しないようにするには、Dockerの最新バージョンと(必要に応じて)Docker Composeを使用することをお勧めします。

Dockerコンテナは、次のエンドポイントを公開します。

注:チャットUIとAPIは、RAGAPPが構成されている場合にのみ機能します。

Ragappコンテナだけには、設計による認証レイヤーが付属していません。これは、トラフィックをRagAppにルーティングするAPIゲートウェイのタスクです。このステップは、クラウドプロバイダーと使用するサービスに大きく依存します。純粋なDocker Compose環境の場合、管理UIの展開を備えたRagappを見ることができます。

RagAppの後のバージョンは、APIゲートウェイまたは同様のアクセストークンに基づいてアクセスの制限をサポートします。

これらのDocker Compose Deploymentsのいずれかを使用して、RagAppを独自のインフラストラクチャに簡単に展開できます。

Ragappを独自のクラウドインフラストラクチャに簡単に展開できます。カスタマイズされたK8S展開記述子はまもなく登場します。

重要:このプロジェクトのソースコードの一部は、Create-Llamaプロジェクトから動的に取得されます。変更をコミットする前に、

make build-frontendsを呼び出してソースコードを更新してください。

SRC/ragappディレクトリに移動し、これらのコマンドから始めます。

export ENVIRONMENT=dev

poetry install --no-root

make build-frontends

make dev次に、管理者UIをチェックアウトするには、http:// localhost:3000/adminにアクセスします。

注:詩がインストールされていることを確認してください。

質問、機能のリクエスト、またはバグが見つかりましたか?問題を開くか、Marcusschiesserに連絡してください。