모든 기업에서 에이전트 래그를 사용하는 가장 쉬운 방법.

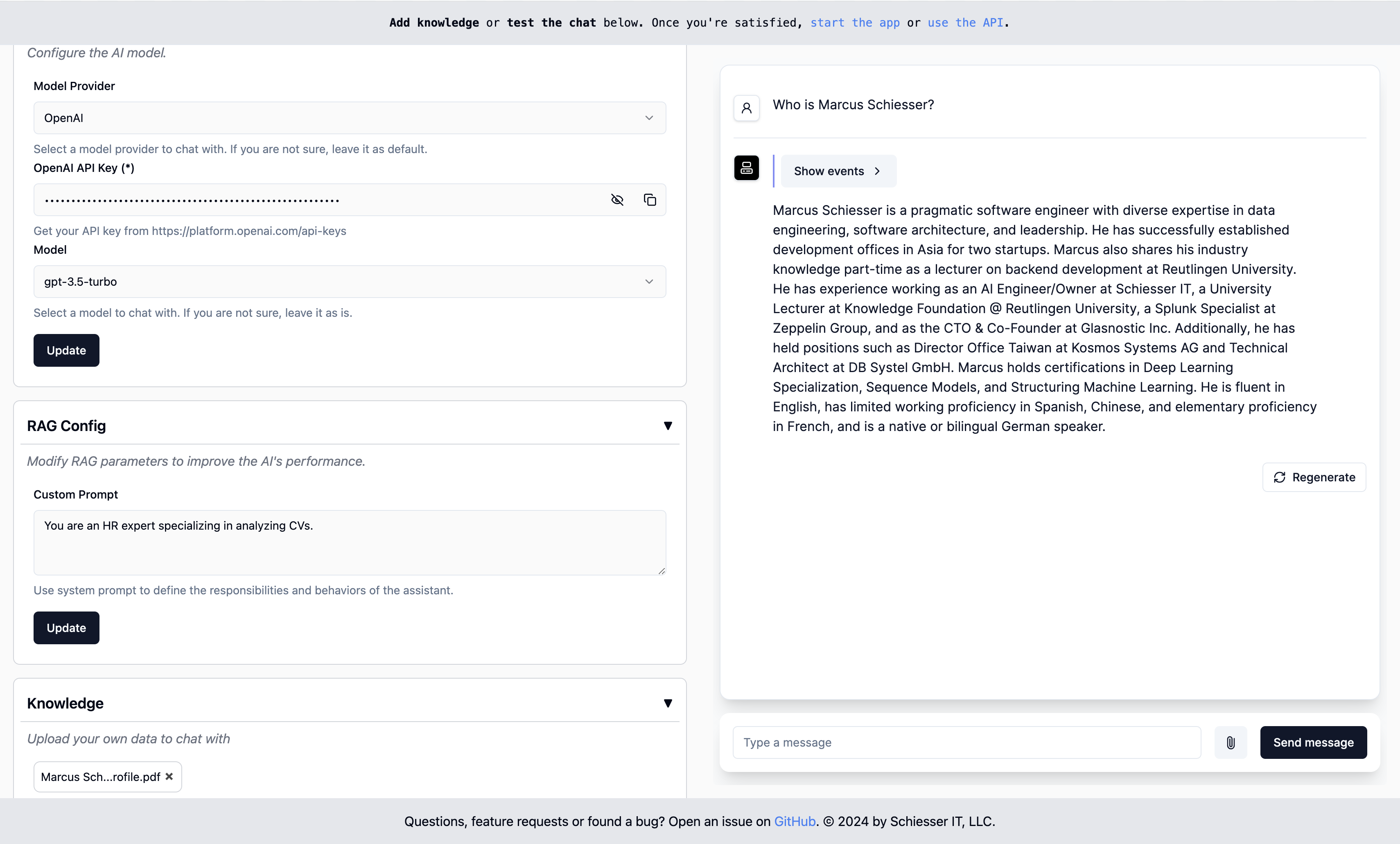

OpenAI의 사용자 정의 GPT로 구성하는 것은 간단하지만 Docker를 사용하여 자체 클라우드 인프라에 배포 할 수 있습니다. llamaindex를 사용하여 제작되었습니다.

시작 · 엔드 포인트 · 배포 · 연락처

실행하려면 이미지와 함께 Docker 컨테이너를 시작하십시오.

docker run -p 8000:8000 ragapp/ragapp그런 다음 ragapp를 구성하려면 http : // localhost : 8000/admin에서 admin ui에 액세스하십시오.

OpenAi 또는 Gemini에서 호스팅 된 AI 모델과 Ollama를 사용하는 로컬 모델을 사용할 수 있습니다.

참고 : 오류가 발생하지 않으려면 최신 버전의 Docker 및 (필요한 경우) Docker Compose를 사용하는 것이 좋습니다.

Docker 컨테이너는 다음 엔드 포인트를 노출시킵니다.

참고 : 채팅 UI 및 API는 RAGAPP가 구성된 경우에만 작동합니다.

Ragapp 컨테이너 만 디자인별로 인증 계층이 제공되지 않습니다. 이것은 트래픽을 RAGAPP로 라우팅하는 API 게이트웨이의 작업입니다. 이 단계는 클라우드 제공 업체와 사용하는 서비스에 크게 의존합니다. Pure Docker Compose 환경의 경우 Management UI 배포와 함께 Ragapp을 볼 수 있습니다.

이후 버전의 RAGAPP는 API 게이트웨이 또는 이와 유사한 액세스 토큰을 기반으로 한 액세스 제한을 지원합니다.

이러한 Docker Compose 배포 중 하나를 사용하여 RAGAPP를 자신의 인프라에 쉽게 배포 할 수 있습니다.

자체 클라우드 인프라에 RAGAPP를 쉽게 배포 할 수 있습니다. 맞춤형 K8S 배포 설명자가 곧 출시 될 예정입니다.

중요 :이 프로젝트 소스 코드의 일부는 Create-Llama 프로젝트에서 동적으로 검색됩니다. 변경 사항을 커밋하기 전에

make build-frontends호출하여 소스 코드를 업데이트하십시오.

SRC/RAGAPP 디렉토리로 이동하여 다음에 시작하십시오.

export ENVIRONMENT=dev

poetry install --no-root

make build-frontends

make dev그런 다음 관리자 UI를 확인하려면 http : // localhost : 3000/admin으로 이동하십시오.

참고 : 시가 설치되어 있는지 확인하십시오.

질문, 기능 요청 또는 버그를 찾았습니까? 문제를 열거 나 Marcusschiesser에게 연락하십시오.