วิธีที่ง่ายที่สุดในการใช้ผ้าขี้ริ้วในองค์กรใด ๆ

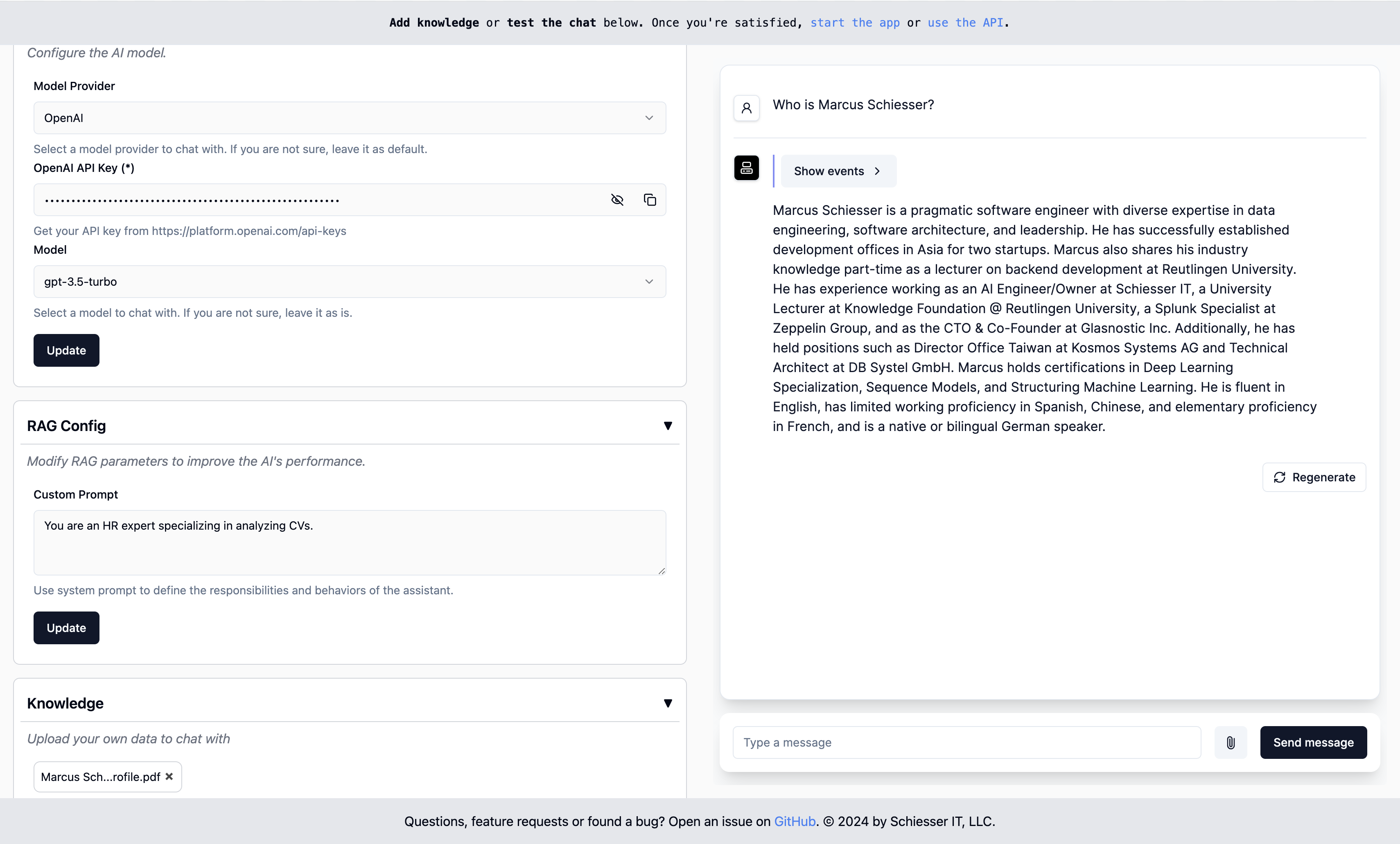

ง่ายต่อการกำหนดค่าเป็น GPT ที่กำหนดเองของ OpenAI แต่สามารถปรับใช้ในโครงสร้างพื้นฐานคลาวด์ของคุณเองโดยใช้ Docker สร้างขึ้นโดยใช้ llamaidex

เริ่มต้นใช้งาน · จุดสิ้นสุด · การปรับใช้ · ติดต่อ

ในการเรียกใช้ให้เริ่มคอนเทนเนอร์ Docker ด้วยรูปภาพของเรา:

docker run -p 8000:8000 ragapp/ragappจากนั้นเข้าถึงผู้ดูแลระบบ UI ที่ http: // localhost: 8000/admin เพื่อกำหนดค่า ragapp ของคุณ

คุณสามารถใช้โมเดล AI ที่โฮสต์ได้จาก OpenAI หรือ Gemini และรุ่นท้องถิ่นโดยใช้ Ollama

หมายเหตุ : เพื่อหลีกเลี่ยงการพบกับข้อผิดพลาดใด ๆ เราขอแนะนำให้ใช้ Docker เวอร์ชันล่าสุดและ (ถ้าจำเป็น) นักเทียบท่า

คอนเทนเนอร์ Docker เปิดเผยจุดสิ้นสุดต่อไปนี้:

หมายเหตุ : แชท UI และ API นั้นใช้งานได้ก็ต่อเมื่อมีการกำหนดค่า RAGAPP

เพียงแค่คอนเทนเนอร์ Ragapp ไม่ได้มาพร้อมกับเลเยอร์การตรวจสอบความถูกต้องใด ๆ โดยการออกแบบ นี่คืองานของเกตเวย์ API ที่กำหนดเส้นทางการรับส่งข้อมูลไปยัง Ragapp ขั้นตอนนี้ขึ้นอยู่กับผู้ให้บริการคลาวด์และบริการที่คุณใช้อย่างมาก สำหรับสภาพแวดล้อมที่เขียนขึ้นมาอย่างบริสุทธิ์คุณสามารถดู RAGAPP ของเราด้วยการปรับใช้ UI การจัดการ

Ragapp รุ่นต่อมาจะสนับสนุนการ จำกัด การเข้าถึงตามโทเค็นการเข้าถึงที่ส่งต่อจากเกตเวย์ API หรือที่คล้ายกัน

คุณสามารถปรับใช้ RAGAPP กับโครงสร้างพื้นฐานของคุณเองได้อย่างง่ายดาย

เป็นเรื่องง่ายที่จะปรับใช้ Ragapp ในโครงสร้างพื้นฐานคลาวด์ของคุณเอง ตัวบ่งชี้การปรับใช้ K8S ที่กำหนดเองกำลังจะมาเร็ว ๆ นี้

สำคัญ : บางส่วนของซอร์สโค้ดของโครงการนี้ถูกดึงออกมาจากโครงการ Create-llama แบบไดนามิก ก่อนที่จะทำการเปลี่ยนแปลงตรวจสอบให้แน่ใจว่าได้อัปเดตซอร์สโค้ดโดยเรียก

make build-frontends

ย้ายไปที่ไดเรกทอรี SRC/RAGAPP และเริ่มต้นด้วยคำสั่งเหล่านี้:

export ENVIRONMENT=dev

poetry install --no-root

make build-frontends

make devจากนั้นเพื่อตรวจสอบ UI ผู้ดูแลระบบให้ไปที่ http: // localhost: 3000/admin

หมายเหตุ : ตรวจสอบให้แน่ใจว่าคุณติดตั้งบทกวีแล้ว

คำถามการร้องขอคุณสมบัติหรือพบข้อผิดพลาด? เปิดปัญหาหรือติดต่อกับ Marcusschiesser