La façon la plus simple d'utiliser un chiffon agentique dans n'importe quelle entreprise.

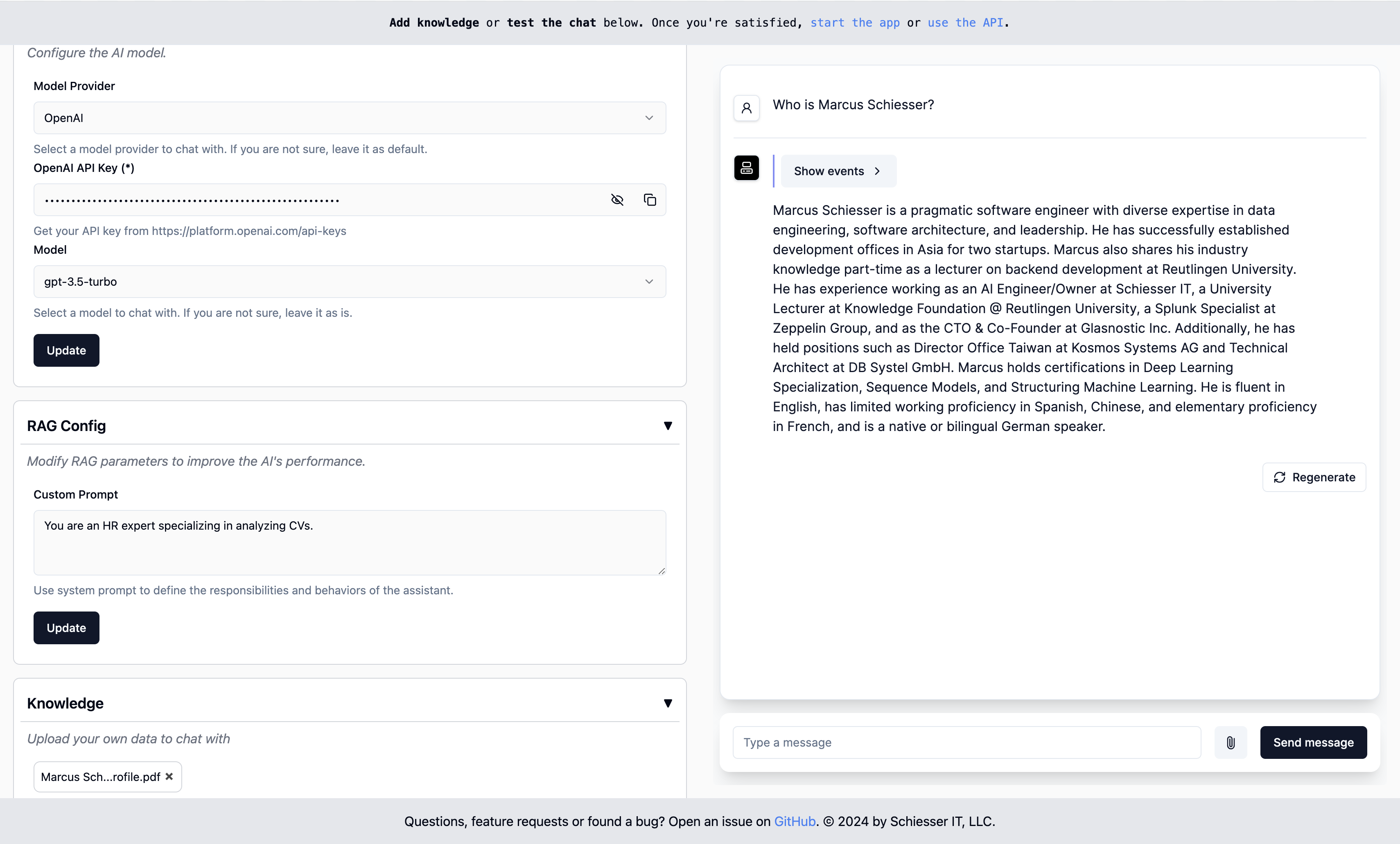

Aussi simple à configurer que les GPT personnalisés d'OpenAI, mais déployables dans votre propre infrastructure cloud à l'aide de Docker. Construit en utilisant Llamaindex.

Démarrer · Points de terminaison · Déploiement · Contact

Pour fonctionner, démarrez un conteneur Docker avec notre image:

docker run -p 8000:8000 ragapp/ragappEnsuite, accédez à l'administrateur de l'administration sur http: // localhost: 8000 / admin pour configurer votre ragapp.

Vous pouvez utiliser des modèles d'IA hébergés d'Openai ou Gemini, et des modèles locaux à l'aide d'Olllama.

Remarque : Pour éviter de rencontrer des erreurs, nous vous recommandons d'utiliser la dernière version de Docker et (si nécessaire) Docker Compose.

Le conteneur Docker expose les points de terminaison suivants:

Remarque : l'interface utilisateur de chat et l'API ne sont fonctionnelles que si le ragapp est configuré.

Le conteneur ragapp n'est pas livré avec aucune couche d'authentification par conception. Ceci est la tâche d'une passerelle API achetant le trafic vers RagApp. Cette étape dépend fortement de votre fournisseur de cloud et des services que vous utilisez. Pour un environnement Docker Pure Docker, vous pouvez consulter notre déploiement de l'interface utilisateur de la gestion.

Les versions ultérieures de RagApp soutiendront la restriction de l'accès basé sur les jetons d'accès transmis à partir d'une passerelle API ou similaire.

Vous pouvez facilement déployer Ragapp dans votre propre infrastructure avec l'un de ces déploiements Docker Compose:

Il est facile de déployer Ragapp dans votre propre infrastructure cloud. Des descripteurs de déploiement K8S personnalisés arrivent bientôt.

IMPORTANT : Les parties du code source de ce projet sont récupérées dynamiquement à partir du projet Create-Llama. Avant de commettre des modifications, assurez-vous de mettre à jour le code source en appelant

make build-frontends.

Passez au répertoire SRC / Ragapp et commencez par ces commandes:

export ENVIRONMENT=dev

poetry install --no-root

make build-frontends

make devEnsuite, pour consulter l'interface utilisateur de l'administrateur, allez sur http: // localhost: 3000 / admin.

Remarque : assurez-vous que la poésie installe.

Questions, demandes de fonctionnalités ou trouvé un bug? Ouvrez un problème ou contactez Marcusschiesser.