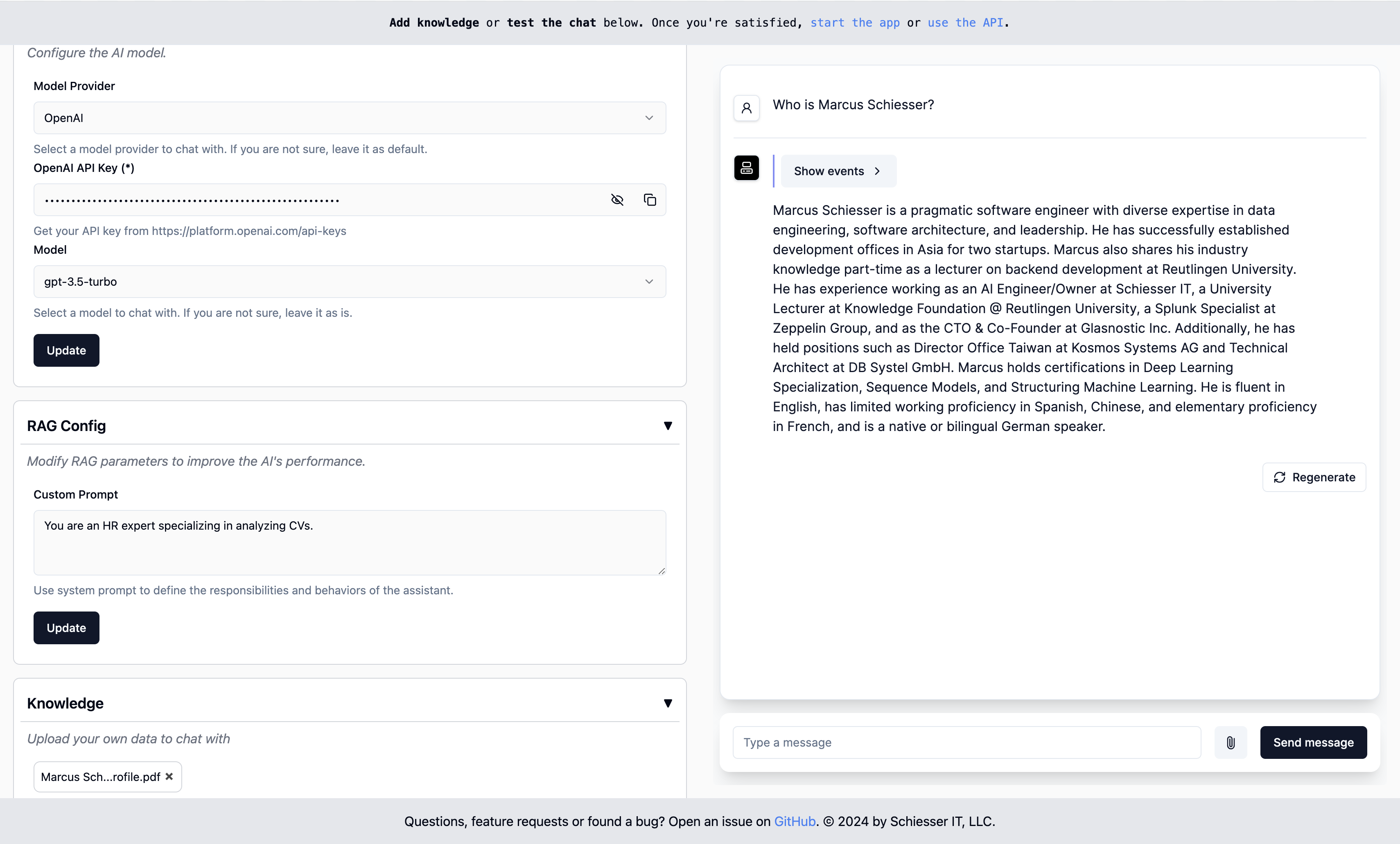

أسهل طريقة لاستخدام خرقة Agentic في أي مؤسسة.

سهلة التكوين مثل GPTs المخصصة من Openai ، ولكن يمكن نشرها في البنية التحتية السحابية الخاصة بك باستخدام Docker. بنيت باستخدام llamaindex.

ابدأ · نقاط النهاية · النشر · الاتصال

للتشغيل ، ابدأ حاوية Docker مع صورتنا:

docker run -p 8000:8000 ragapp/ragappبعد ذلك ، قم بالوصول إلى واجهة المستخدم على http: // localhost: 8000/admin لتكوين ragapp الخاص بك.

يمكنك استخدام نماذج الذكاء الاصطناعى المستضافة من Openai أو Gemini ، والموديلات المحلية باستخدام Ollama.

ملاحظة : لتجنب الخوض في أي أخطاء ، نوصي باستخدام أحدث إصدار من Docker و (إذا لزم الأمر) Docker.

تعرض حاوية Docker نقاط النهاية التالية:

ملاحظة : تعتبر واجهة المستخدم و API وظيفية فقط إذا تم تكوين Ragapp.

فقط حاوية Ragapp لا تأتي مع أي طبقة مصادقة حسب التصميم. هذه هي مهمة بوابة API التي توجه حركة المرور إلى Ragapp. تعتمد هذه الخطوة اعتمادًا كبيرًا على مزود السحابة الخاص بك والخدمات التي تستخدمها. بالنسبة لبيئة Docker الخالصة ، يمكنك النظر إلى Ragapp مع نشر واجهة المستخدم.

ستدعم الإصدارات اللاحقة من Ragapp تقييد الوصول بناءً على رموز الوصول التي يتم إعادة توجيهها من بوابة API أو ما شابه ذلك.

يمكنك بسهولة نشر RAGAPP على البنية التحتية الخاصة بك مع واحدة من هذه Docker Complaments:

من السهل نشر Ragapp في البنية التحتية السحابية الخاصة بك. واصفات نشر K8S مخصصة ستأتي قريبًا.

هام : يتم استرداد أجزاء من رمز المصدر لهذا المشروع ديناميكيًا من مشروع Create-Llama. قبل ارتكاب التغييرات ، تأكد من تحديث الكود المصدر عن طريق الاتصال

make build-frontends.

انتقل إلى دليل SRC/RAGAPP وابدأ بهذه الأوامر:

export ENVIRONMENT=dev

poetry install --no-root

make build-frontends

make devثم ، للتحقق من واجهة المستخدم ، انتقل إلى http: // localhost: 3000/admin.

ملاحظة : تأكد من تثبيت الشعر.

أسئلة أو طلبات الميزة أو العثور على خطأ؟ افتح مشكلة أو تواصل مع Marcusschiesser.