ในสาขาปัญญาประดิษฐ์ Moore Thread นำนวัตกรรมทางเทคโนโลยีอีกครั้งและประกาศกรอบ AI ที่สำคัญสองอัน: โอเพ่นซอร์ส MT-MEGATRONLM และ MT-TransformerEngine การเคลื่อนไหวที่สำคัญนี้ไม่เพียง แต่ฉีดพลังใหม่เข้าสู่โครงสร้างพื้นฐานการคำนวณในประเทศเท่านั้น แต่ยังให้การสนับสนุนเครื่องมือที่ทรงพลังสำหรับนักพัฒนา AI ทั่วโลก ด้วยการบูรณาการกลยุทธ์การฝึกอบรมแบบไฮบริด FP8 อย่างลึกซึ้งและห้องสมุดผู้ให้บริการประสิทธิภาพสูงเฟรมเวิร์กทั้งสองนี้ได้รับการฝึกอบรมแบบไฮบริดแบบขนานและการอนุมานเกี่ยวกับ GPUs เต็มหน้าที่ในประเทศซึ่งเป็นการปรับปรุงประสิทธิภาพและความมั่นคงของการฝึกอบรมแบบจำลองขนาดใหญ่อย่างมีนัยสำคัญ

เฟรมเวิร์ก MT-MEGATRONLM ได้รับการออกแบบมาเป็นพิเศษสำหรับ GPU แบบเต็มฟังก์ชั่นรองรับการฝึกอบรมที่มีประสิทธิภาพของแบบจำลองความหนาแน่นแบบจำลองหลายรูปแบบและโมเดล MOE (Hybrid Expert) ตอบสนองความต้องการการฝึกอบรมที่หลากหลายในสนาม AI MT-transformerEngine มุ่งเน้นไปที่การฝึกอบรมและการเพิ่มประสิทธิภาพการอนุมานของโมเดลหม้อแปลง ผ่านการฟิวชั่นของผู้ปฏิบัติงานและกลยุทธ์การเร่งความเร็วแบบขนานและเทคโนโลยีอื่น ๆ มันจะปลดปล่อยศักยภาพของการคำนวณความหนาแน่นสูงของเธรดมัวร์ซึ่งช่วยปรับปรุงประสิทธิภาพของตัวดำเนินการหน่วยความจำที่ถูกผูกไว้อย่างมีนัยสำคัญ

ความก้าวหน้าทางเทคโนโลยีของสองเฟรมเวิร์กนี้ส่วนใหญ่สะท้อนให้เห็นในการทำงานร่วมกันอย่างลึกซึ้งของการปรับฮาร์ดแวร์และนวัตกรรมอัลกอริทึม ก่อนอื่นพวกเขาสนับสนุนการฝึกอบรมแบบผสมผสานแบบผสมผสานของโมเดลหลายประเภทซึ่งสามารถจัดการกับสถานการณ์การคำนวณที่ซับซ้อนของสถาปัตยกรรมแบบจำลองที่แตกต่างกัน ประการที่สองเมื่อรวมกับกลยุทธ์การฝึกอบรมความแม่นยำของ FP8 ไฮบริดที่สนับสนุนโดย Moore Thread GPU ช่วยปรับปรุงประสิทธิภาพการฝึกอบรมได้อย่างมีประสิทธิภาพ ประการที่สามผ่านการรวมเข้าด้วยกันอย่างลึกซึ้งของห้องสมุดผู้ให้บริการประสิทธิภาพสูง Mudnn และ McCl การสื่อสาร McCl ค่าใช้จ่ายในการสื่อสารของงานที่ต้องใช้การคำนวณมากและการ์ดหลายใบได้รับการปรับให้เหมาะสมอย่างเป็นระบบ ในเวลาเดียวกันเมื่อรวมกับไลบรารี Simumax โอเพนซอร์ซการค้นหากลยุทธ์แบบขนานสามารถดำเนินการได้โดยอัตโนมัติและประสิทธิภาพการฝึกอบรมแบบขนานสามารถขยายได้สูงสุดสำหรับรุ่นที่แตกต่างกันและสภาพแวดล้อมการเร่งความเร็ว นอกจากนี้กลไกการกู้คืนข้อยกเว้นย้อนกลับของเฟรมเวิร์กในตัวสามารถย้อนกลับไปยังโหนดที่เสถียรล่าสุดสำหรับการฝึกอบรมโดยอัตโนมัติเพื่อปรับปรุงความมั่นคงของการฝึกอบรมขนาดใหญ่อย่างมาก ในที่สุดทั้งสองเฟรมเวิร์กเข้ากันได้กับระบบนิเวศ GPU กระแสหลักซึ่งไม่เพียง แต่ทำให้มั่นใจได้ว่าการโยกย้ายระบบนิเวศที่มีอยู่เดิมอย่างราบรื่น แต่ยังให้การสนับสนุนพื้นฐานสำหรับนักพัฒนาเพื่อสร้างสแต็คเทคโนโลยี AI ของตนเอง

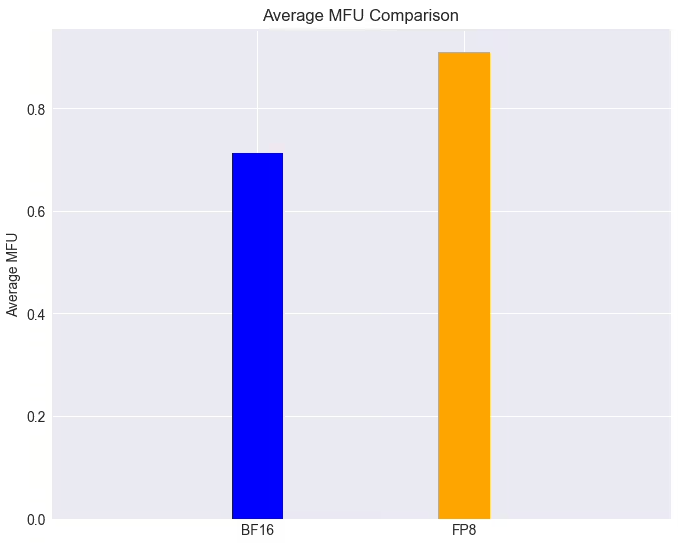

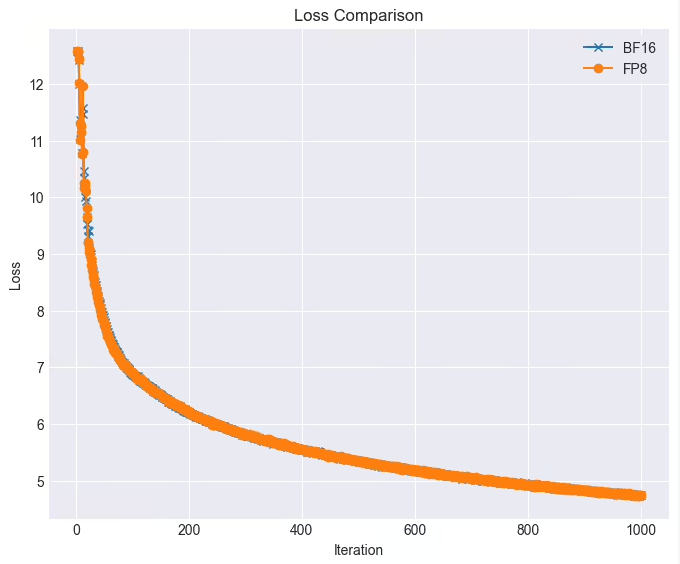

ในการใช้งานจริงประสิทธิภาพของสองเฟรมเวิร์กนี้น่าประทับใจ ในคลัสเตอร์ GPU แบบเต็มหน้าที่งานการฝึกอบรมของรุ่น LLAMA38B สามารถเข้าถึงได้มากกว่า 90% ด้วยเทคโนโลยี FP8 เมื่อการสูญเสียเกือบจะไม่มีการสูญเสียซึ่งสูงกว่าความเร็วการฝึกอบรมดั้งเดิม 28% นอกจากนี้เธรดมัวร์ได้รับการบูรณาการอย่างลึกซึ้งและโอเพ่นซอร์สเพื่อรองรับอัลกอริทึมคู่ขนาน Deepseek ได้อย่างมีประสิทธิภาพ หลังจาก MT-DualPipe เชื่อมต่ออย่างเต็มที่กับกรอบ MT-MEGATRON และกรอบ MT-TransformerEngine มันประสบความสำเร็จในการทำซ้ำกระบวนการฝึกอบรม Deepseek V3 ที่สนับสนุน MLA, MTP และกลยุทธ์ความสมดุลที่หลากหลาย เฟรมเวิร์กเหล่านี้ได้ปรับปรุงการใช้แบนด์วิดท์หน่วยความจำอย่างมีนัยสำคัญช่วยบรรเทาปัญหาคอขวดที่ถูกผูกไว้อย่างมีนัยสำคัญ

Moore Threading กล่าวว่าจะยังคงเพิ่มประสิทธิภาพทั้งสองเฟรมเวิร์กนี้และวางแผนที่จะแนะนำชุดของฟังก์ชั่นใหม่: รวมถึงกลยุทธ์คู่/Zerobubble คู่ขนานเพื่อลดอัตราฟองและปรับปรุงประสิทธิภาพการฝึกอบรมแบบขนาน ความหลากหลายของกลยุทธ์การเพิ่มประสิทธิภาพ FP8 ดั้งเดิมเพื่อปรับปรุงประสิทธิภาพการฝึกอบรมและความมั่นคง กลยุทธ์จุดตรวจสอบแบบอะซิงโครนัสเพื่อปรับปรุงความทนทานและประสิทธิภาพในระหว่างการฝึกอบรม กลยุทธ์การคำนวณใหม่ที่ดีที่สุดเพื่อลดการคำนวณและค่าใช้จ่ายหน่วยความจำและปรับปรุงความเร็วในการฝึกอบรม อัลกอริทึมการฝึกอบรมที่ทนต่อความผิดปกติเพื่อเพิ่มความทนทานต่อความผิดพลาดในระหว่างการฝึกอบรม และการรวมไลบรารีของ Moore Thread Flashmla และ DeepGemm เพื่อปลดปล่อยพลังการคำนวณและพลังการคำนวณ FP8 ของ Moore Thread GPU เพื่อปรับปรุงประสิทธิภาพการคำนวณและประสิทธิภาพ

ชุดของความก้าวหน้าทางเทคโนโลยีและมาตรการโอเพ่นซอร์สไม่เพียง แต่แสดงให้เห็นถึงความแข็งแกร่งของด้ายของมัวร์ในด้านพลังการคำนวณ AI แต่ยังเปิดโอกาสใหม่สำหรับการพัฒนาโครงสร้างพื้นฐาน AI ในประเทศ ให้เรารอและดูความก้าวหน้าเพิ่มเติมที่นำมาสู่การฝึกอบรมแบบจำลอง AI