Sitio web oficial www.binance.com/zh-cn :ingrese el sitio web oficial ☜☜

Aplicación: ☞☞Official App Download☜☜

En el campo de la inteligencia artificial, el hilo de Moore lideró una vez más la innovación tecnológica y anunció dos principales marcos de IA: código abierto MT-megatronlm y Mt-TransformerEngine. Este movimiento importante no solo inyecta una nueva vitalidad en la infraestructura informática doméstica, sino que también proporciona un poderoso soporte de herramientas para los desarrolladores de IA de todo el mundo. Al integrar profundamente las estrategias de entrenamiento híbrido FP8 y la biblioteca de operadores de alto rendimiento, estos dos marcos han logrado capacitación e inferencia paralela híbrida en GPU de funciones completas nacionales, mejorando significativamente la eficiencia y la estabilidad de la capacitación de modelos a gran escala.

El marco MT-MegatronLM está especialmente diseñado para GPU de la función completa, admite un entrenamiento eficiente de modelos de densidad, modelos multimodales y modelos MOE (experto híbrido), satisfaciendo las diversas necesidades de capacitación actuales en el campo de IA. MT-TransformerEngine se centra en la optimización de entrenamiento e inferencia de los modelos de transformadores. A través de estrategias de aceleración paralela y fusión del operador y otras tecnologías, libera efectivamente el potencial de la computación de alta densidad de los hilos Moore, lo que mejora significativamente la eficiencia del operador unido a la memoria.

Los avances tecnológicos de estos dos marcos se reflejan principalmente en la colaboración profunda de la adaptación de hardware y la innovación de algoritmos. Primero, admiten el entrenamiento paralelo mixto de múltiples tipos de modelos, que pueden lidiar de manera flexible con escenarios de computación complejos de diferentes arquitecturas de modelos; En segundo lugar, combinado con la estrategia de entrenamiento de precisión híbrida FP8 respaldada de forma nativa por Moore Thread GPU, mejora efectivamente la eficiencia de entrenamiento; Tercero, a través de la profunda integración de la biblioteca de operadores de alto rendimiento MUDNN y la biblioteca de comunicación MCCL, la sobrecarga de comunicación de tareas intensivas en computación y múltiples tarjetas se optimiza sistemáticamente; Al mismo tiempo, combinado con la biblioteca Simumax de código abierto, la búsqueda de estrategia paralela se puede realizar automáticamente y el rendimiento de capacitación paralelo se puede maximizar para diferentes modelos y entornos de aceleración; Además, el mecanismo de recuperación de excepciones Rewind de Rewind incorporado del marco puede volver automáticamente al nodo estable reciente para el entrenamiento, mejorando en gran medida la estabilidad de la capacitación a gran escala; Finalmente, los dos marcos son compatibles con el ecosistema GPU convencional, lo que no solo garantiza la migración suave del ecosistema existente, sino que también proporciona un soporte subyacente para que los desarrolladores construyan su propia pila de tecnología AI.

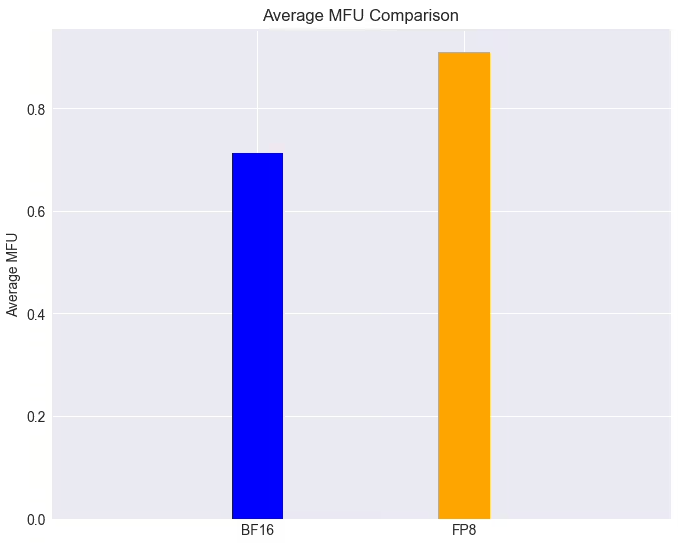

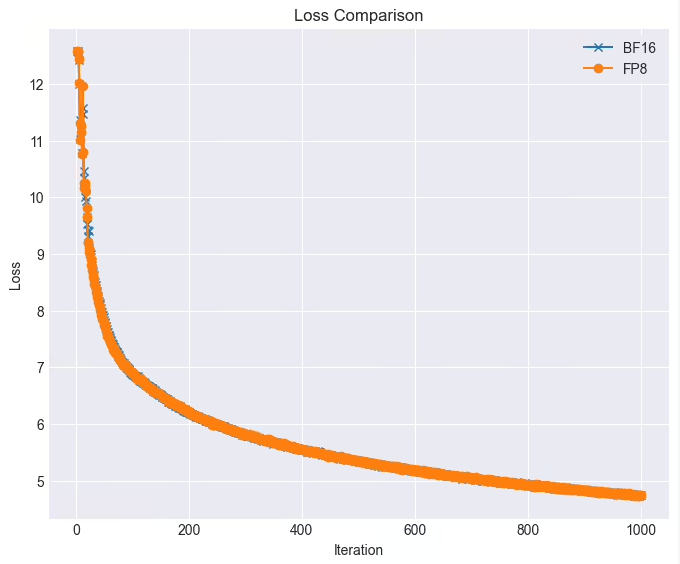

En aplicaciones prácticas, el rendimiento de estos dos marcos es impresionante. En un grupo de GPU de función completa, la tarea de entrenamiento del modelo LLAMA38B puede alcanzar más del 90% con la tecnología FP8 cuando la pérdida es casi sin pérdidas, que es un 28% más alta que la velocidad de entrenamiento original. Además, los hilos de Moore han sido profundamente integrados y de código abierto para apoyar eficientemente el algoritmo paralelo de Deepseek Dualpipe. Después de que MT-DualPipe está completamente conectado al marco MT-Megatron y el Marco MT-TransformerEngine, se ha realizado con éxito la reproducción completa del proceso de capacitación Deepseek V3, que respalda MLA, MTP y una variedad de estrategias de equilibrio de expertos. A través de una variedad de tecnologías de fusión del operador de transformadores, estos marcos han mejorado significativamente la utilización del ancho de banda de memoria, aliviaron efectivamente el cuello de botella unido a la memoria y lanzó aún más el potencial de hardware de las GPU nacionales.

Moore Threading dijo que continuará optimizando estos dos marcos y planes para introducir una serie de nuevas funciones: incluida la estrategia paralela de doble tubería/zerobubble para reducir aún más la velocidad de burbujas y mejorar la eficiencia del entrenamiento paralelo; una variedad de estrategias originales de optimización de FP8 para mejorar el rendimiento y la estabilidad del entrenamiento; Estrategias de punto de control asincrónico para mejorar la tolerancia y la eficiencia de fallas durante el entrenamiento; Estrategias de recomputación optimizadas para reducir la sobrecarga de la computación y la memoria y mejorar la velocidad de entrenamiento; Algoritmos originales de entrenamiento de fallas para mejorar la tolerancia a fallas durante el entrenamiento; e integrar las bibliotecas de Moore Hilf Flashmla y DeepGemm para liberar aún más la potencia informática y la potencia informática FP8 de las GPU de hilos Moore para mejorar de manera integral el rendimiento y la eficiencia de la computación.

Esta serie de avances tecnológicos y medidas de código abierto no solo demuestra la fuerza de Moore Hilt en el campo de la potencia informática de IA, sino que también abre nuevas posibilidades para el desarrollo de la infraestructura interna de IA. Esperemos y veamos más avances que trae en el campo del entrenamiento del modelo de IA.